Корреляционное отношение и индекс корреляции

Введенный выше коэффициент корреляции, как уже отмечено, является полноценным показателем тесноты связи лишь в случае линейной зависимости между переменными. Однако часто возникает необходимость в достоверном показателе интенсивности связи при любой форме зависимости.

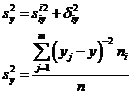

Для получения такого показателя вспомним правило сложения дисперсий:

(53, 54)

(53, 54)

— средняя групповых дисперсий

— средняя групповых дисперсий  , или остаточная диспепсия —

, или остаточная диспепсия —

(55, 56, 57) межгрупповая дисперсия

(55, 56, 57) межгрупповая дисперсия

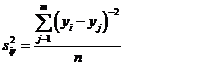

Остаточной дисперсией измеряют ту часть колеблемости Y, которая возникает из-за изменчивости неучтенных факторов, не зависящих от X. Межгрупповая дисперсия выражает ту часть вариации У, которая обусловлена изменчивостью X. Величина

(58)

(58)

получила название эмпирического корреляционного отношения У по X. Чем теснее связь, тем большее влияние на вариацию переменной доказывает изменчивость X.по сравнению с неучтенными факторами, тем выше nух. Величина nух. , называемая эмпирическим коэффициентом детерминации, показывает, какая часть общей вариацииУ обусловлена вариацией X. Аналогично вводится эмпирическое корреляционное отношение X по У:

(59)

(59)

Отметим основные свойства корреляционных отношений(при достаточно большом объеме выборки п):

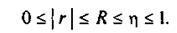

1.Корреляционное отношение есть неотрицательная величина, не превосходящая 1: 0< η < 1.

2. Если η = 0, то корреляционная связь отсутствует. Если η = 1, то между переменными существует функциональная зависимость.

3. η ух≠ η ху, т.е. в отличие от коэффициента корреляции r(для которого rху= rух = r) при вычислении корреляционного отношения существенно, какую переменную считать независимой, а какую — зависимой.

Эти свойства справедливы как для эмпирических корреляционных отношений n, так и для теоретических — R .

Эмпирическое корреляционное отношение η ух является показателем рассеяния точек корреляционного поля относительно эмпирической линии регрессии, выражаемой ломаной, соединяющей значения  . Однако в связи с тем, что закономерное изменение

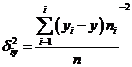

. Однако в связи с тем, что закономерное изменение  нарушается случайными зигзагами ломаной, возникающими вследствие остаточного действия неучтенных факторов, η ух преувеличивает тесноту связи. Поэтому наряду с η ух.рассматривается показатель тесноты связи Rух, характеризующий рассеяние точек корреляционного поля относительно линии регрессии ух (12.3). Показатель Rух получил название теоретического корреляционного отношения или индекса корреляции Y по X.

нарушается случайными зигзагами ломаной, возникающими вследствие остаточного действия неучтенных факторов, η ух преувеличивает тесноту связи. Поэтому наряду с η ух.рассматривается показатель тесноты связи Rух, характеризующий рассеяние точек корреляционного поля относительно линии регрессии ух (12.3). Показатель Rух получил название теоретического корреляционного отношения или индекса корреляции Y по X.

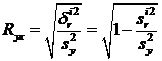

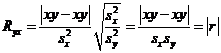

(60)

(60)

где дисперсии  и

и  определяются по формулам (54) —(56), в которых групповые средние

определяются по формулам (54) —(56), в которых групповые средние  , заменены условными средними

, заменены условными средними  , вычисленными по уравнению регрессии (16). Подобно Rух вводится и индекс корреляции X по Y

, вычисленными по уравнению регрессии (16). Подобно Rух вводится и индекс корреляции X по Y

(61)

(61)

Достоинством рассмотренных показателей η и R является то, что они могут быть вычислены при любой форме связи между переменными. Хотя η и завышает тесноту связи по сравнению с R, но для его вычисления не нужно знать уравнение регрессии. Корреляционные отношения η и R связаны с коэффициентом корреляции rследующим образом:

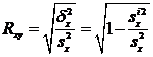

(62)

(62)

Можно показать, что в случае линейной модели (3), т.е. зависимости, yx-  =byx(x-

=byx(x-  ) индекс корреляции Rух равен коэффициенту корреляции r (по абсолютной ветчине): Ryx = | r |

) индекс корреляции Rух равен коэффициенту корреляции r (по абсолютной ветчине): Ryx = | r |

.

.

Коэффициент детерминации R2, равный квадрату индекса корреляции (для парной линейной модели — r2), показывает долю общей вариации зависимой переменной, обусловленной регрессией или изменчивостью объясняющей переменной. Чем ближе R2 к 1, тем теснее наблюдения примыкают к линии регрессии, тем лучше регрессия описывает зависимость переменных.

Расхождение между η2 и R2 (или r2) может быть использовано для проверки линейности корреляционной зависимости.

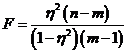

Проверка значимости корреляционного отношения η основана на том, что статистика

(63)

(63)

(где m — число интервалов по группировочному признаку) имеет F-распределение Фишера—Снедекора с k1=m — 1 и k2=n — m степенями свободы. Поэтому η значимо отличается от нуля, если F >Fα,, k1, k2, где Fα,, k1, k2— табличное значение F-критерия на уровне значимости α при числе степеней свободы k1 и k2.

Индекс корреляции R двух переменных значим, если значение статистики

(64)

(64)

больше табличного Fα,, k1, k2, где к1 = 1 и к.2 = п — 2.

МЕТОД НАИМЕНЬШИХ КВАДРАТОВ

Идея МНК основана на том, чтобы минимизировать сумму квадратов отклонений расчетных значений от эмпирических, т.е. нужно оценить параметры о функции f(a,x) таким образом, чтобы ошибки еi= уi-f(а,х), точнее - их квадраты, по совокупности были минимальными. Для этого нужно решить задачу минимизации суммы квадратов остатков S=e12+..+en2

Достоинства:

1. Наиболее простой метод выбора значений b1 и b2, чтобы остатки были минимальными;

2. При выполнении условий Гаусса-Маркова МНК-оценки будут наилучшими (наиболее эффективными) линейными (комбинации Yi) несмещёнными оценками параметров регрессии (b1 и b2).

Условия Гаусса-Маркова:

- модель линейна по параметрам и правильно специфицирована;

- объясняющая переменная в выборке имеет некоторую вариацию;

- математическое ожидание случайного члена равно нулю;

- случайный член гомоскедастичен;

- значения случайного члена имеют взаимно независимые распределения;

- случайный член имеет нормальное распределение

Недостатки: МНК-оценки являются эффективными линейными несмещёнными ТОЛЬКО при выполнении ВСЕХ условий Гаусса-Маркова, что на практике встречается редко.