Индекс корреляции, теоретическое корреляционное отношение. Коэффициент детерминации для нелинейных моделей. Применение МНК для нелинейных моделей.

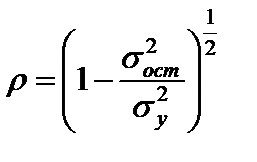

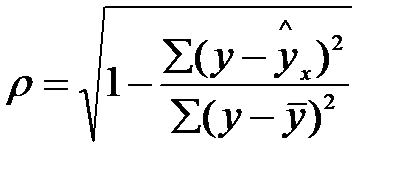

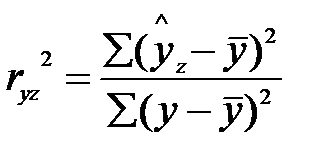

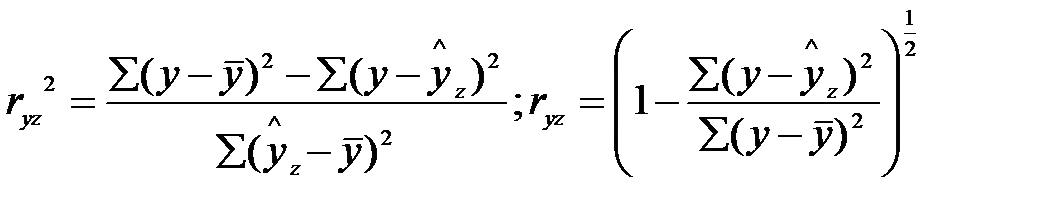

Индекс корреляции:

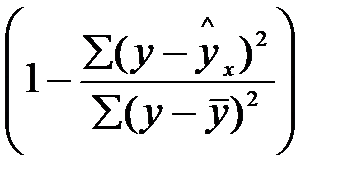

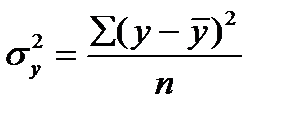

, где

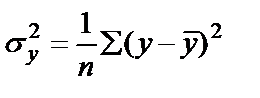

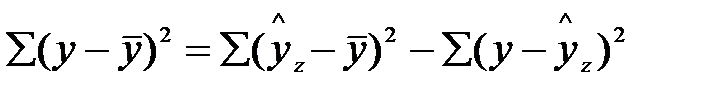

, где  - общая дисперсия результативного признака

- общая дисперсия результативного признака

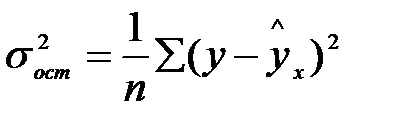

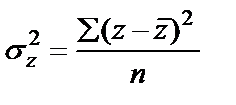

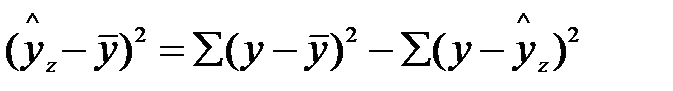

, где

, где  - остаточная дисперсия

- остаточная дисперсия

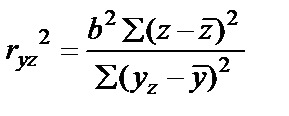

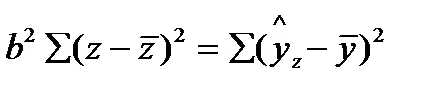

Т. к.  , а

, а  , то

, то

Чем ближе к 1, тем теснее связь рассматриваемых признаков, тем ближе к 1, тем теснее связь рассматриваемых признаков, тем более надёжно найдено уравнение регрессии.

Чем ближе к 1, тем теснее связь рассматриваемых признаков, тем ближе к 1, тем теснее связь рассматриваемых признаков, тем более надёжно найдено уравнение регрессии.

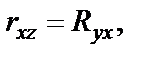

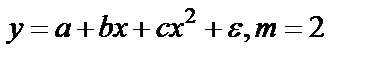

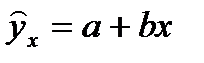

Парабола второй степени, как и полином более высокого порядка, при линеаризации принимает вид уравнения множественной регрессии. Если же нелинейное относительно объясняемой переменной УР при линеаризации принимает форму линейного уравнения парной регрессии, то для оценки тесноты связи может быть использован линейный коэффициент корреляции.

, где

, где  или

или

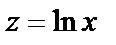

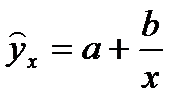

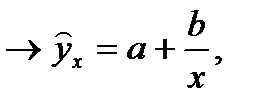

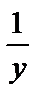

Например, равносторонняя гипербола  ,пусть

,пусть

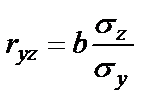

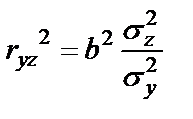

для которой

для которой  ;

;  ;

;  ,

,

или

но  ,

,  .

.

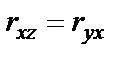

Но так как

, то

, то

.

.

Для линейной регрессии  , а при криволинейной зависимости

, а при криволинейной зависимости  .

.

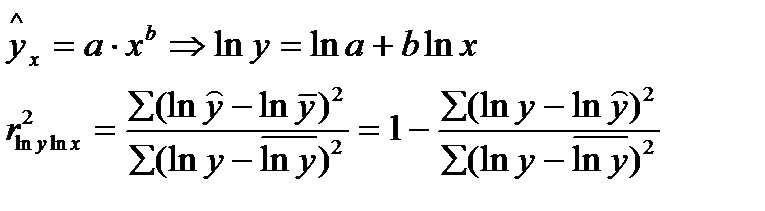

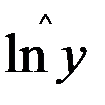

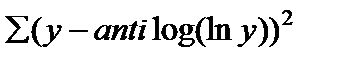

Для R используется сумма квадратов, а не их логарифмов. С этой целью определяется теоретические значения результативного признака, то есть  как антилогарифм рассчитываемый по уравнению величины

как антилогарифм рассчитываемый по уравнению величины  и остальная сумма квадрата как

и остальная сумма квадрата как  .

.

Поскольку в расчёте индекса корреляции используется отношение факторной и общей суммы квадратов, то R2 имеет тот же смысл, что и коэффициент детерминации. Поэтому R2 для нелинейных связей называется индексом детерминации. Расчет и оценка аналогично линейной корреляции.

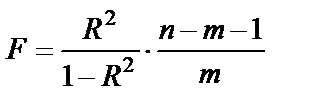

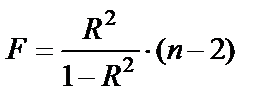

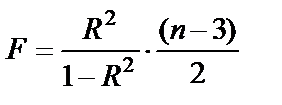

Индекс детерминации используется для проверки существенности уравнения нелинейной регрессии в целом по F-критерию:

n – число наблюдений

m – число параметров при переменной х или ч.с.с. факторной суммы квадратов.

n-m-1 – ч.с.с. остаточной суммы квадратов.

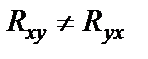

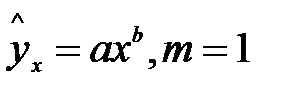

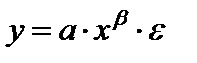

Например для степенной функции

для параболы

.

.

Расчет F-критерия можно проводить по таблице дисперсионного анализа как рассматривали ранее.

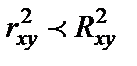

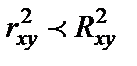

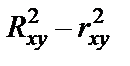

Индекс детерминации  можно сравнивать с коэффициентом детерминации

можно сравнивать с коэффициентом детерминации  для обоснования возможности применения линейной функции. Чем больше кривизна линии регрессии, тем

для обоснования возможности применения линейной функции. Чем больше кривизна линии регрессии, тем  <

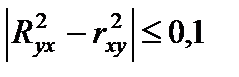

<  . Близость этих показателей означает, что нет необходимости усложнять форму уравнения регрессии и можно использовать линейную функцию. Практически если

. Близость этих показателей означает, что нет необходимости усложнять форму уравнения регрессии и можно использовать линейную функцию. Практически если  не превышает 0,1, то предположение о линейной форме связи считается оправданным. В противном случае проводится оценка существенности различия

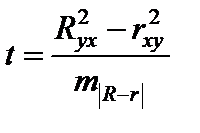

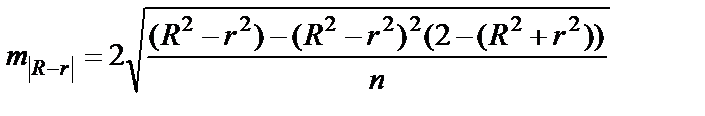

не превышает 0,1, то предположение о линейной форме связи считается оправданным. В противном случае проводится оценка существенности различия  по критерию Стьюдента.

по критерию Стьюдента.

- ошибка разности между

- ошибка разности между  и

и

Если  >

>  , то различия существенны и замена нелинейной регрессии уравнением линейной функции невозможна.

, то различия существенны и замена нелинейной регрессии уравнением линейной функции невозможна.

Если t<2, то различия между  и

и  несущественны, и возможно применение линейной регрессии.

несущественны, и возможно применение линейной регрессии.

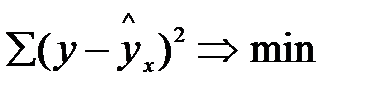

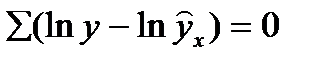

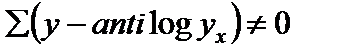

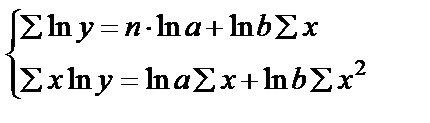

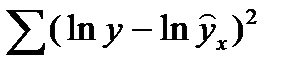

В моделях, нелинейных по оцениваемым параметрам, приводимых к линейному виду, МНК применяется к преобразованным уравнениям. Если в моделях и линейных, нелинейных по переменным, при оценке параметров исходят из критерия  , то в моделях нелинейных по оцениваемым параметрам, требование МНК применяется не к исходным данным результативного признака, а к их преобразованным величинам, то есть

, то в моделях нелинейных по оцениваемым параметрам, требование МНК применяется не к исходным данным результативного признака, а к их преобразованным величинам, то есть  ,

,  . Так в степенной функции

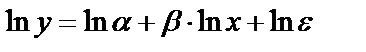

. Так в степенной функции  МНК применяется к преобразованному уравнению

МНК применяется к преобразованному уравнению  .

.

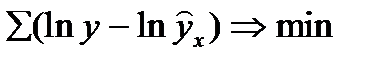

Это означает, что оценка параметров основывается на минимальной сумме квадратов отклонений в логарифмах

.

.

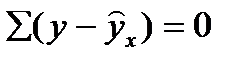

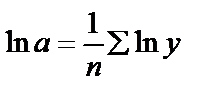

Соответственно если в линейных моделях (включая нелинейные по переменным)  , то в моделях, нелинейных по оцениваемому параметру:

, то в моделях, нелинейных по оцениваемому параметру:

, а

, а  .

.

Вследствие этого, оценка параметров для линеаризуемых функций МНК оказывается несколько смещенной.

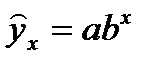

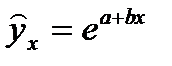

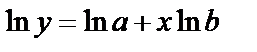

Например,  (показательная кривая) или

(показательная кривая) или  (экспонента). Прологарифмируем,

(экспонента). Прологарифмируем,

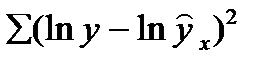

Применяя МНК, минимизируем

.

.

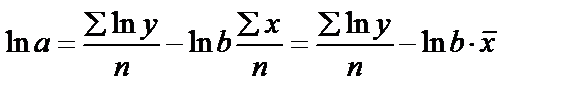

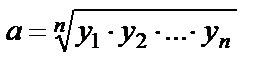

Пусть  . Тогда

. Тогда  или

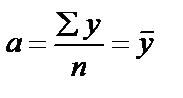

или  , то есть параметр а – есть средняя геометрическая значений у; а в линейной зависимости

, то есть параметр а – есть средняя геометрическая значений у; а в линейной зависимости  , при

, при  .

.  - то есть среднее арифметическое.

- то есть среднее арифметическое.

Так как среднее арифметическое больше среднегеометрического, то оценки, полученные из минимизации  будут несколько смещены (занижены).

будут несколько смещены (занижены).

Выбор функции. Тесты Бокса-Кокса.

Возможность построения нелинейных моделей, как с помощью их приведения к линейному виду, так и путем использования нелинейной регрессии, значительно повышают универсальность регрессионного анализа, но и усложняют задачу исследователя.

Если вы ограничиваетесь парным регрессионным анализом, то можно построить поле корреляции, график y(x) как диаграмму разброса. Однако обычно все не так просто. Часто несколько разных нелинейных функций соответствуют наблюдениям, если они лежат на некоторой кривой.

При рассмотрении альтернативных моделей с одним и тем же определением зависимой переменной процедура выбора достаточно проста. Наиболее разумным является оценивание регрессии на основе всех вероятных функций, которые можно вообразить, и выбор функции, в наибольшей степени объясняющей изменения зависимой переменной.

Если в примере мы получили, что линейная функция объясняет 64% дисперсии «у», а гиперболическая – 99,9%, то без колебаний (R2yx) выбираем последнюю.

Однако разные модели используют разные функциональные формы, то проблема выбора модели становится более сложной, так как нельзя непосредственно сравнить коэффициенты R2yx или суммы квадратов отклонений, т.е нельзя сравнивать статистически для линейного и логарифмических вариантов модели

Еще пример:

Линейная регрессия R2 = 0,985. СКО= 385,2

Двойная логарифмическая модель R2 = 0,9915, СКО = 0,02

Во втором случае СКО значительно меньше, но это ничего не решает. Значение log y< значительно меньше соответствующих значений у, поэтому и остатки меньше. Величина R2 безразмерна и во втором уравнении относится к разным понятиям. Во первом измеряет объясненную регрессией долю дисперсии, во втором - объясненную регрессией долю дисперсии log y. Если для одной модели R2 значительно больше, чем для другой, можно сделать оправданный выбор. Если же R21 @ R22 то проблема выбора усложняется. Для этого используют тест Бокса-Кокса.

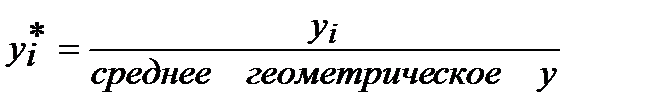

Сравнения у и log y использует вариант теста, разработанного Полном Зарембой. Он предположил такое преобразование масштаба наблюдений у, при котором обеспечивалась бы возможность непосредственного сравнения СКО в линейной и логарифмической моделях. Процедура заключается в следующем:

1. Вычисляется среднее геометрическое значение у в выборке ( оно совпадает с экспонентой среднего арифметического log y, поэтому если вы уже оценили логарифмическую регрессию, то необходимо вычислить лишь экспоненту от этого значения).

2. Пересчитываются наблюдения у, они делятся на это значение, т.е (масштабируется):

- пересчитанное значение для i наблюдения.

- пересчитанное значение для i наблюдения.

3. Оценивается регрессия для линейной модели с использованием  вместо у в качестве зависимой переменной и для логарифмической модели с использованием log (

вместо у в качестве зависимой переменной и для логарифмической модели с использованием log (  ) вместо log(у); во всех других отношениях модели должны оставаться неизменными. Теперь, значение СКО для двух регрессий сравнимы, и следовательно, модель с меньшей суммой квадратов отклонений обеспечивает лучше соответствующее.

) вместо log(у); во всех других отношениях модели должны оставаться неизменными. Теперь, значение СКО для двух регрессий сравнимы, и следовательно, модель с меньшей суммой квадратов отклонений обеспечивает лучше соответствующее.

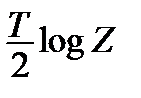

4.Для того, чтобы проверить, не обеспечивает ли одна из моделей значимо лучше соответствующее можно вычислить величину  , где Т- число наблюдений, Z- отношение значений СКО в пересчитанных регрессий, и взять ее абсолютное значение (т.е игнорировать знак «-» если он имеется.). Эта статистика имеет распределение c2 с одной степенью свободы. Если она превышает критерий- значение c2 при выбранном уровне значимости, то делается вывод о наличии значимой разницы в качестве оценивания.

, где Т- число наблюдений, Z- отношение значений СКО в пересчитанных регрессий, и взять ее абсолютное значение (т.е игнорировать знак «-» если он имеется.). Эта статистика имеет распределение c2 с одной степенью свободы. Если она превышает критерий- значение c2 при выбранном уровне значимости, то делается вывод о наличии значимой разницы в качестве оценивания.

Пример: тест о расходах на продукты питания так и расходах на жилье в США. Для этих двух видов благ показали, что логарифмическая регрессия – среднее значение log(у) = 4,8422 (1) и 4,6662 (2). Масштабирующие множители равны e4.8422 и e4,6662

| СКО | расходы на питание | расходы на жилье |

| линейная регрессия | 0,0119 | 0,0341 |

| двойная логарифмическая регрессия. | 0,0119 | 0,0221 |

Из таблицы очевидно, что для регрессии расходов на питание соответствие одинаково хорошо в обоих случаях. В случае расходов на жилье, логарифмическая регрессия дает более точное соответствие логарифмического отношения значений СКО для вторых регрессией = 0,4337, и после умножения на 12,5 регрессий t = 4,52. Критерий- уровень c2 с одной степенью свободы составит 3,84 при 5% уровне значимости и 6,64 при 1%.

Эти результаты могут показаться неожиданными, так как можно предположить, что с точки зрения теории модель с log является более совершенной. Однако период выборки настолько мал, что кривизна функции Энгеля, вероятно не успеет проявиться, поэтому линейная функция может обеспечить столь же хорошее соответствие, что и нелинейная.