Мультиколлинеарность факторов, экономическая сущность

Мультиколлинеарность - линейная взаимосвязь двух или нескольких объясняющих переменных. Причем, если объясняющие переменные связаны строгой функциональной зависимостью, то говорят о совершенной мультиколлинеарности. На практике можно столкнуться с очень высокой (или близкой к ней) мультиколлинеарностью - сильной корреляционной зависимостью между объясняющими переменными.

Суть мультиколлинеарности:

Мультиколлинеарность может быть проблемой - в случае множественной регрессии. Её суть можно представить на примере совершенной мультиколлинеарности.

Пусть уравнение регрессии имеет вид Y= β0+ β1×X1+ β2×X2+ε (1)

Пусть также между объясняющими переменными существует строгая линейная зависимость: X2= γ0+γ1×X1 (2)  Подставив (2) в (1), получим:

Подставив (2) в (1), получим:

Y= β0+ β1×X1+ β2×( γ0+γ1×X1 ) + ε или Y= (β0+ β2× γ0) +(β1+ β2× γ1)X1 + ε

Обозначив β0+ β2× γ0=a, β1+ β2× γ1=b получаем уравнение парной линейной регрессии:

Y= a +b×X1 + ε (3)

Определяем коэффициенты а и b. Получим систему двух уравнений (4):

Определяем коэффициенты а и b. Получим систему двух уравнений (4):

β0+ β2× γ0=a

β1+ β2× γ1=b

В систему (4) входят три неизвестные β0, β1,β2 (коэффициенты γ0 и γ1 определены в (2)). Такая система в подавляющем числе случаев имеет бесконечно много решений. Таким образом, совершенная мультиколлинеарность не позволяет однозначно определить коэффициенты регрессии уравнения (1) и разделить вклады объясняющих переменных X1 и X2 в их влиянии на зависимую переменную У. В этом случае невозможно сделать обоснованные статистические выводы об этих коэффициентах. Следовательно в случае мультиколлинеарности выводы по коэффициентам и по самому уравнению регрессии будут ненадежными.

Совершенная мультиколлинеарность является скорее теоретическим примером. Реальна же ситуация, когда между объясняющими переменными существует довольно сильная корреляционная зависимость, а не строгая функциональная. Такая зависимость называется несовершенной мультиколлинеарностью. Она характеризуется высоким коэффициентом корреляции ρ между соответствующими объясняющими переменными. Причем, если значение ρ по абсолютной величине близко к единице, то говорят о почти совершенной мультиколлинеарности. В любом случае мультиколлинеарность затрудняет разделение влияния объясняющих факторов на поведение зависимой переменной и делает оценки коэффициентов регрессии ненадежными Данный вывод наглядно подтверждается с помощью диафаммы Венна (рис. 1).

Совершенная мультиколлинеарность является скорее теоретическим примером. Реальна же ситуация, когда между объясняющими переменными существует довольно сильная корреляционная зависимость, а не строгая функциональная. Такая зависимость называется несовершенной мультиколлинеарностью. Она характеризуется высоким коэффициентом корреляции ρ между соответствующими объясняющими переменными. Причем, если значение ρ по абсолютной величине близко к единице, то говорят о почти совершенной мультиколлинеарности. В любом случае мультиколлинеарность затрудняет разделение влияния объясняющих факторов на поведение зависимой переменной и делает оценки коэффициентов регрессии ненадежными Данный вывод наглядно подтверждается с помощью диафаммы Венна (рис. 1).

На рис. 1. а) коррелированность между объясняющими переменными X1 и X2 отсутствует и влияние каждой из них на Y находит отражение в наложении кругов X1 и X2 на круг Y. По мере усиления линейной зависимости между X1 и X2 соответствующие круги все больше накладываются друг на друга. Заштрихованная область отражает совпадающие части влияния X1 и X2 на Y. На рис. 1б при совершенной мультиколлинеарности невозможно разграничить степени индивидуального влияния объясняющих переменных X1 и X2 на зависимую переменную Y.

Последствия мультиколлинеарности:

Обычно выделяются следующие последствия мультиколлинеарности:

1. Большие дисперсии (стандартные ошибки) оценок. Это затрудняет нахождение истинных значений определяемых величин и расширяет интервальные оценки, ухудшая их точность.

2. Уменьшаются t-статистики коэффициентов, что может привести к неоправданному выводу о существенности влияния соответствующей объясняющей переменной на зависимую переменную.

3. Оценки коэффициентов по MIIK и их стандартные ошибки становятся очень чувствительными к малейшим изменениям данных, т. е. они становятся неустойчивыми.

4. Затрудняется определение вклада каждой из объясняющей переменных в объясняемую уравнением регрессии дисперсию зависимой переменной.

5. Возможно получение неверного знака у коэффициента регрессии.

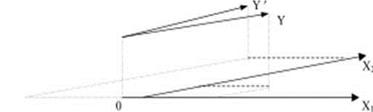

Причину последствий 3, 4 можно наглядно проиллюстрировать на примере регрессии (1) - как проекцию вектора Y на плоскость векторов X1 и X2. Если между этими векторами существует тесная линейная зависимость, то угол между векторами X1 и X2 мал. В силу этого операция проектирования становится неустойчивой: небольшое изменение в исходных данных может привести к существенному изменению оценок. На рис. 2 векторы Y и Y' различаются незначительно, но в силу малого угла между X1 и X2 координаты векторов Y и Y' не только значительно различаются по величине, но и по знаку.

Определение мультиколлинеариости (признаки, по которым м.б. установлено наличие):

1. Коэффициент детерминации R2 достаточно высок, но некоторые из коэффициентов регрессии статистически незначимы, т.е. они имеют низкие t-статисгики.

2. Парная корреляция между малозначимыми объясняющими переменными достаточно высока. Данный признак будет надежным лишь в случае двух объясняющих переменных. При большем их количество более целесообразным является использование частных коэффициентов корреляции.

3. Высокие частные коэффициенты корреляции.

Частные коэффициенты корреляции определяют силу линейной зависимости между двумя переменными без учета влияния на них других переменных. Однако при изучении многомерных связей в ряде случаев парные коэффициенты корреляции могут давать совершенно неверные представления о характере связи между двумя переменными. Например, между двумя переменными X и Y может быть высокий положительный коэффициент корреляции не потому, что одна из них стимулирует изменение другой, а оттого, что обе эти переменные изменяются в одном направлении под влиянием других переменных, как учтенных в модели, так и, возможно, неучтенных. Поэтому имеется необходимость измерять действительную тесноту линейной связи между двумя переменными, очищенную от влияния на рассматриваемую пару переменных других факторов. Коэффициент корреляции между двумя переменными, очищенными от влияния других переменных, называется частным коэффициентом корреляции.

4) Сильная вспомогательная (дополнительная регрессия)

Мультиколлинеарность может иметь место вследствие того, что какая-либо из объясняющих переменных является линейной комбинацией других объясняющих переменных. Для данного анализа строятся уравнения регрессии каждой из объясняющих переменных Xj, где j=1,2 …,m на оставшиеся объясняющиеся переменные вспомогательные регрессии. Вычисляются соответствующие коэффициенты детерминации  и рассчитывается их статистическая значимость на основе F-статистики

и рассчитывается их статистическая значимость на основе F-статистики

n – число наблюдений, m – число объясняющих переменных в первоначальном уравнении регрессии. Статистика F имеет распределение Фишера с ν1=m-1 и ν1=n-m степенями свободы. Если

n – число наблюдений, m – число объясняющих переменных в первоначальном уравнении регрессии. Статистика F имеет распределение Фишера с ν1=m-1 и ν1=n-m степенями свободы. Если  статически не значим, то Xj не является линейной комбинацией других переменных и её можно оставить в уравнении регрессии. Иначе, есть основания считать, что Xj существенно зависти от других объясняющих переменных и имеет место мультиколлинеарность.

статически не значим, то Xj не является линейной комбинацией других переменных и её можно оставить в уравнении регрессии. Иначе, есть основания считать, что Xj существенно зависти от других объясняющих переменных и имеет место мультиколлинеарность.