Метод наименьших квадратов. Вывод формул метода наименьших квадратов для парного случая. Суть метода, графическое представление, условия применения

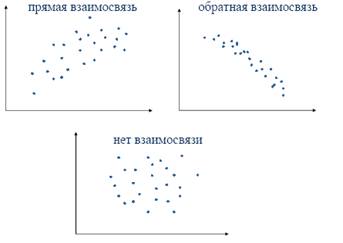

Понятие регрессии. Модель парной линейной регрессии. Диаграмма рассеяния и проблема выбора линии регрессии. Природа случайного члена регрессии

Регрессионный анализ – позволяет оценить и проанализировать формулу зависимости одной переменной от других.

Линейная парная модель

Уравнение регрессии:

y = β0 + β1x + ε

β1 – показывает, на сколько изменится значение зависимой переменной y при изменении объясняющей переменной x на единицу.

β0 – показывает среднее значение зависимой переменной y при нулевом значении объясняющей переменной x. Не всегда имеет экономический смысл. (компонент)

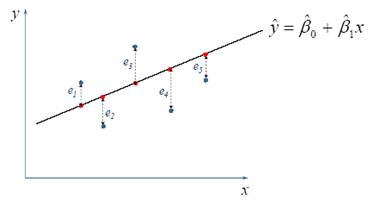

Проблема выбора линии заключаеться в том, что надо её максимально описать зависимость, чтобы по минимуму были отклонения.

Природа случайного члена регрессионной модели

1. Невключение объясняющих переменных

2. Неправильная функциональная спецификация модели

3. Случайность поведения рассматриваемых объектов

4. Ошибки измерения

Метод наименьших квадратов. Вывод формул метода наименьших квадратов для парного случая. Суть метода, графическое представление, условия применения

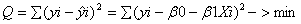

Метод наименьших квадратов — метод нахождения оптимальных параметров линейной регрессии, таких, что сумма квадратов ошибок (регрессионных остатков) минимальна.

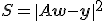

Метод заключается в минимизации евклидова расстояния  между двумя векторами -- вектором восстановленных значений зависимой переменной и вектором фактических значений зависимой переменной.

между двумя векторами -- вектором восстановленных значений зависимой переменной и вектором фактических значений зависимой переменной.

Применение. Задача метода наименьших квадратов состоит в выборе вектора  , минимизирующего ошибку

, минимизирующего ошибку  .

.

Метод наименьших квадратов имеет следующие преимущества:

- не требуется знания закона распределения случайного возмущения

- дает оценки по крайней мере состоятельные

- в случае нормального распределения случайного возмущения оценки параметров линейной модели несмещенные и эффективные

Formula:

4. Свойства оценок коэффициентов регрессии, полученных с помощью метода наименьших квадратов. Теорема Гаусса-Маркова - формулировка, смысл теоремы. Условия Гаусса-Маркова и последствия их нарушения

Теорема Гаусса—Маркова

оценки по обычному методу наименьших квадратов являются не только несмещенными оценками коэффициентов регрессии, но и наиболее эффективными в том случае, если выполнены условия Гаусса—Маркова. С другой стороны, если условия Гаусса—Маркова не выполнены, то, вообще говоря, можно найти оценки, которые будут более эффективными по сравнению с оценками, полученными обычным методом наименьших квадратов. В данной работе не приводится общее рассмотрение этих вопросов. Тем не менее в том случае, если условия Гаусса—Маркова для остаточного члена выполнены, коэффициенты регрессии, построенной обычным методом наименьших квадратов, будут наилучшими линейными несмещенными оценками (best linear unbiased estimators, или BLUE): несмещенными, как уже было показано; линейными, так как они являются линейными функциями значений у; наилучшими, так как они являются наиболее эффективными в классе всех несмещенных линейных оценок. Теорема Гаусса—Маркова доказывает это (краткое изложение, не использующее матричной алгебры, дано в работе Дж. Томаса

для того чтобы регрессионный анализ, основанный на обычном методе наименьших квадратов, давал наилучшие из всех возможных результаты, случайный член должен удовлетворять четырем условиям, известным как условия Гаусса—Маркова.

1-е условие Гаусса—Маркова: E(Ut) = 0 для всех наблюдений. Первое условие состоит в том, что математическое ожидание случайного члена в любом наблюдении должно быть равно нулю. Иногда случайный член будет положительным, иногда отрицательным, но он не должен иметь систематического смещения ни в одном из двух возможных направлений. Vipolnjaetsja avtomaticeski,esli urava soderzit konstantu

2-е условие Гаусса—Маркова: pop. var (u) постоянна для всех наблюдений. Второе условие состоит в том, что дисперсия случайного члена должна быть постоянна для всех наблюдений. Иногда случайный член будет больше, иногда меньше, однако не должно быть априорной причины для того, чтобы он порождал большую ошибку в одних наблюдениях, чем в других. Одна из задач регрессионного анализа состоит в оценке стандартного отклонения случайного члена. Если рассматриваемое условие не выполняется, то коэффициенты регрессии, найденные по обычному методу наименьших квадратов, будут неэффективны. Narushenie privodit k geteroskedasticnosti

3- е условие Это условие предполагает отсутствие систематической связи между значениями случайного члена в любых двух наблюдениях. Например, если случайный член велик и положителен в одном наблюдении, это не должно обусловливать систематическую тенденцию к тому, что он будет большим и положительным в следующем наблюдении (или большим и отрицательным, или малым и положительным, или малым и отрицательным). Случайные члены должны быть абсолютно независимы друг от друга. Narushenie privodit k avtokorreljacii

4-е условие случайный член должен быть распределен независимо от объясняющих переменных В большинстве глав книги мы будем в сущности использовать более сильное предположение о том, что объясняющие переменные не являются стохастическими, т. е. не имеют случайной составляющей. Значение любой независимой переменной в каждом наблюдении должно считаться экзогенным, полностью определяемым внешними причинами, не учитываемыми в уравнении регрессии. Если это условие выполнено, то теоретическая ковариация между независимой переменной и случайным членом равна нулю. Дело в том, что если случайный член и нормально распределен, то так же будут распределены и коэффициенты регрессии.

Предположение о нормальности основывается на центральной предельной теореме. В сущности, теорема утверждает, что если случайная величина является общим результатом взаимодействия большого числа других случайных величин, ни одна из которых не является доминирующей, то она будет иметь приблизительно нормальное распределение, даже если отдельные составляющие не имеют нормального распределения.