Визуальное интерактивное дешифрирование 3 страница

Тем не менее, для ряда задач априорные вероятности могут иметь важное значение. Например, при дистанционном мониторинге некоторой территории, на которой наблюдается определенное количество классов с известными р(х/Ωs). В этом случае в результате итеративного процесса классификации с априорными вероятностями Pi(Ωs)=Sj.i(A), где i -очередной шаг итерации, a Si-1(Ωs) - доля площади под классом Ωs, полученная на i-1-м шаге, можно получить наиболее близкие к истинным значения площадей под классами [28].

В Эрдасе максимум правдоподобия:

Для выбора решающего правила в первую очередь воспользуемся функцией редактора сигнатур Feature> Objects.Посмотрите, как располагаются гиперпараллелепипеды и эллипсоиды рассеяния Ваших сигнатур во всех проекциях признакового пространства. Если они не перекрываются, Вы можете использовать простейшее непараметрическое решающее правило гиперпараллелепипедов. Остается только решить, куда и как относить те точки, которые не попадают ни в какой гиперпараллелепипед.

В окне функции Supervised Classificationдля этого случая нужно задать режим Unclassified Rule.Как Вы уже, вероятно, поняли, важное различие между непараметрическими и параметрическими правилами состоит в том, что если в первом случае область принятия решения в пользу каждого класса строго ограничена, то во втором она ограничена только разделяющими функциями dkl(x) для каждой пары классов Ak и Al. То есть все точки будут, так или иначе, расклассифицированы, независимо от того, попадают они или нет в гиперпараллелепипед или эллипсоид рассеяния какого-то класса. На случай, если гиперпараллелепипеды Ваших классов все-таки где-то перекрываются, необходимо задать правило принятия решения при перекрытии (Overlap Rule). Для этого случая расстояние Махаланобиса, как и максимум правдоподобия, практически всегда оказываются эффективными.

Для максимума правдоподобия можно также задать априорные вероятности (поле Prob. в редакторе сигнатур), чтобы нужным образом сдвинуть границы между классами. При классификации в этом случае нужно указать режим Use Probabilities.

В качестве правила классификации при перекрытии можно также задать свои собственные приоритеты классов (поле Order в редакторе сигнатур). В этом случае при перекрытии гиперпараллелепипедов (или, соответственно, областей в признаковом пространстве для непараметрического правила Feature Space) пиксель будет относится к тому классу, приоритет которого выше. Например, при перекрытии классов 2 и 5 точка будет отнесена к классу 2.

Статистическая классификация при гипотезе нормального распределения значений признаков внутри классов. Последствия нарушения этой гипотезы на наборах обучающих данных. Методы проверки обучающих выборок на соответствие гипотезе о нормальном законе распределения средствами пакета ERDAS Imagine.

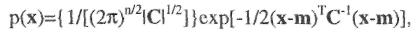

При использовании гипотезы о нормальном распределении значений признаков метод максимума правдоподобия отличается от классификации по расстоянию Махаланобиса только наличием априорных вероятностей появления классов в соответствии с формулой Байеса. Если же в максимуме правдоподобия используются равные априорные вероятности, то эти два метода ничем не отличаются. На рис. 13 показано тематическое признаковое пространство для результата классификации подмножества каналов {2,3,4} изображения tm_860516.img на 5 классов, сигнатуры которых отображены в левом окне. Слева - классификация по максимуму правдоподобия, справа -по расстоянию Махаланобиса.

В целом метод максимума правдоподобия наиболее универсален. Единственная проблема состоит в том, что далеко не всегда сигнатуры выделяемых классов могут быть аппроксимированы нормальным распределением. В случае, когда гистограмма сигнатуры класса одномодальна и ее ассиметрия невелика, такая гипотеза работает достаточно хорошо. Однако при наличии в гистограмме нескольких мод в процессе классификации могут возникнуть дополнительные ошибки.

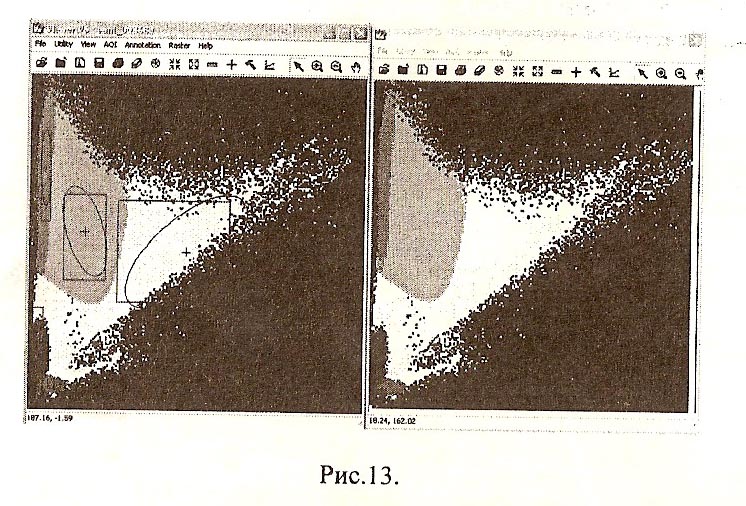

Для оценки взаимного положения сигнатур можно также построить гистограммы по каналам для каждой сигнатуры и для групп сигнатур (рис.19). Это поможет вам оценить, насколько правомерна гипотеза о нормальном распределении для выбранных сигнатур и в каких интервалах значений наиболее вероятна ошибочная классификация. Для построения гистограмм используйте соответствующую кнопку в редакторе сигнатур. После изменения какого-либо параметра (канала, цвета, количества выбранных сигнатур при отображении группы) необходимо нажать кнопку Plotв окне Histogram Plot Control Panelдля обновления рисунка.

Для оценки взаимного положения сигнатур можно также построить гистограммы по каналам для каждой сигнатуры и для групп сигнатур (рис.19). Это поможет вам оценить, насколько правомерна гипотеза о нормальном распределении для выбранных сигнатур и в каких интервалах значений наиболее вероятна ошибочная классификация. Для построения гистограмм используйте соответствующую кнопку в редакторе сигнатур. После изменения какого-либо параметра (канала, цвета, количества выбранных сигнатур при отображении группы) необходимо нажать кнопку Plotв окне Histogram Plot Control Panelдля обновления рисунка.

Сформируйте свой набор сигнатур и проанализируйте их с помощью изученных Вами средств ERDAS Imagine. Постарайтесь добиться, чтобы для них была приемлема гипотеза о нормальном распределении (см. гистограммы на рис.19), Оцените их взаимное положение в пространстве признаков и убедитесь, что выбранные Вами классы достаточно полно отображают основные тематические категории, представленные на изображении. В противном случае Вы едва ли получите при классификации правдоподобно интерпретируемый результат.

16. Меры статистической разделимости обучающих выборок для статистической классификации, их характеристика и обоснование использования. Меры статистической разделимости в пакете ERDAS Imagine. Проверка качества обучения на тестовых участках.

Обучение классификаторов - задача достаточно сложная, и ее особенности существенно зависят от сферы приложения алгоритма. В общем случае необходимо проведение целого ряда исследований: прежде всего, выбор гипотезы о типе статистического распределения используемых признаков в каждом из классов и затем проверка этой гипотезы на репрезентативных выборках по объектам исследования. В тематической обработке многозональных аэрокосмических изображений это один из самых проблематичных этапов. Помимо ограничений конкретного алгоритма классификации, результат, который мы получаем на выходе, зависит еще и от следующих факторов.

1. От способа синтеза изображения при выводе на экран и особенностей палитры. В процессе синтеза так или иначе происходит некоторая потеря информации, обусловленная самой математической моделью

процесса. Кроме того, индивидуальные особенности восприятия человеком цветовой гаммы влияют на способность аналитика различать объекты исследования и, следовательно, на процесс формирования обучающих выборок.

2. От достоверности наземных данных, в том числе от способа их сбора и точности координатной привязки тестовых участков к изображению. Даже при разрешении цифрового на местности 30-50м мы едва ли сможем строго привязать точечные измерения. Следовательно, для надежного обучения классификатора необходимы тестовые участки с высокой степенью пространственной однородности. При работе с материалами наземных обследований это еще один довод в пользу двухэтапной схемы обработки: сначала выполнение неконтролируемой классификации с целью выбора однородных участков для получения наземных данных, потом проведение наземных обследований, затем классификация с обучением. В настоящее время, однако, такой схемой пользуются редко из-за высокой стоимости детальных наземных обследований и ищут другие пути решения этой проблемы.

3. Наконец, от количества и способа расположения обучающих выборок на изображении. Изменчивость спектральных отражательных свойств объектов земной поверхности даже в пределах одного изображения может оказаться очень высокой. Кроме факторов, обусловленных условиями съемки и учитывающихся в процессе нормализации изображений, на отражательные характеристики объектов могут повлиять такие факторы, как ветер, осадки и т.п.

Предположим, тем не менее, что мы получили вполне надежные обучающие выборки и рассчитали параметры функций плотности распределения для всех классов. Каким способом можно оценить возможности удовлетворительной классификации конкретных данных при выбранных описаниях классов, то есть ожидаемые вероятности ошибок? Для этой цели используется такое понятие, как статистическая разделимость.

Статистическая разделимость классов- это некоторая функциональная характеристика, известным образом связанная с вероятностью ошибки классификации.

Как мы уже видели при рассмотрении статистического классификатора, вероятность ошибки при разделении пары классов связана с площадью перекрытия их функций плотности распределения.

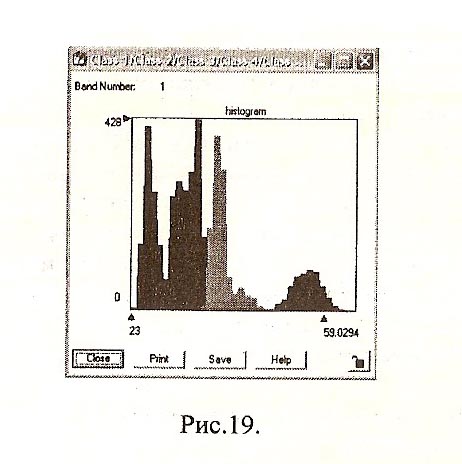

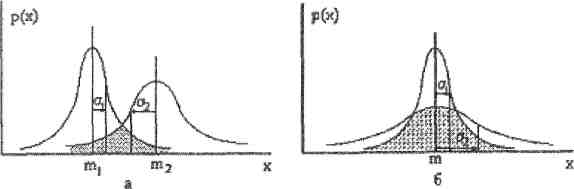

Ясно, что при различных средних значениях m1 и m2 (рис. 8.3, а) вероятность ошибки убывает при увеличении расстояния между средними. Поэтому для классов с различными средними можно использовать такую меру статистической разделимости, как нормализованное расстояние:

Рис.8.3. Ошибки классификации при разных средних значениях признака (а) и одинаковых средних (б).

Величина Rn связана обратной зависимостью с вероятностью ошибок: она возрастает как с увеличением расстояния между средними, так и с уменьшением дисперсии внутри классов. Для нормальных распределений эта величина принимает значение Rn=l "на уровне одного а", то есть когда функции плотности распределения соприкасаются в точках перегиба: |m1-m2l=σ1+σ2. На этом уровне при равных априорных вероятностях появления классов вероятность ошибок классификации (заштрихованная площадь) е=0.33. Это обычно считается верхней границей допустимой величины ошибки, то есть результат уже поддается интерпретации и постклассификационной обработке.

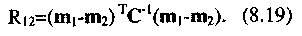

Для многомерного случая (при C1= C2= С, m1≠m2) иногда используется квадратичное расстояние Махаланобиса между векторами средних значений, которое для нормальных распределений иначе называют расстоянием между плотностями распределения:

Расстояние (8.19) также обратно пропорционально ожидаемой величине ошибки.

Недостатки мер такого типа проявляются в случаях, когда средние значения для двух классов совпадают (рис.8.3, б). Поэтому для обработки всех ситуаций необходима мера более универсальная. Таковой является например, попарная дивергенция,позволяющая учесть соотношения между значениями плотностей распределения двух классов в каждой точке х.

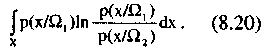

Дивергенция определяется через так называемое среднее количество различающей информации.

Средним количеством различающей информации для класса Ω1 относительно класса Ω2 называется величина

Аналогично можно записать среднее количество различающей информации для класса Ω2 относительно класса Ω1 Тогда полное среднее количество различающей информации для пары классов Ω1 и Ω2 будет выглядеть так:

(8.21)

Величина D12 называется дивергенцией. Как видно из формулы (8.21), дивергенция включает само отношение правдоподобия и его логарифм, то есть учитывает расстояние между функциями правдоподобия в каждой точке пространства X и их соотношение.

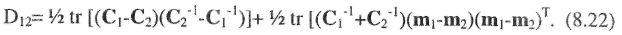

Несмотря на кажущуюся сложность выражения (8.21) для многомерного случая, для нормально распределенных значений х дивергенция достаточно просто вычисляется через средние и и ковариационные матрицы пары классов.

Дивергенция пригодна для оценки обеих ситуаций, представленных на

рис. 8.3. Она удовлетворяет требованиям метрики: Djj>0 при i≠j, Dij=0 при

i=j, Dij=Dji, Dшо(х1, ..., xn)<Dij(x,, ...,

Xn,Xn+1) то есть добавление нового

измерения никогда не приводит к уменьшению дивергенции. Более того,

если признаки классов распределены по нормальному закону с равными

ковариационными матрицами, то нетрудно показать, что Dy=Ry, где Rij -

квадратичное расстояние Махаланобиса (8.19). При статистической

независимости измерений дивергенция аддитивна: 1

Эти свойства дивергенции иногда используют при выборе признаков для оценки их информативности [1]: при заданном количестве классов из возможного набора признаков следует отбирать те, для которых общая или средняя попарная дивергенция максимальна.

Однако квадратичная мера D с увеличением расстояния между классами растет значительно быстрее, чем величина R из (8.18). Поэтому использование для набора из К классов такой оценки, как средняя попарная дивергенция, целесообразно только в тех случаях, когда все классы распределены равномерно по пространству X. В противном случае даже один класс, далеко отстоящий от всех остальных, может дать слишком оптимистическую оценку ошибки.

В таких ситуациях предпочтительнее использовать так называемое расстояние Джеффриса-Матуситы (J-M расстояние) [4,32]. J-M расстояние рассчитывается по формуле:

Для нормально распределенных значений признака поведение J-M расстояния связано с ожидаемой вероятностью правильного распознавания зависимостью, которую можно считать почти линейной.

В ЭРДАСЕ можно оценить качество разделения классов с помощью 4-х видов оценок, в том числе

Джеффриса-Матуситы. (см. упр. 3)

Для оценки ошибок первого и второго рода по тестовым участкам изображения при использовании конкретного классификатора (решающего правила) используется фунция Evaluate> Contingency.На выходе выдается протокол, в котором показывается сколько точек из класса k1 попало в класс k2 для всей совокупности классов (рис. 5).

На основании этих оценок Вы можете, как оценить качество обучающих данных, так и подобрать наиболее подходящий метод классификации. Но необходимо помнить, что полученные таким образом оценки в большинстве случаев являются слишком «оптимистичными». В результате классификации изображения ошибки могут оказаться значительно больше, хотя при удачно заданных классах всегда вполне приемлемы.

Создайте свой набор обучающих данных по тестовым участкам и проверьте их качество всеми описанными методами. Подберите наиболее удачный метод классификации для своего набора сигнатур. На тестовых участках желательно добиться 100% точности классификации.

17. Итоговая оценка качества автоматической классификации. Файл расстояний. Отбраковывание ненадежно классифицированных точек с помощью пороговой процедуры. Формирование матрицы итоговых ошибок классификации.

Для визуальной оценки качества классификации и отсева наиболее неудачно классифицированных точек имеется функция Threshold.Нужно открытьфайл классифицированного изображения и файл расстояний. В окне функции у Вас появится таблица, содержащая в поле Chi-Squareзначения порогов «по умолчанию». Их можно изменять. Гистограмма рассчитывается командой меню Histogram > Compute.Гистограмма расстояний аппроксимируется %2 распределением (отсюда название поля Chi-Square). Если гистограмма расстояний сильно растянута и имеет пики, всего скорее, классы включают в себя несколько однородных классов. Если главная мода находится на некотором расстоянии от оси ординат, возможно смещение центра класса. Как в этом случае действовать дальше, зависит от использованной схемы классификации. Нужно еще раз проверить, соответствуют ли статистические свойства обучающих сигнатур выбранному методу классификации.

Файл расстоянийсоздаётся в процессе классификации в окне Supervised Classification включением режима Distance File.

После выполнения классификации файл расстояний можно посмотреть в отдельном вьюере. Он характеризует расстояние между вектором значений пикселя и сигнатурой класса и определяется параметрическим правилом, использованным при классификации в качестве основного или Unclassified. Для хорошего аналитика даже само растровое отображение файла расстояний может оказаться достаточно информативным.

Файл расстояний используется при так называемой «нечеткой» классификации Fazzy Classification.Этот режим формирует на выходе трехслойное изображение, в котором каждому пикселю сопоставлен трехмерный вектор «альтернативных» классов. После такой классификации можно, используя функцию Fuzzy Convolutionблока Classifier,завершить процесс классификации уже с учетом ситуации в окрестности каждого пикселя. Этот режим, однако, требует некоторых аналитических усилий и определенного опыта тематической обработки.

Пороговые расстояния можно устанавливать либо по гистограмме, либо непосредственно в таблице. Указать вюер, выбрать опцию Process > То Viewer. По умолчанию «плохо» классифицированные точки будут теперь забиты черным цветом.

Количественные оценки (матрицу ошибок) классификации можно получить с помощью функции Accuracy Assessment блока Classifier. Проще всего оценку проводить по «случайным» точкам, которые генерируются автоматически. Откройте в окне этой функции файл классификации. Затем выберите функцию View > Select Viewer и укажите исходное изображение, где Вы будете отображать точки. Классы этим точкам Вы должны будете присвоить сами. Случайные точки генерируются с помощью команды Edit > Create/Add Random Points. В окне этой команды можно отрегулировать генератор случайных чисел и число точек.

Вы можете отображать во вьюере изображения либо все точки, либо выбранные тем же способом, как и в редакторе сигнатур.

Задав все номера классов, отметьте в меню Report > Options нужные опции для отчета и затем выберите функцию Report > Accuracy Report. Вы получите отчет по оценке точности.

Учтите, что для более или менее качественной оценки требуется довольно большое количество точек (не менее ТОО в худшем случае), однако для обучения работе с процедурой при небольшом числе классов можно взять 20-30.

18. Методы интерактивной обработки классифицированных изображений для перехода к тематической карте. Использование функций пакета ERDAS Imagine из блока Interpreter для осуществления этого процесса.

После интерактивной обработки классифицированных изображений для перехода к тематической карте идет 1.Тематическая интерпретациязаключается в сопоставлении каждому из выделенных классов некоторой тематической категории определенной совокупности объектов земной поверхности. Здесь оцениваются реальные ошибки классификации, то есть достоверность результата. При неудачном выборе количества или описаний исходных классов может быть принято решение о повторной классификации на основе другого набора классов и системы признаков. При удовлетворительном результате выбирается схема постклассификационной обработки для перехода к тематической карте.

2. Постклассификационная обработкапредставляет собой набор интерактивных и автоматических процедур, необходимых для формирования карты объектов исследования, расклассифицированных в соответствии с тематикой задачи. К таким процедурам относятся группировка и редактирование выделенных классов, устранение обнаруженных ошибок классификации. В процессе постклассификационной обработки также могут быть использованы процедуры распознавания, в том числе структурные.

3. Подсчет количественных характеристиквключает площадные оценки по выделенным классам объектов, а также точечные оценки в соответствии с физическими моделями исследуемых процессов и явлений, оценки динамики процессов при обработке мультивременных данных и т.п. Этот этап, не имеющий прямого отношения к процессу распознавания, тем не менее, важен для его оптимизации. Накопление и анализ характеристик выделяемых классов объектов позволяет совершенствовать как саму систему распознавания, так и отдельные ее этапы.

Процесс 4.получения тематических картна основе результата обработки включает процедуры преобразования изображения к нужной картографической проекции, интерактивное редактирование результата в соответствии с точностными требованиями к картографическим материалам заданного масштаба, а также растрово-векторное преобразование при использовании векторных ГИС. Выполнение растрово-векторного преобразования требует, как правило, сглаживания результата в пределах некоторых участков для получения однородных по классам контуров. Именно с точки зрения этого этапа наиболее эффективны такие процедуры классификации, которые обеспечивают наибольшую однородность изображения по классам и наиболее четкие границы между объектами определенных тематических категорий. Если результат классификации не удовлетворяет этим условиям, процедуры сглаживания могут привести к искажению реальных границ между классами.

В блоке Interpreterвыберите пункт меню Spatial Enhancement,а в открывшемся подменю - функцию Resolution Merge.В открывшемся окне по порядку слева на право откройте файлы: 1) панхроматического изображения; 2) многозонального трансформированного вами изображения; 3) выходного результата, который Вы собираетесь получить. Режимы можете выбрать те, которые установлены по умолчанию. Нажмите ОК.

19. Корреляция между признаками (каналами многозонального изображения), ее отражение на диаграмме рассеяния сигнатур в пространстве признаков. Способ расчета матрицы корреляции между признаками.

Совокупности всех векторов-образов соответствует определенное множество точек в n-мерном пространстве, которое называют пространством признаков (ПП).

Задача классификации заключается в разбиении признакового пространства на области, соответствующие различным тематическим категориям (классам) объектов земной поверхности. То есть по каждому измерению классам будут сопоставлены определенные интервалы значений, один или несколько для каждого класса.

Используя признаковое пространство, можно определить:

• какие каналы наиболее полно отображают представленные на изображении тематические классы;

• где в признаковом пространстве расположены спектральные сигнатуры интересующих аналитика тематических категорий и какие классы будут разделяться наиболее надежно.

В пространстве признаков Относительное количество точек с конкретной парой значений признаков отображается цветом от красного к фиолетовому в порядке убывания. Красные пятна, таким образом, соответствуют локальным максимумам многомерной гистограммы изображения

На некоторых ПП-изображениях области значений сжаты вдоль некоторого направления . Это свидетельствует о сильной корреляции между данной парой признаков. В таких случаях можно не использовать оба признака, а выбрать один, более информативный с точки зрения аналитика данных. Вообще всегда целесообразно снизить размерность задачи, когда есть такая возможность.

На некоторых ПП-изображениях области значений сжаты вдоль некоторого направления . Это свидетельствует о сильной корреляции между данной парой признаков. В таких случаях можно не использовать оба признака, а выбрать один, более информативный с точки зрения аналитика данных. Вообще всегда целесообразно снизить размерность задачи, когда есть такая возможность.

С точки зрения общей информативности для классификации лучше всего выбрать пары признаков с наиболее широкими диаграммами рассеяния и наибольшим количеством локальных мод (красных или желто-оранжевых пятен на цветном ПП-изображении). Если эти моды соответствуют каким-то тематическим классам, то такие классы будут выделяться наиболее надежно.

Корреляционная мера и корреляционная матрица.Корреляционная мера сходства двух векторов аи b определяется как косинус угла между этими векторами:

где (а,Ь) - скалярное произведение векторов, ||-|| - норма (длина) вектора.

Ясно, что величина ρ будет принимать значения на отрезке [-1,1], при этом она будет положительна при одинаковых знаках соответствующих координат векторов аи b и отрицательна при противоположных. При конечном числе образов N эта величина есть ни что иное, как выборочный коэффициент корреляции.

При значении меры корреляции ρjk, близкой по модулю к 1, в некоторых случаях можно практически без потери информации использовать при распознавании только один из признаков Xiили Xj. Тем не менее, перед этим все-таки целесообразно проверить, какие классы разделяются по этому признаку и не является ли наличие данного измерения принципиально важным для нашей конкретной задачи.

Матрица R={pjk}, j=l,...,n, k=l,...,n размерности n x n называется корреляционной матрицей.Из определения коэффициента корреляции ясно, что корреляционная матрица R - симметрическая положительно полуопределенная, с диагональными элементами pjj =1, j=l,...,n.

Стандартизованная матрица данных.Пусть у нас имеется N образов, представляющих собой векторы в n-мерном пространстве измеряемых признаков - реализаций n-мерной случайной величины ξ. Представим полученные данные в виде  матрицы размерности n x N.

матрицы размерности n x N.

Заметим, что каждый столбец матрицы - это вектор в пространстве размерности N, где N -число наблюдений (образов). В таком N-мерном пространстве задачу выделения наиболее информативных признаков (снижения размерности) можно рассматривать как задачу кластеризации по корреляционной мере сходства, о чем уже упоминалось в разделе 6.

2. Вычислим выборочную дисперсию по каждой компоненте:

Для решения этой задачи приведем матрицу данных Х° к стандартизованному виду. 1. Рассчитаем выборочные средние по каждой компоненте (столбцу) j=l,...,n:

Дисперсия, рассчитанная по (7.3), является смещенной оценкой с точки зрения математической статистики, но здесь она рассматривается скорее как среднее внутригрупповое расстояние, подобно тому, как это делалось в алгоритмах кластеризации.

Элементы стандартизованной матрицы данных Х={хij} вычисляются по формуле:

Стандартизованную матрицу данных X иначе называют нормированной матрицей.В результате проведенных операций мы перемещаем начало координат пространства признаков в точку с координатами ml...,mn и нормируем шкалу по каждой координате на значение а. Полученная таким образом стандартизованная матрица данных обладает следующими свойствами.

Мера корреляции (7.2) между двумя измеряемыми параметрами j и к, представленными вектор-столбцами матрицы X, тогда принимает вид:

Мера корреляции (7.2) между двумя измеряемыми параметрами j и к, представленными вектор-столбцами матрицы X, тогда принимает вид:

20. Анализ главных компонент. Общее теоретическое обоснование метода (с графической иллюстрацией). Использование метода главных компонент при интерактивном анализе изображения и для снижения размерности наборов данных.

Системы дистанционных измерений, особенно космические, обычно рассчитаны на широкий спектр прикладных задач. И если для выделения конкретных классов объектов мы будем использовать все доступные наборы измерений (например, все каналы Тематического Картографа), мы можем получить задачу слишком большой размерности. Это затруднит если не сами расчеты, то, по меньшей мере, получение представительных выборок для описания классов в системе координат признаков. Поэтому после выбора перечня классов можно подумать над тем, какописать эти классы с использованием меньшего количества измерений.

В целом в задачах распознавания образов преобразование признакового пространства X обычно имеет две цели:

1) сократить общее количество признаков n, сохранив при этом

максимальное количество полезной информации;

2) сделать эти признаки статистически независимыми, то есть образующими ортогональный базис в пространстве X.

Статистическая независимость признаков значительно упрощает расчеты при описании классов в пространстве X и непосредственно при классификации.

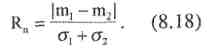

Предположим, что значения координат образов в признаковом пространстве X для каждого из наших классов распределены по нормальному (гауссову) закону. Эта гипотеза часто используется, в частности, при классификации аэрокосмических изображений, так как на измерения коэффициентов отражения подстилающей поверхности воздействует множество случайных факторов различной природы.

В общем случае плотность многомерного нормального распределения имеет вид