Нечеткие нейронные сети для задач управления

В рассмотренных выше типах (2.13) – (2.16) нейронных сетей в качестве модели искусственного нейрона использовалась модель Маккалока и Питтса. Для задач интеллектуального управления была предложена новая модель нейрона - так называемый «нечеткий нейрон» (a fuzzy neuron).

Типовой нечеткий нейрон (для задач управления) обладает следующими отличительными свойствами:

· его входы являяются значения нечетких лингвистических переменных;

· вместо весов используются значения функций принадлежности лингвистических переменных и степени активаций нечетких правил;

· пороговое значение отсутствует.

Нечеткие нейронные сети (ННС) являются разновидностью адаптивных сетей, описанных в параграфе 2.4.6.

Нечеткий вывод может быть реализован с помощью ННС, включающей в свою структуру нечеткие нейроны.

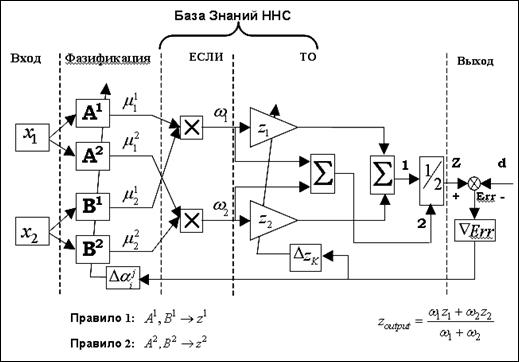

На рис. 2.47 показан пример структуры ННС, реализующей вычисления для модели нечеткого вывода Сугено.

Рассмотрим пример построения ННС для задачи нечеткого вывода в модели Сугено.

Пример:Построение ННС для нечеткого вывода Сугено. Для простоты предположим, что ННС имеет два входа x и y, и один выход z. Для простоты также возьмем два правила, например, такие, как:

Правило 1:

ЕСЛИ  И

И  ТО

ТО

Правило 2:

ЕСЛИ  И

И  ТО

ТО

Опишем формально каждый слой представленной архитектуры ННС. Обозначим выход  -той вершины слоя

-той вершины слоя  как

как  .

.

Рис. 2.47. ННС архитектура для модели нечеткого вывода Сугено нулевого порядка

Слой 1

Выходное значение каждой вершины данного слоя вычисляется следующим образом:

=

=  , для

, для  = 1,2, и

= 1,2, и  =

=  для

для  = 3,4,

= 3,4,

где x и y – входные значения,  и

и  – функции принадлежности входных переменных.

– функции принадлежности входных переменных.

Например, функции принадлежности входных переменных описываются так называемыми «bell functions» следующего вида:

,

,

где  - множество параметров функций принадлежности. Параметры данного слоя будем называть параметрами посылок (premise parameters).

- множество параметров функций принадлежности. Параметры данного слоя будем называть параметрами посылок (premise parameters).

Слой 2

Выходное значение каждой вершины данного слоя вычисляет значение нечеткой конъюнкции двух нечетких величин:

,

,  =1,2.

=1,2.

Таким образом, каждая вершина второго слоя выдает значение степени активации нечеткого правила.

Примечание. В приведенной выше формуле в качестве операции нечеткой конъюнкции выбрано умножение, однако могут использоваться и другие интерпретации этой операции.

Слой 3

Выходное значение каждой вершины данного слоя вычисляет как:

,

,  = 1,2.

= 1,2.

Слой 4

,

,

где  - выход

- выход  -той вершины слоя 3 и

-той вершины слоя 3 и  - параметры, называемые параметрами заключения (consequent parameters).

- параметры, называемые параметрами заключения (consequent parameters).

Слой 5

В данном слое формируется выходное значение сети:

. (2.17)

. (2.17)

Перепишем формулу (2.17) как:

=  .

.

Итак, мы построили ННС, реализующую нечеткий вывод Сугено первого порядка. Далее, с использованием специального алгоритма обучения, можно настраивать параметры сети  и

и  на решение определенной задачи.

на решение определенной задачи.

На Рис. 2.47 показана структура ННС, реализующей вычисления для модели нечеткого вывода Сугено нулевого порядка. В этом случае вышеприведенная формула будет иметь следующий вид:  .

.

В заключение данного параграфа отметим основные особенности нейронных сетей.

1. ИНС рассматривается как взвешенный (или нет) направленный граф (weighted directed graph), вершины которого представлены нейронами, а направленные дуги описывают связи между нейронами. ИНС характеризуется тремя параметрами: типом нейронов, архитектурой (организацией связей между нейронами) и алгоритмом обучения в данной сети.

2. Функционирование ИНС может быть рассмотрено как некоторое отображение F:  , где

, где  - пространство входных значений, а

- пространство входных значений, а  - пространство выходных значений. Таким образом, ИНС отображает входной вектор

- пространство выходных значений. Таким образом, ИНС отображает входной вектор  в выходной вектор

в выходной вектор  через «фильтр» синаптических весов. Можно представить выходной вектор как

через «фильтр» синаптических весов. Можно представить выходной вектор как  , где

, где  - матрица весов. Матрица

- матрица весов. Матрица  представляет «знания» сети, ее «долговременную память», в то время как, значения активации нейронов представляют текущее состояние сети или «кратковременную память» сети.

представляет «знания» сети, ее «долговременную память», в то время как, значения активации нейронов представляют текущее состояние сети или «кратковременную память» сети.

3. Характерные черты ИНС:

· способность к обучению и адаптации;

· способность к обобщению;

· свойство массивного параллелизма;

· свойство ассоциативной памяти;

· надежность (robustness);

· пространственно-временная обработка информации.

Способность к обучению и адаптации является фундаментальным свойством естественного интеллекта. Существует множество определений этих свойств. В контексте ИНС, процесс обучения рассматривается как процесс обновления весов сети так, что сеть могла оптимальным образом решать поставленную задачу.

Способность к обобщению позволяет на сходные, похожие, стимулы (входные значения) получать сходные, похожие, реакции сети (выходные значения). Например, сеть может распознать образ по входным данным, содержащим шум.

Надежность ИНС означает, что ИНС может продолжать успешно функционировать даже если сеть или входные данные повреждены. Ассоциативная память обладает свойством запоминать образы и распознавать их даже если на входе присутствует только часть образа.