Метод компонентного анализа значения.

Несмотря на изначальное предназначение структурных методов служить изучению формальных свойств языка, они со временем стали использоваться и для исследования языковой семантики. В результате этого возникла структурная семасиология. Ее основным методом является компонентный анализ значения, цель которого — определение семантической структуры двусторонних языковых единиц, хотя

Ирина Владимировна Арно́льд (1908-2010), профессор РГПУ Ирина Владимировна Арно́льд (1908-2010), профессор РГПУ |

семантика и не поддается полной формализации. Определить семантическую структуру языковой единицы — значит: а) выделить мельчайшие единицы ее содержания и б) установить между ними закономерные связи и отношения. Однако выполнение этой задачи сопряжено с известными трудностями. Одной из них оказывается обеспечение объективности выделения минимальных единиц содержания, второй — способы выявления структурообразующих связей и отношений между ними.

Некоторую путаницу в компонентный анализ значения вносит терминологический разнобой в именовании семантических единиц. Особенно это актуально для названия мельчайшей единицы плана содержания языкового знака. Ее терминообозначениями

выступают: «дифференциальный элемент» (Ф. де Соссюр), «фигура содержания» (Луи Ельмслев), «семантический множитель» (Юрий Дереникович Апресян), «дифференциальный признак» (Ирина Владимировна Арнольд), «ноэма» (польский лингвист Э. Кошмидер, немецкий языковед Густав Мейер), «семантический маркер» (американские Дуайт Болинджер, Дж. Кац и Джерри Фодор) и «сема» (Владимир Скаличка). В настоящее время наиболее употребляемым является термин «сема».

Сема — это наименьший смысловой элемент значения, составная часть семемы, ее конструктивный компонент. Отсюда определение семемы как пучка структурно упорядоченных сем. Следовательно, семема представляет собой семантическую структуру, выражающую определенные содержательные отношения между семами, которые, в свою очередь, являются репрезентантами свойств и признаков именуемых объектов.

Дуайт Болинджер (1907–1992) Дуайт Болинджер (1907–1992) |

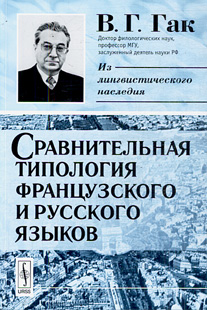

В этом плане особую актуальность приобретает следующее суждение Владимира Григорьевича Гака: «Под семантической структурой отдельного значения слова понимается совокупность элементарных смыслов, «сем», составляющих это значение. Каждая сема представляет собой отражение в сознании носителей языка различительных черт, объективно присущих денотату, либо приписываемых ему данной языковой средой и, следовательно, являющихся объективными по отношению к каждому говорящему». В данном определении содержится указание на связь между семами и признаками денотата. Кроме В.Г. Гака, эту точку зрения разделяют Юджин Найда, Дж. Кац и Джерри Фодор, Г. Вотяк, Альгильдарс Греймас и другие сторонники макролингвистического подхода к анализу семантической структуры. Приверженцы микролингвистического подхода сущность сем раскрывают через их соотношение в рамках взаимодействующих языковых единиц на синтагматической и парадигматической оси.

Учитывая существующие подходы к компонентному анализу значения, следует назвать несколько способов выявления сем в структуре значения:

а) логический, основанный на установлении гносеологических связей между семами и признаками денотата;

б) лингвистический, использующий совместную встречаемость (сочетаемость, синтагматику) семантически близких слов в речи;

в) логико-лингвистический, сочетающий в себе логические и лингвистические приемы выделения сем.

Начинающие лингвисты чаще других применяют логический способ выделения сем, нередко подменяя анализ языкового значения анализом всех существенных реальных

Джерри Фодор (р.1935), американский философ и психолингвист Джерри Фодор (р.1935), американский философ и психолингвист |

и возможных признаков денотата. При таком осуществлении компонентного анализа происходит ошибочное отождествление значения языковой единицы со всей совокупностью свойств и признаков обозначаемого объекта. Например, в работах Густава Мейера в семный состав слова Ford «горшок» неоправданно включаются все его характеристики, даже такие, как цвет, цена, способ чистки. В таком случае не различаются постоянные и переменные величины, лингвистические и экстралингвистические признаки, языковые значения и гносеологические формы отражения предмета в нашем сознании (научные и бытовые понятия, представления, образцы).

Стремясь избежать подобных недостатков, нередко языковые значения отграничивают от логических при помощи словарных дефиниций. Однако и здесь не всегда удается обнаружить семный состав слова, поскольку вместо компонентного анализа приводятся словарные толкования значений без должной их семасиологической обработки.

Скаличка Владимир (1909—1991) Скаличка Владимир (1909—1991) |

Корректность компонентного анализа значения требует последовательного разграничения таких двух смежных понятий, как «сема» и «семантический признак» (ср. «фонема» и «фонологический признак»). В практике лингвистического анализа иx зачастую отождествляют. Если сема — это элементарная смысловая единица, или смысловой элемент значения (семемы), то семантический признак— это определенный параметр или аспект значения слова (фразеологического оборота) типа «цвет», «размер», «внешний вид», «внутреннее свойство» и т.п. Семы следует отличать от категориальных и функционально-стилистических значимостей типа «субстантивность», «адъективность», «переходность», «просторечность».

Определение сущности семы зависит также от внутреннего устройства семемы. Данное выше определение семемы как пучка сем прежде всего исключает их линейное расположение. Семантическая структура слова представляет собой иерархическую opганизацию сем. В рамках иерархического построения значения семы обнаруживают различные свойства и отношения. Они могут быть разного ранга и разной значимости. Именно на этом основании строится типология сем. Различают следующие типы сем: 1) лексические и грамматические; 2) эксплицитные, если в плане выражения знака их представляет какая-либо морфема, и имплицитные, не имеющие специального материального средства своего выражения; 3) парадигматические и синтагматические; 4) главные (доминирующие) и зависимые; 5) ядерные и периферийные; 6) интегрирующие (идентифицирующие) и дифференцирующие; 7) облигаторные (обязательные) и факультативные и т.д.

Владимир Григорьевич Гак (1924-2004) Владимир Григорьевич Гак (1924-2004) |

Выделенные типы сем обнаруживаются на разных уровнях, хотя компонентный анализ на том или ином уровне имеет специфику. К общим признакам компонентного анализа на разных языковых уровнях следует отнести выявление иерархии сем:

а) архисема — общая сема родового характера (у слова «медведь», например, это — «животное», а у глагола «бежать» — «движение»);

б) дифференциальные семы видового характера: 1) описательные (отражающие индивидуальные свойства и признаки предмета: форму, размер, устройство, способ совершения действия и т.п.) и 2) относительные (отражающие связи и отношения данного предмета с другими предметами: функции, пространственные и временные отношения);

в) потенциальные семы — скрытые элементарные смыслы, возможность проявления которых обеспечивается особыми речевыми средствами (средствами их актуализации): у слова «медведь» это могут быть такие семы, как «неповоротливость», «неуклюжесть», у глагола «бежать» — «течь», «вскипать» и т.п.

Иерархический статус в процессе исторических или функциональных изменений значения может трансформироваться: ядерные семы могут перемещаться на периферию, а дифференциальные семы могут занимать ядерные позиции; потенциальные семы могут приобретать статус дифференциальных и даже ядерных. Особенно значимым оказывается изучение таких трансформаций при разъяснении механизмов образования переносных метафорических и метонимических значений.

Альгирдас Греймас (1917-1992), литовский и французский лингвист Альгирдас Греймас (1917-1992), литовский и французский лингвист |

Компонентный анализ значения на морфемном уровне состоит в выявлении сем в пределах семантики морфем. Хотя количество сем и количество морфем не совпадают, между ними все же существует известная корреляция. Многие морфемы вполне соотносимы с конкретными семами. Например, сема «отрицание» в русском языке выражается приставкой не-, в немецком un-, в английском un-, в немецком суффиксом -los. Некоторые морфемы обладают двумя семами, как, например, суффиксы уменьшительности — семой «малость» и семой «оценка» (ср. котенок, соколик, рыбка). И все же между морфемной и смысловой структурой слова отношения скорее асимметричные, чем прямо пропорциональные.

На морфологическом уровне компонентный анализ значения используется для выявления семантической структуры грамматических категорий. Например, глагольные формы 1-го лица ед. ч. включают семы: «субъект речи», «лицо», «единичность»; форма 2-го лица — «адресат речи», «лицо», «единичность». Количество сем у разных граммем различно. Ср: в немецком языке глагольная форма претерит содержит одну сему «прошедшее», а глагольная форма плюсквамперфект четыре семы: «прошедшее», «предшествование по отношению к другому действию», «контактность с последующим действием», «законченность действия».

На синтаксическом уровне компонентный анализ значения направляется на выявление семантической структуры синтаксических категорий и, прежде всего, категории предикативности и модальности.

Эра Васильевна Кузнецова (1927—1988), профессор Уральского гос.ун-та Эра Васильевна Кузнецова (1927—1988), профессор Уральского гос.ун-та |

Результативность компонентного анализа, достоверность его результатов во многом зависит от объективности вычленения сем. Каковы же способы определения семного состава значения? Чтобы выделить семы, требуется языковой опыт и логический анализ, подкрепленный различными пробами или экспериментами, основы которых были разработаны еще Aлександром Mатвеевичем Пешковским и Львом Владимировичем Щербой. Основными приемами при этом служат проверка на замену (подстановку) с сопоставлением замещаемых форм, проверка на сочетаемость и на трансформацию.

Комбинации полученных дифференциальных семантических элементов образуют смысловые структуры анализируемых слов. Поскольку сущность значения определяется двумя типами отношений знаковых единиц языка, то выделение сем следует проводить двумя путями — парадигматическим и синтагматическим.

Парадигматический способ предполагает использование логического анализа (напр., ЛСГ родства) и словарных толкований. Наиболее часто в компонентном анализе используются словарные дефиниции. Данный прием нашел обоснование в работах Ирины Владимировны Арнольд, Эры Васильевны Кузнецовой, Aнны Aнфилофьевны Уфимцевой. Так, И.В. Арнольд был разработан прием извлечения сем путем сопоставления объяснительных трансформаций словарных дефиниций. Дело в том, что словарная дефиниция представляет собой разложение смыслового содержания слова на его составляющие. Например, в словаре С.И. Ожегова «солдат» определяется как «рядовой военнослужащий», а «боец» как «солдат, рядовой». Словарные толкования анализируемых слов приводятся к единообразному виду. Общая часть трансформов соответствует общим компонентам («солдат» — включение первого слова в определение второго; «рядовой»). Та же часть трансформов, которая не совпадает, представляет собой дифференциальные семы. Этот прием применяется при построении синонимических рядов, различных микрополей (ЛСГ, ТГ).

Анна Анфилофьевна Уфимцева (1921--1994) Анна Анфилофьевна Уфимцева (1921--1994) |

Синтагматический путь проведения компонентного анализа значения исходит из учета совместной встречаемости в тексте семантически близких слов. Сочетаясь, слова обнаруживают свои семантические признаки. Методика извлечения сем сводится к следующим шагам:

- Фиксируются все случаи совместного появления в тексте двух слов, одно из которых является анализируемым.

- Составляется список слов, уточняющих значение другого слова (слов-синонимов).

- Аллонимы (греч. от allos – «иной» и onoma – «имя», то есть чужое имя, то же, что псевдоним) группируются в семантически близкие классы.

- Каждому классу присваивается обобщенное значение. Эти обобщенные значения и являются семемами (семантическими структурами) исследуемых слов.

Такие приемы выделения сем позволяют максимально избежать субъективности в анализе языковых значений, поскольку извлекаются они из текста при помощи формальных процедур.

Лингвостатистический метод.

Для лингвистического исследования актуальным является философское положение о том, что предмет, не отраженный в аспекте количества, не может считаться конкретно познанным и что наука вообще достигает совершенства лишь там и в той мере, в какой ей удается взять на вооружение математику.

Категория количества в языке связана с установлением количественных изменений, вызывающих качественные преобразования языковых явлений. Именно действие в языке закона перехода количественных изменений в качественные служит важнейшим условием выявления в нем его закономерностей. В связи с этим основной задачей количественного метода в языкознании является раскрытие закономерностей функционирования единиц языка и речи, а также установление закономерностей построения текста. Теоретическое обоснование этого метода и создание алгоритмов его практического применения в языкознании — предмет особой отрасли науки о языке, получившей название лингвостатистики.

Возможность применения лингвостатистического метода в языкознании обусловлена природой и сущностью языка. Язык как система представляет собой совокупность взаимосвязанных дискретных (членимых) единиц, обладающих количественными характеристиками.

Количественные характеристики языковых единиц (и их элементов) одного уровня формируют качественное своеобразие единиц другого уровня. Так, язык с десятью фонемами образует иное количество звуковых «оболочек» морфем и слов, чем язык с пятьюдесятью фонемами.

Язык имеет вероятностный характер. Так, для образования слов используется незначительная часть возможных комбинаций фонем и морфем. В этом выражается действие вероятностных ограничений в сочетании фонем и морфем.

Лингвостатистический метод применим для изучения как языка, так и речи. Однако, количественные характеристики в системе языка не тождественны их количественным отношениям в речи. Дело в том, что на речь влияют не только законы языка (и, прежде всего, закономерности строения языковых единиц, закономерности их речевой реализации), но и законы сочетаемости языковых единиц в речи, законы жанра, тема высказывания, идиостилистические особенности речи и т.п. Характер воздействия этих факторов предсказать сложно. Однако если они регулярно повторяются при одних и тех же условиях, то их все же можно объяснить, раскрыть закономерности появления в речи того или иного элемента с помощью лингвостатистики.

Основные понятия лингвостатистики.

Согласно философской категории всеобщей связи, между явлениями языка и речи существуют определенные связи и зависимости. Обычно различают два вида зависимости — функциональную (динамическую) и статистическую. Функциональная зависимость состоит в том, что одному языковому явлению соответствует другoe определенное явление. Такого же рода зависимость присуща многим физическим явлениям. Повышение температуры — жидкое состояние воды; понижение температуры — ее кристаллизация. Функциональные зависимости дают точные определения установленным закономерностям, то есть могут быть сформулированы как закон. Например: «Вода при температуре ниже О º С превращается в лед».

При статистической (вероятностной) зависимости одному явлению или свойству языка могут соответствовать несколько явлений или свойств. Например: между числом значений слова в словаре и частотой его употребления в речи (тексте) существует определенная статистическая зависимость. Это значит, что выявленному числу значений того или иного слова не обязательно соответствует строго определенная частота употребления этого слова.

Такие нестрогие соответствия между качественной и количественной характеристикой языкового явления получили название корреляций. Термин корреляция имеет два значения: 1) общенаучное — «соотношение, соответствие, взаимосвязь, взаимозависимость явлений» и 2) в лингвистической статистике — такая связь между языковыми явлениями, при которой одно из явлений входит в число причин, определяющих другие, или когда имеются общие причины, воздействующие на эти явления.

В математической статистике существует несколько видов корреляции. В лингвистике обычно используют линейную корреляцию, согласно которой возрастание значений одного признака сопровождается возрастанием или убыванием значений другого признака. В такой линейной корреляции могут находиться, например, лексико-семантические варианты слова и частота встречаемости слова в речи (в тексте). Если при возрастании значений одного признака возрастают значения другого, то устанавливается так называемая положительная корреляция. Если же при возрастании значений одного признака значения другого признака убывают, то налицо отрицательная корреляция.

Число, показывающее степень тесноты корреляции, называется коэффициентом корреляции (это число находится между -1 и 1). Иными словами, коэффициент корреляции заключается от нуля до единицы со знаком «плюс» или «минус»: -1 ← 0→ +1. Если между исследуемыми признаками нет никакой статистической зависимости, величина коэффициента будет равна нулю или близка к нему. И наоборот, сильную зависимость между наблюдаемыми явлениями следует констатировать тогда, когда величина коэффициента приближается к 1 или -1. Величина коэффициента здесь указывает на степень связи между наблюдаемыми языковыми явлениями, а его знак (плюс или минус) — на характер самой корреляции. Как же исчисляется коэффициент корреляции?

Статистика располагает несколькими способами. В лингвистике обычно используют для этого формулу:

r = Σ (x i - x)(у i - у)

√ Σ (x i - x) 2 (у i - у)2

где r - коэффициент линейной корреляции; Σ - суммирование получаемых в результате той или иной операции величин; х i - значение первого знака; у i - значение второго знака; х - средняя (теоретическая) величина первого признака; у - средняя величина второго признака. Величины х i - х и у i - у обозначают отклонения полученных нами величин от средних.

Покажем технику вычисления r на конкретном примере. Предположим, что мы произвели выборку десяти репрезентаций одного и того же явления в текстах двух авторов (А 1 и А 2) и получили следующие частоты их встречаемости:

| Наблюдаемое явление | Выборка-1 | Выборка-2 | Всего |

| Всего |

По формуле исчисления r находим х и у:

х = 275:10 = 27,5, а у = 325:10 = 32,5.

Теперь произведем действия в числителе: (5 - 27,5) (10 - 32,5) +-(10 - 27,5) (15 - 32,5) + (15 - 27,5) (20 - 32,5) + (20 - 27,5) (25 - 32,5) + (25 - 27,5) (30 - 32,5) + (30 - 27,5) (35 - 32,5) + (35 - 27,5) (40 - 32,5) + (40 - 27,5) (45 - 32,5) + (45 - 27,5) (50 - 32,5) + (50 - 27,5) (55 - 32,5) = 506,25 + 306,25 + 156,25 + 56,25 + 6,25 + 6,25 + 56,25 + 156,25 + 306,25 + 506,25 = 2062,5.

Соответствующие действия в знаменателе представим подобным же образом: 1) в первой выборке: 506,25 + 306,25 + 156,25 + 56,25 + 6,25 + 6,25 + 56,25 + 156,25 + 306,25 + 506,25 = 2062,5;

2) такой же результат получим и по второй выборке — 2062,5; 3) √ 2062,5 х 2062,5 = 4253906,2.

Коэффициент r = + 062,5 : 4253906,2 = + 0,0004848.

Коэффициент показывает, что корреляция между наблюдаемыми выборками крайне слабая, хотя и положительная.

Однако окончательные выводы делать рано. Как полагает математическая лингвистика, коэффициент корреляции — величина в известной степени случайная. Для определения необходимой степени надежности получаемых величин пользуются понятиями «доверительная вероятность» (коэффициент доверия) и «уровень значимости» (коэффициент надежности). Под коэффициентом надежности принято считать 95%, когда вероятность допущенной ошибки равна 5%. Кроме того, существует еще уровень значимости — величина, дополняющая коэффициент надежности до 1. Так, при доверительной вероятности р = 0,95 уровень значимости 1 - р = 0,05. Именно при таком уровне значимости результаты лингвистического анализа считаются достаточно надежными.

Уровень значимости и обусловливаемая ею доверительная вероятность определяется исследователем для установления параметров случайных величин. Соответствие между ними определяется по специальным статистическим таблицам (они прилагаются в учебниках и справочниках по статистике).

Итак, в лингвистике установлено: частота появления тех или иных языковых элементов в речи подчиняется определенным статистическим законам (закономерностям).

Статистические законы вероятностны потому, что они лишь предсказывают свойства языковых элементов. Однако они прогнозируют вероятность появления наблюдаемых свойств только в известном диапазоне (от — до), поскольку используются каждый раз в новом количественном измерении (хотя и в пределах известной средней величины). Статистические законы распространяются на те языковые явления, которые испытывают влияние множества факторов (причин). Такие факторы не только многочисленны, но и многовекторны (разнонаправлены). Они взаимодействуют между собой неоднозначно, и поэтому результаты их взаимного воздействия колеблются вокруг некой средней величины.

Располагая известной гипотезой о действии некоторого статистического закона, можно говорить о вероятности соответствующего языкового явления. В нестрогом терминологическом употреблении вероятность представляет собой долю исследуемого элемента (явления) в ряду однородных, долю, ожидаемую по имеющейся у исследователя гипотезе. Исчисляется вероятность (Р) отношением числа появлений изучаемого явления в речевом потоке (а) к числу всех других явлений (b) по формуле Р= а: b.

Сама вероятность закономерна. Действие статистического закона выражается именно в сохранении установленной ранее вероятности. Измерение вероятности языкового явления ведет к изменению статистического закона.

Наблюдения за действием статистических законов, то есть за вероятностью языкового явления, осуществляются при помощи понятий «частота», «средняя частота», «отклонение от средней частоты».

Простейшим из них является «частота» языкового элемента (или явления), под которым понимается число его появлений в наблюдаемом речевом отрезке. Это так называемая выборочная частота, то есть абсолютное (не обработанное) количество употреблений изучаемого элемента в тексте. Выборочные частоты в абсолютном выражении недостаточно информативны, поскольку не способны дать достоверное представление о вероятности изучаемого явления (элемента) и тем более не позволяют сформулировать статистический закон. Так, зная, что в текстах одинакового объема В. Ерофеева жаргонизмы встречаются 800 раз, а в текстах Б. Акунина — 400, нельзя вывести вероятность жаргонизмов в современной художественной прозе и сформировать соответствующий статистический закон.

Л-ингвостатистический метод задал новые стимулы для развития лингвистической типологии. Впервые идею количественного исследования типологически разных языков высказал Джозеф Гринберг. Сравнивая отрывки текста одной и той же длины, составленные на разных языках, можно установить степень сходства или различий в строении этих языков. Об этом свидетельствуют количественные отношения между словами обследуемых текстов и компонентами их морфологического строения.

Количественные характеристики словарного состава в разных стилевых и авторских разновидностях речи в настоящее время широко используются в лексикологии и стилистике. Количественное описание подъязыков науки и техники используется для автоматической обработки языковой информации (создания информационно-поисковых систем и программ для машинного реферирования текстов), а также в методике преподавания языков.

Наиболее распространенными приемами лингвостатистического методаявляются:

А) Лексикографическая статистика (закон Ципфа — Мандельброта).

Джордж Ципф (1902-1950), профессор Гарвардского ун-та Джордж Ципф (1902-1950), профессор Гарвардского ун-та |

Лексикографическая статистика -— это теория и практика состав-ления частотных словарей. Составление частотных словарей поставило ряд практических и теоретических задач. Было замечено, что при достаточно боль-шом количестве текстов около 80% его занимают две тысячи самых употребительных (частотных, активных) лексем.

Изучая отношение частоты и ранга (порядкового номера в частотном словаре), американский лингвист Джордж Ципф в 1949 г. установил прямую их зависимость: r х f = с (то есть ранг х частоту = слово).

В 1954 г. американский математик Бенуа Мандельброт предложил уточненную формулу: Рr = Р (r + р) -b, где r — номер слова в списке по убывающим частотам, Рr — относительная частота (вероятность), а Р, р, b — константы данного текста.

Более детальная проверка закона Ципфа — Мандельброта об-наружила его относительность: константы оказались зависимыми от стиля, жанра, эпохи и т. п. Так, Джордж Юл определил, что для атрибуции текста необходима совокупность разных характеристик, а Ревекка Марковна Фрум-кина доказала, что закон Ципфа действует вообще лишь в интервале 15≤ r ≤ 1500.

Бенуа́ Мандельбро́т (1924-2010), математик Бенуа́ Мандельбро́т (1924-2010), математик |

Б) Статистические параметры стилей и установление авторства.

Статистические методы используются также для изучения употребительности языковых фактов с точки зрения их нормативности, принадлежности стилю языка и отдельного автора. Как и при обычном количественном исследовании, выборки должны быть однородными и одинакового объема (или длины); однородность выборки определяется интуитивно или по социолингвистическим соображениям.

Если при количественной методике исследователь оперирует абсолютными частотами (представляя их иногда как процентное соотношение), то при лингвостатистической методике он оперирует средними частотами и частотностью (долями), понимаемой как отношение наблюдаемой частоты к длине.

Статистическая методика заменяет полное обследование текста серией выборок-наблюдений (выборочная частота обозначается зна-ком «х» с показателем выборки: х 1, х 2 ; наблюдение - знаком «n i ».

Средняя частота есть отношение суммы (знак суммирования – «Σ ») всех выборочных частот кчислу выборок:

− Σ (х 1+ х 2 + х n)

х = n i

Средняя частота отличается от выборочных частот, поэтому стати-стическая интерпретация предполагает обобщение отклонения средней частоты от выборочных частот. Наиболее употребительная (усредненная) мера отклонения от средней частоты в математической статистике и теории вероятностей называется дисперсией (лат. dispersio «отклонение») и обозна-чается буквой «δ». Дисперсия есть среднее арифметическое из квадрата отклонений величин хi от их среднего арифметического, -то есть от средней частоты:

− −

δ = √ ∑ (хi –х)2 или δ2 = ∑ (хi –х)2

k k

Среднее квадратичное отклонение есть квадратный корень из дисперсии.

Статистически изучаются не только выборочные частоты, но и частотные доли. Доля как отношение наблюдаемой частоты к длине выборки определяется при помощи формулы вероятности: р = m:n, где р — доля. Статистическое сравнение долей изучается при по-мощи вычисления квадратичного отклонения доли, критерия хи-квадрат и критерия Стьюдента.

Распределение частот и частотных долей в тексте того или иного автора дает возможность выявить постоянные (константные) особенности текста, а также отклонения от типичного для данного стиля и жанра — индивидуальные особенности, касающиеся употребительности отдельных единиц и их длины.

В) Теория информации и измерение текста.

Теория информации интересуется не содержательной стороной передачи и хранения информации, а ее статистической структурой. -Текст можно изучать при помощи теории информации как статистическую структуру текста, его измерение. Статистическая структура понимается как частота появления в со-общении сигнала (символа). Это будет вероятность, обозначаемая знаком «р». Сочетания сигналов - условная вероятность - обозначается знаком «рi ». При многократном повторении сигнала очень важно опре-делить количество информации, передаваемой сигналом. Количество информации приравнивается к мере недостающей информации, то есть к величине неопределенности. Такое количество информации полу-чило название энтропии; она характеризует ситуацию перед полу-чением сигнала в большей степени, чем сам сигнал.

Неопределенность ситуации (а следовательно, и количество информации) увеличивается с увеличением числа сигналов; при одинаковом числе сигналов не-определенность наибольшая в том случае, если вероятность появле-ния всех сигналов равновероятна. Величина неопределенности (она обозначается знаком Н) связана с вероятностями по формуле:

n

Н= — ∑ р(i) log2 р(i)

i = 1

где вероятность сигнала i обозначена через р (i); i принимает значение 1,2...n; ∑— знак суммы.

Итак, количество информации рассчитывается по формуле:

[p (1) log2 p (1)+p (2) log2 p(2)…+p (n) log2 p (n). ]

В русском языке количество информации, например в фонеме, равно 4,76 ед.

Для сравнения различных сообщений есть понятие относи-тельной энтропии и избыточности. Относительная энтропия пред-ставляет собой отношение действительного количества информации (Н  ) в сигнале к максимальному количеству информации сигналов из возможных при данном числе сигналов: максимальная энтропия (Hмакс.) равна количеству информации при равновероятности всех сигналов (Н0 = logn). Избыточность (R) равна разности между едини-цей и относительной энтропией:

) в сигнале к максимальному количеству информации сигналов из возможных при данном числе сигналов: максимальная энтропия (Hмакс.) равна количеству информации при равновероятности всех сигналов (Н0 = logn). Избыточность (R) равна разности между едини-цей и относительной энтропией:

R = 1 – Н отн. ; Н отн. = Н  : Н0.

: Н0.

Например, русский «телеграфный» алфавит содержит 32 знака. Если все буквы считаются равновероятными (Н0), то информация, содержащаяся в одной букве, будет: Н0 = log 32 = ~ 1,505 десят. ед.

Подсчитано, что средняя информация, содержащаяся во фразе второго порядка вероятности, то есть при наличии двух предшествующих букв (по-, ду-, на-, эн-, об- и т. п.), равна 0,905 (Н3). Относительная энтропия может быть определена:

Н  : Н0 = Н 3 : Н0 =1 – 0,905 : 1,505 = ~ 0,6.

: Н0 = Н 3 : Н0 =1 – 0,905 : 1,505 = ~ 0,6.

Следовательно, избыточность букв для русского языка равна не менее 0,4:

R = 1 – Н 3 : Н0 = 1 – 0,905 : 1,505 = ~ 0,4.