Линейная модель парной регрессии. Метод наименьших квадратов (МНК). Свойство оценок МНК.

Линейная регрессия находит широкое применение в эконометрике в виде чёткой экономической интерпретации её параметров.

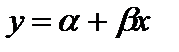

Линейная регрессия сводится к нахождению уравнения вида  (1) или

(1) или  (2). Уравнение (1) позволяет по заданным значениям фактора х иметь теоретические значения результативного признака, подставляя в него фактические значения фактора х.Уравнение (2) рассматривает укак зависимую переменную, состоящую из двух составляющих:

(2). Уравнение (1) позволяет по заданным значениям фактора х иметь теоретические значения результативного признака, подставляя в него фактические значения фактора х.Уравнение (2) рассматривает укак зависимую переменную, состоящую из двух составляющих:

1) неслучайную составляющую  , где

, где  выступает как объясняющая (независимая) переменная, а

выступает как объясняющая (независимая) переменная, а  и

и  - параметры уравнения;

- параметры уравнения;

2) случайного члена -  (возмущение)

(возмущение)

Если  , то получатся точки

, то получатся точки  .

.

Если  , то получим точки

, то получим точки

;

;  .

.

Случайный член существует по ряду причин:

1) включение не всех объясняющих переменных (есть ещё другие факторы, влияющие на у), но измерить их невозможно (например, психологические);

2) агрегирование переменных (объединение некоторого числа микроэкономического соотношения);

3) неправильное описание структуры модели (временные ряды зависят не только от t, но и от t-1);

4) неправильная функциональная спецификация (не линейная, а какая-то другая);

5) ошибки измерения.

εi есть сумма всех этих факторов.

Рассмотрим задачу определения параметров модели, то есть коэффициентов  и

и  - оценке параметров модели.

- оценке параметров модели.

Оценки параметров линейной регрессии могут быть найдены разными методами, например можно построить поле корреляции, взять 2 точки и провести через них прямую.

оценка параметра

оценка параметра  , то есть отрезок отсекаемой прямой на оси

, то есть отрезок отсекаемой прямой на оси  ;

;

,

,  - угловой коэффициент прямой,

- угловой коэффициент прямой,

- оценка параметра

- оценка параметра  .

.

Необходимо с самого начала признать, что мы не сможем рассчитать истинные значения  и

и  . Мы можем получить только оценки, и они могут быть или хорошими или плохими. Построение линии регрессии на глаз является достаточно субъективным.

. Мы можем получить только оценки, и они могут быть или хорошими или плохими. Построение линии регрессии на глаз является достаточно субъективным.

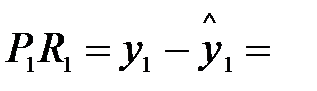

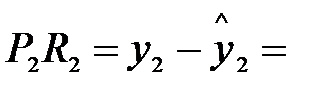

Отрезок  ε1 (остаток),

ε1 (остаток),  ε2. Остатки должны быть min.

ε2. Остатки должны быть min.  .

.

| Y |

| XX |

| X1 |

| P1 |

| P4 |

| R3 |

| R2 |

| R4 |

| P3 |

| P2 |

| R1 |

| ε1 |

| eeeΕ222 |

Существует целый ряд критериев:

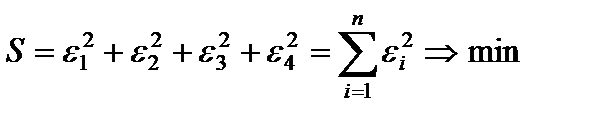

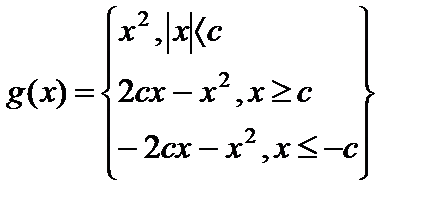

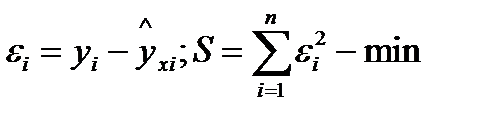

1. МНК  минимизация суммы квадратов отклонений.

минимизация суммы квадратов отклонений.

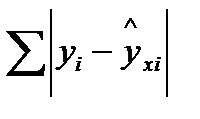

2. Минимизируется  сумма модулей отклонений.

сумма модулей отклонений.

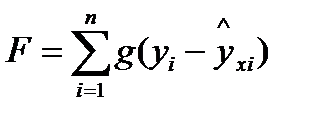

3. Функция Хубера  , где

, где  - «мера» с которой отклонение входит в функционал.

- «мера» с которой отклонение входит в функционал.

| c |

| -c |

| y |

| x |

Рассмотрим достоинства и недостатки перечисленных функционалов.

1) сумма квадратов отклонений:

«+» лёгкость вычисления, хорошие статистические свойства, простота математических выводов делают возможным построить развитую теорию, позволяющую провести тщательную проверку различных статистических гипотез;

«-» чувствительность к выбросам;

2) сумма модулей отклонений:

«+» робастость, то есть нечувствительность к выбросам;

«-» сложность вычислительной процедуры, большим отклонениям надо придавать больший вес (лучше 2 отклонения по 1, чем одно 0 и 2), неоднозначность, то есть разным значениям параметра  могут соответствовать одинаковые суммы модулей отклонений.

могут соответствовать одинаковые суммы модулей отклонений.

Функция Хубера является попыткой совместить достоинства двух первых функционалов.

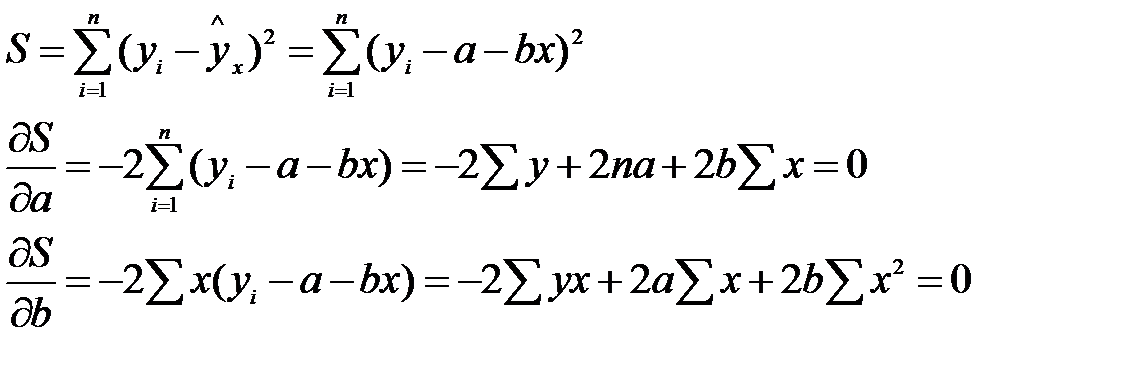

Рассмотрим МНК:

Из множества линий регрессии на графике выбирается та, сумма квадратов отклонений была минимальной.

| Y |

| P1 |

| Pi |

| εi |

| ε1 |

| X |

|

| yi |

Чтобы найти минимум надо взять частные производные по  и

и  функции S и приравнять их нулю.

функции S и приравнять их нулю.

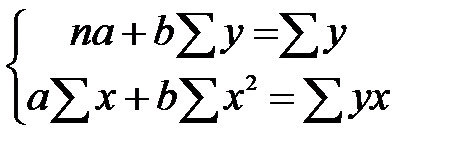

Получим систему нормальных уравнений для оценки параметров a и b (3):

(3)

(3)

Решая систему (3) любым методом: исключение, Крамера (через определители), найдем оценки параметров a и b. МНК даёт самые точные несмещённые и эффективные оценки  и

и  .

.

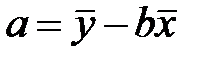

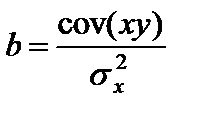

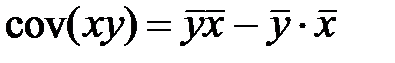

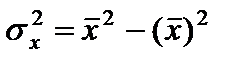

Можно воспользоваться формулами для определения параметров:

;

;

- ковариация признаков;

- ковариация признаков;

- дисперсия признака х.

- дисперсия признака х.

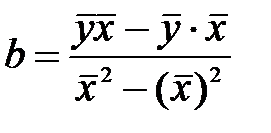

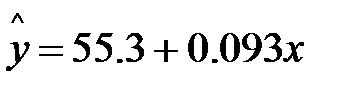

Параметр b называется коэффициентом регрессии. Его величина показывает среднее изменение результата (у) с изменением фактора х на одну единицу. Зависимость между расходами на питание (у) и располагаемым личным доходом (х) за период 1959 по 1983 г. В США описывается уравнением регрессии.

, х увеличился на 1 единицу, а у на 0,093ед.

, х увеличился на 1 единицу, а у на 0,093ед.

Если Х увеличился на 1 млрд $, то у (расходы на питание) возрастут на 93 млн $ (т. е. из 1 $ дохода 9,3 цента – на питание).

| у = а |

. Уравнение регрессии теряет смысл, «а» - не имеет экономического содержания. Интерпретировать можно только знак при параметре а.

. Уравнение регрессии теряет смысл, «а» - не имеет экономического содержания. Интерпретировать можно только знак при параметре а.  - относительное изменение параметра у, происходит медленнее, чем изменение фактора или вариации результата.

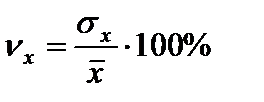

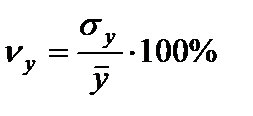

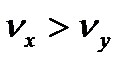

- относительное изменение параметра у, происходит медленнее, чем изменение фактора или вариации результата. Коэффициенты вариации  ;

;  ;

;

Если  , то

, то  ;

;

Если  , то

, то

Возможность чёткой экономической интерпретации коэффициента регрессии сделала линейное уравнение регрессии достаточно распространенным в экономических исследованиях.

Поскольку полученные оценки a и b коэффициентов линейной регрессии опираются на статистические данные и являются случайными величинами, то естественно установить свойства названных оценок; как случайных величин. Более того, не выяснив этих свойств, невозможно сделать обоснованные выводы относительно качества и надежности полученных оценок. Необходимо, в частности, определить такие их статистические характеристики, как математическое ожидание и дисперсия. К желательным свойствам оценок относятся также несмещенность и состоятельность. Далее, если бы удалось установить вид распределения (плотности распределения) оценок, можно было бы построить доверительные интервалы для истинных значений параметров регрессии (т. е. получить интервальные оценки коэффициентов) и реализовать процедуры проверки гипотез относительно их значений. Важную роль играет также изучение статистических свойств остатков оцененной регрессии.

Все эти задачи можно решить, основываясь на некоторых правдоподобных теоретических предпосылках (гипотезах) модели, выполнение которых на практике подлежит проверке с помощью специально разработанных для этого статистических процедур.

Предположение относительно независимых переменных

В дальнейшем будем допускать, что х — детерминированная (неслучайная) величина, т. е. значения независимых переменных заранее известны. Данное предположение (предпосылка), к сожалению, на практике при моделировании реальных социально-экономических процессов часто не выполняется. Это связано с тем, что здесь в качестве независимых переменных часто выступают стохастические неконтролируемые величины, такие как интенсивность потока покупателей (в одном из примеров главы 1) или рыночный индекс в рыночной модели, который также является случайной величиной. При нарушении вышеупомянутой предпосылки ряд «хороших» свойств оценок сохраняется (при некоторых условиях), но в отдельных случаях требуется корректировка модели (оценок).

Предположения относительно случайной составляющей модели

При выполнении предпосылки относительно переменной х статистические свойства оценок параметров и зависимой переменной, а также, остатков, целиком определяются вероятностными свойствами случайной составляющей регрессионной модели. Относительно случайной составляющей в классическом регрессионном анализе предполагают выполнение следующих условий, которые называются условиями Гаусса-Марковаи играют ключевую роль при изучении свойств оценок, полученных по методу наименьших квадратов:

1. Первое условие заключается в том, что математическое ожидание случайной составляющей во всех наблюдениях должно быть равно нулю. Формально это записывается так

М{εt} = 0, для всех t = 1,2,...,п.

Смысл этого условия заключается в том, что не должно быть систематического смещения случайной составляющей. В линейной регрессии систематическое смещение линии регрессии учитывается с помощью введения параметра смещения εi и поэтому данное условие можно считать всегда выполненным.

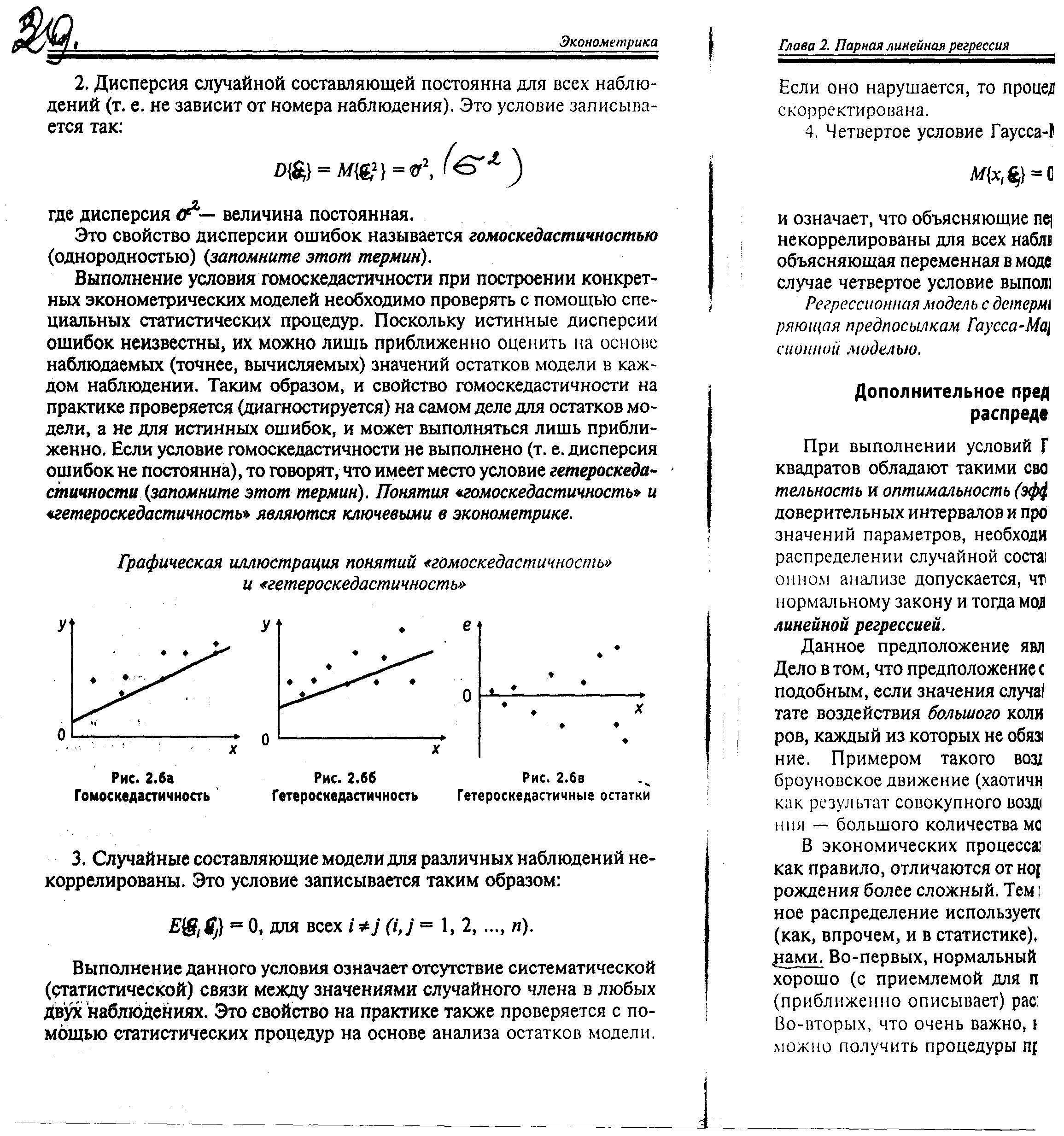

2.Дисперсия случайной составляющей постоянна для всех наблюдений (т. е. не зависит от номера наблюдения). Это условие записывается так:

D{εt}=M{εt2}=σ2,

где дисперсия σ2 — величина постоянная.

Это свойство дисперсии ошибок называется гомоскедастичностью (однородностью).

Выполнение условия гомоскедастичности при построении конкретных эконометрических моделей необходимо проверять с помощью специальных статистических процедур. Поскольку истинные дисперсии ошибок неизвестны, их можно лишь приближенно оценить на основе наблюдаемых (точнее, вычисляемых) значений остатков модели в каждом наблюдении. Таким образом, и свойство гомоскедастичности на практике проверяется (диагностируется) на самом деле для остатков модели, а не для истинных ошибок, и может выполняться лишь приближенно. Если условие гомоскедастичности не выполнено (т. е. дисперсия ошибок не постоянна), то говорят, что имеет место условие гетероскедастичности). Понятия «гомоскедастичность» и «гетероскедастичность» являются ключевыми в эконометрике.

Графическая иллюстрация понятий «гомоскедастичность» и «гетероскедастичность»

Рис. 2.6а

Гомоскедастичность Рис.2.6б Рис. 2.6в

Гетероскедастичность Гетероскедастичные остатки

3. Случайные составляющие модели для различных наблюдений некоррелированы. Это условие записывается таким образом:

М{εi, εj}=0, для всех i≠j (i, j=1,2,…,n)

Выполнение данного условия означает отсутствие систематической (статистической) связи между значениями случайного члена в любых двух наблюдениях. Это свойство на практике также проверяется с помощью статистических процедур на основе анализа остатков модели.

Если оно нарушается, то процедура оценки параметров должна быть скорректирована.

4. Четвертое условие Гаусса-Маркова записывается так:

M{xI, εj}=0, для всех i и j,

и означает, что объясняющие переменные и случайные составляющие некоррелированы для всех наблюдений. Ранее мы предположили, что объясняющая переменная в модели не является стохастической. В этом случае четвертое условие выполняется автоматически.

Регрессионная модель с детерминированными регрессорами, удовлетворяющая предпосылкам Гаусса-Маркова, называется классической регрессионной моделью.

Дополнительное предположение о нормальном распределении ошибок

При выполнении условий Гаусса-Маркова, оценки наименьших квадратов обладают такими свойствами, как несмещенность, состоятельность и оптимальность (эффективность). Однако, для построения доверительных интервалов и проверки гипотез относительно истинных значений параметров, необходимо дополнительное предположение о распределении случайной составляющей εi. В классическом регрессионном анализе допускается, что эта составляющая распределена по нормальному закону и тогда модель называют классической нормальной линейной регрессией .

Первых четырех условий достаточно, а пятое - необходимо для оценки точности уравнения регрессии.

Данное предположение является, пожалуй, наиболее спорным. Дело в том, что предположение о нормальности можно считать правдоподобным, если значения случайной величины порождаются в результате воздействия большого количества независимых случайных факторов, каждый из которых не обязательно имеет нормальное распределение. Примером такого воздействия является так называемое броуновское движение (хаотичное движение малых частиц в жидкости как результат совокупного воздействия на частицу — ударов, соударения — большого количества молекул жидкости).

В экономических процессах распределения случайных величин, как правило, отличаются от нормального, поскольку механизм их более сложный. Тем не менее, чаще всего именно нормальное распределение используется в эконометрических исследованиях (как, впрочем, и в статистике). Это обусловлено следующими причинами. Во-первых, нормальный закон действительно часто достаточно хорошо (с приемлемой для практики точностью) аппроксимирует (приближенно описывает) распределение случайной составляющей. Во-вторых, что очень важно, на основе нормального распределения можно получить процедуры проверки гипотез и построения доверительных интервалов, удобные для расчетов и применения на практике. В любом случае, не изучив базовые результаты (процедуры), основанные на предположении нормальности, нельзя продвигаться на более высокий уровень изучения и применения более реалистичных моделей, не использующих эту предпосылку и позволяющих получать более точные результаты.

Замечание. Если случайные величины в модели распределены по нормальному закону, то из свойств некоррелированности в третьем и четвертом условиях Гаусса-Маркова следует и независимость соответствующих случайных величин.

Оценкой модели является уравнение:

а - оценка  они определяются МНК

они определяются МНК

b - оценка

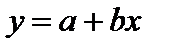

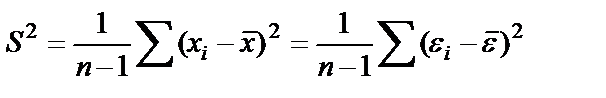

Несмещенная оценка остаточной дисперсии учитывает воздействие факторов и ошибок неучтенных в модели, определяется с помощью дисперсии возмущения (ошибок) или остаточной дисперсии σ2, - это выборочная остаточная дисперсия.

Являются ли оценки a, b и s2 наилучшими выясняется по условиям Гаусса-Маркова: если регрессионная модель удовлетворяет предпосылкам 1-4, то оценки a и b имеют наименьшую дисперсию в классе линейных несмещенных оценок.

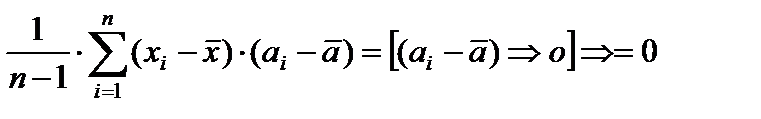

Свойства выборочных вариаций (дисперсий) и ковариаций.

Для дальнейшего изложения нам понадобится установить ряд правил, которые можно использовать при преобразовании выражений, содержащих выборочные вариации и ковариации.

Пусть а — некоторая постоянная, а х, у, z — переменные, принимающие в i-м наблюдении значения xi,yi,zi,i=1,..., п (n — количество наблюдений). Тогда а можно рассматривать как переменную, значение которой в i-м наблюдении равно а, и

Соv(х, а) =

откуда следует свойство:

1. Cov(x, a) = 0.

Далее, нетрудно видеть, что имеют место равенства:

2. Cov(x, у) = Cov(y, х);

3. Cov(x, x) = Var(x).

Кроме того,

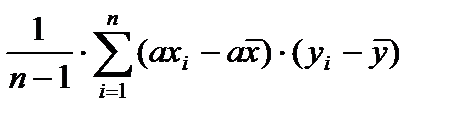

Cov(ax, y) =  =

=

откуда следует свойство:

4. Cov(ax. у) = aCov(x, у).

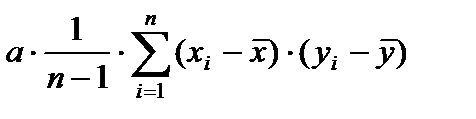

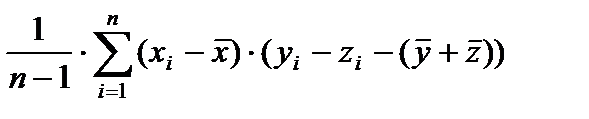

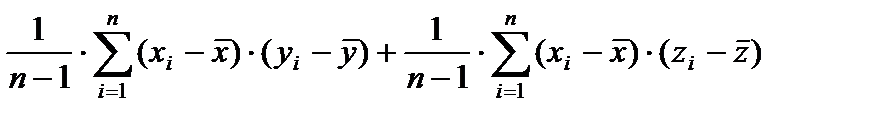

Далее, имеем

Cov(xy,z) =  =

=

так что можно сформулировать еще одно свойство:

5. Cov(x,у + z) =Cov(x,у) + Cov(x,z).

На основе вышеназванных свойств находим, что

6. Var(a)=0 ,

т. е. постоянная не обладает изменчивостью и

7. Var(ax)=a2Var(x).

Таким образом, при изменении единицы измерения переменной в раз, во столько же раз преобразуется и величина стандартного отклонения этой переменной (напомним, что стандартное отклонение равно квадратному корню из дисперсии).

8. Var(x+a)=Var(x)

т. е. сдвиг начала отсчета не влияет на вариацию переменной.

Далее, имеем:

Var(x+y)=Cov(x+y,x+y)= Cov(x,х) + Cov(x,у) + Cov(y,x) + Cov(x,у).

Таким образом, доказано свойство

9.Var(x+y)=Var(x)+Var(y)+2Cov(x,y),

означающее, что вариация суммы двух переменных отличается от суммы вариаций этих переменных на величину, которая равна удвоенному значению ковариации между названными переменными.

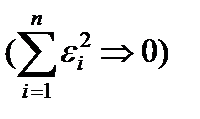

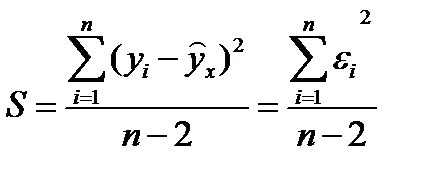

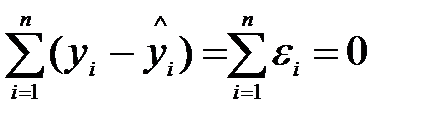

Свойства остатков. Теперь установим почти очевидные соотношения, которые следуют из условии минимума критерия наименьших квадратов. Определим величину

ŷi=a +bx,

— оценку переменной у при оптимальных значениях коэффициентов регрессии и фиксированном значении х в i-ом наблюдении. Такую оценку называют прогнозом зависимой переменной. Тогда, очевидно, ошибка модели в i-ом наблюдении будет равна εi=yi - ŷi и из условия следует, что

т. е сумма квадратов ошибок оценок переменной у (остатков модели) при оптимальных параметрах регрессии а и b равна нулю.

Далее, вытекает, что

т. е., при оптимальных параметрах регрессии ошибки ортогональны наблюдениям независимой переменной.

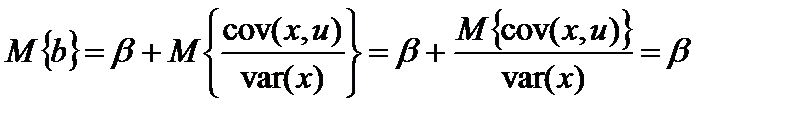

Несмещенность МНК-оценок.Статистическая оценка некоторого параметра называется несмещенной, если ее математическое ожидание равно истинному значению этого параметра.

Для случая парной линейной регрессии это означает, что опенки а и b будут несмещенными, если

М{а} = α, M{b}=β.

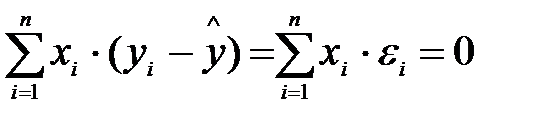

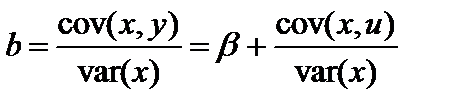

Докажем это свойство. Используя правила преобразования выборочных ковариаций, можно записать:

Cov(x, у) = Cov(x[a + βx + и]) =

= Cov(x, а) + Cov(x, βх) + Cov(x, и) = βVar(x) + Cov(x, и).

Применив формулу для коэффициента,а также полученное выше соотношение, составим выражение:

Далее, поскольку х — неслучайная величина, будем иметь:

и, таким образом, оценка b является несмещенной.

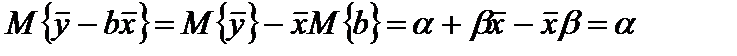

Несмещенность оценки а следует из цепочки равенств:

М{а}=

Замечание. Свойство несмещенности оценок можно доказать и при более слабой форме 4-го условия Гаусса-Маркова, когда х—случайная, но некоррелированная со случайной переменной ε, величина.

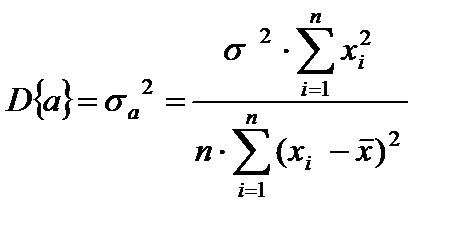

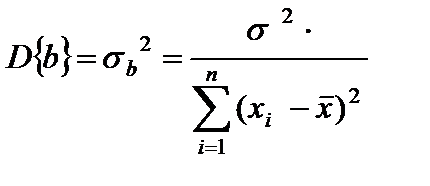

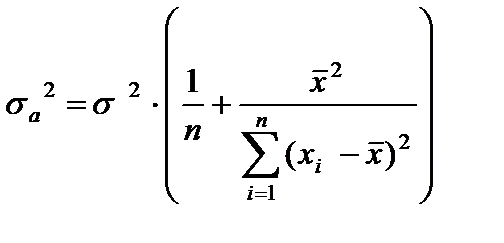

Состоятельность оценок.Свойство состоятельности оценок заключается в том, что при неограниченном возрастании объема выборки, значение оценки должно стремиться (по вероятности) к истинному значению параметра, а дисперсии оценок должны уменьшаться и в пределе стремиться к нулю. Дисперсии оценок коэффициентов регрессии определяются выражениями:

;

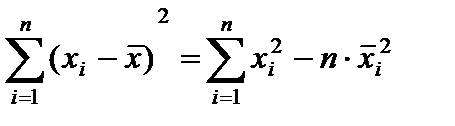

;

Или, используя равенство  , можно записать в виде:

, можно записать в виде:

Вывод: чем больше число наблюдений n, тем меньше будет дисперсия. Эффективность (оптимальность) оценок.

До сих пор мы говорили об оптимальности оценок в смысле минимума квадратичного критерия. Оказывается, что при выполнении условий Гаусса-Маркова они являются также оптимальными в смысле минимума дисперсии.

Оценка называется эффективной, если она имеет минимальную дисперсию по сравнению с другими оценками заданного класса.

Таким образом, оценки наименьших квадратов являются эффективными, т. е. наилучшими в смысле минимума дисперсии, в классе всех линейных несмещенных оценок параметров.

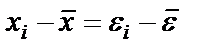

Вычтем из уравнения(1) зависимость (2):

, то есть оценка теоретической дисперсии

, то есть оценка теоретической дисперсии  зависит от (и только от) числа случайной составляющей наблюдений х в выборке. Поскольку эти составляющие меняются от выборки к выборке, так от выборки к выборке меняется и величина оценки

зависит от (и только от) числа случайной составляющей наблюдений х в выборке. Поскольку эти составляющие меняются от выборки к выборке, так от выборки к выборке меняется и величина оценки  .

.