МНК в случае линейной регрессии

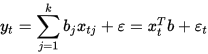

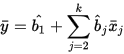

Пусть регрессионная зависимость является линейной:

Рисунок 1.2 – линейная регрессия

Пусть y — вектор-столбец наблюдений объясняемой переменной, а X — это ( n × k )-матрица наблюдений факторов (строки матрицы — векторы значений факторов в данном наблюдении, по столбцам — вектор значений данного фактора во всех наблюдениях). Матричное представление линейной модели имеет вид:

y = X b + ε. (1)

Тогда вектор оценок объясняемой переменной и вектор остатков регрессии будут равны

(2)

(2)

соответственно сумма квадратов остатков регрессии будет равна

RSS = e T e = (y − X b)T (y − X b). (3)

Дифференцируя эту функцию по вектору параметров

b и приравняв производные к нулю, получим систему уравнений (в матричной форме):

(XTX) b= XTy (4)

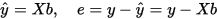

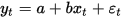

В расшифрованной матричной форме эта система уравнений выглядит как на рисунке 1.3

Рисунок 1.3 – Матричная форма системы уравнения

В рисунке 1.3 все суммы берутся по всем допустимым значениям t .

Если в модель включена константа (как обычно), то x t 1 = 1 при всех t , поэтому в левом верхнем углу матрицы системы уравнений находится количество наблюдений n, а в остальных элементах первой строки и первого столбца — просто суммы значений переменных: ∑ x t j и первый элемент правой части системы — ∑ y t .

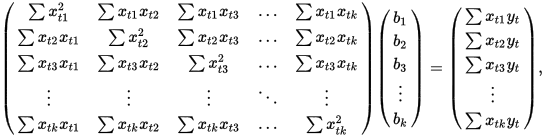

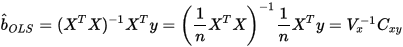

Решение этой системы уравнений и дает общую формулу МНК-оценок для линейной модели:

Рисунок 1.4 – Общая формула МНК для линейной модели

Для аналитических целей оказывается полезным последнее представление этой формулы (в системе уравнений при делении на n, вместо сумм фигурируют средние арифметические). Если в регрессионной модели данные центрированы, то в этом представлении первая матрица имеет смысл выборочной ковариационной матрицы факторов, а вторая — вектор ковариаций факторов с зависимой переменной. Если кроме того данные ещё и нормированы на СКО (то есть в конечном итоге стандартизированы), то первая матрица имеет смысл выборочной корреляционной матрицы факторов, второй вектор — вектора выборочных корреляций факторов с зависимой переменной.

Немаловажное свойство МНК-оценок для моделей с константой — линия построенной регрессии проходит через центр тяжести выборочных данных, то есть выполняется равенство:

Рисунок 1.5 – равенство тяжести выборочных данных

В частности, в крайнем случае, когда единственным регрессором является константа, получаем, что МНК-оценка единственного параметра (собственно константы) равна среднему значению объясняемой переменной. То есть среднее арифметическое, известное своими хорошими свойствами из законов больших чисел, также является МНК-оценкой — удовлетворяет критерию минимума суммы квадратов отклонений от неё.

Простейшие частные случаи

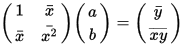

В случае парной линейной регрессии y t = a + b x t + ε t {\displaystyle y_{t}=a+bx_{t}+\varepsilon _{t}}  , когда оценивается линейная зависимость одной переменной от другой, формулы расчета упрощаются (можно обойтись без матричной алгебры). Система уравнений имеет вид:

, когда оценивается линейная зависимость одной переменной от другой, формулы расчета упрощаются (можно обойтись без матричной алгебры). Система уравнений имеет вид:

( 1 x ¯ x ¯ x 2 ¯ ) ( a b ) = ( y ¯ x y ¯ ) {\displaystyle {\begin{pmatrix}1&{\bar {x}}\\{\bar {x}}&{\bar {x^{2}}}\\\end{pmatrix}}{\begin{pmatrix}a\\b\\\end{pmatrix}}={\begin{pmatrix}{\bar {y}}\\{\overline {xy}}\\\end{pmatrix}}}

Рисунок 2.1 – парная регрессия

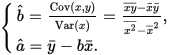

Отсюда несложно найти оценки коэффициентов:

{ b ^ = Cov ( x , y ) Var ( x ) = x y ¯ − x ¯ y ¯ x 2 ¯ − x ¯ 2 , a ^ = y ¯ − b x ¯ . {\displaystyle {\begin{cases}{\hat {b}}={\frac {{\mathop {\textrm {Cov}}}(x,y)}{{\mathop {\textrm {Var}}}(x)}}={\frac {{\overline {xy}}-{\bar {x}}{\bar {y}}}{{\overline {x^{2}}}-{\overline {x}}^{2}}},\\{\hat {a}}={\bar {y}}-b{\bar {x}}.\end{cases}}}

Рисунок 2.2 - оценки коэффициентовРР

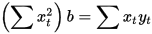

Несмотря на то, что в общем случае модели с константой предпочтительней, в некоторых случаях из теоретических соображений известно, что константа a {\displaystyle a} а должна быть равна нулю. Например, в физике зависимость между напряжением и силой тока имеет вид U = I ⋅ R {\displaystyle U=I\cdot R} U = I * R; замеряя напряжение и силу тока, необходимо оценить сопротивление. В таком случае речь идёт о модели y = b x {\displaystyle y=bx} y = bx. В этом случае вместо системы уравнений имеем единственное уравнение

( ∑ x t 2 ) b = ∑ x t y t {\displaystyle \left(\sum x_{t}^{2}\right)b=\sum x_{t}y_{t}}

Рисунок 2.3 – уравнение y = bx

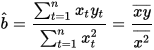

Следовательно, формула оценки единственного коэффициента имеет вид

b ^ = ∑ t = 1 n x t y t ∑ t = 1 n x t 2 = x y ¯ x 2 ¯ {\displaystyle {\hat {b}}={\frac {\sum _{t=1}^{n}x_{t}y_{t}}{\sum _{t=1}^{n}x_{t}^{2}}}={\frac {\overline {xy}}{\overline {x^{2}}}}}

Рисунок 2.4 – формула для оценки 1 коэффициента