Определение с помощью собственной информации

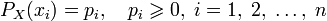

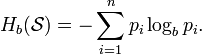

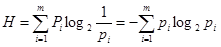

Также можно определить энтропию случайной величины, введя предварительно понятия распределения случайной величины  , имеющей конечное число значений:[2]

, имеющей конечное число значений:[2]

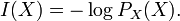

и собственной информации:

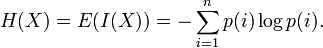

Тогда энтропия определяется как:

От количества возможных состояний  случайной величины

случайной величины  зависит единица измерения количества информации и энтропии: бит, нат, трит или хартли.

зависит единица измерения количества информации и энтропии: бит, нат, трит или хартли.

От основания логарифма зависит числовая величина единицы измерения количества информации и энтропии.

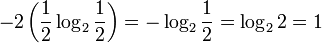

Энтропия является количеством, определённым в контексте вероятностной модели для источника данных. Например, кидание монеты имеет энтропию:

бит на одно кидание (при условии его независимости), а количество возможных состояний равно:

бит на одно кидание (при условии его независимости), а количество возможных состояний равно:  возможных состояния (значения) ("орёл" и "решка").

возможных состояния (значения) ("орёл" и "решка").

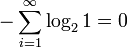

У источника, который генерирует строку, состоящую только из букв «А», энтропия равна нулю:  , а количество возможных состояний равно:

, а количество возможных состояний равно:  возможное состояние (значение) («А») и от основания логарифма не зависит.

возможное состояние (значение) («А») и от основания логарифма не зависит.

Это тоже информация, которую тоже надо учитывать. Примером запоминающих устройств в которых используются разряды с энтропией равной нулю, но с количеством информацииравным 1 возможному состоянию, т.е. не равным нулю, являются разряды данных записанных в ПЗУ, в которых каждый разряд имеет только одно возможное состояние.

Так, например, опытным путём можно установить, что энтропия английского текста равна 1,5 бит на символ, что конечно будет варьироваться для разных текстов. Степень энтропии источника данных означает среднее число битов на элемент данных, требуемых для её зашифровки без потери информации, при оптимальном кодировании.

1. Некоторые биты данных могут не нести информации. Например, структуры данных часто хранят избыточную информацию, или имеют идентичные секции независимо от информации в структуре данных.

2. Количество энтропии не всегда выражается целым числом битов.

Математические свойства

1. Неотрицательность:  .

.

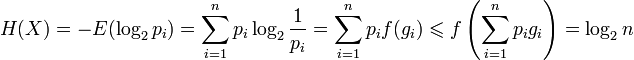

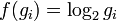

2. Ограниченность:  , что вытекает из неравенства Йенсена для вогнутой функции

, что вытекает из неравенства Йенсена для вогнутой функции  и

и  . Если все

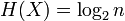

. Если все  элементов из

элементов из  равновероятны,

равновероятны,  .

.

3. Если  независимы, то

независимы, то  .

.

4. Энтропия — выпуклая вверх функция распределения вероятностей элементов.

5. Если  имеют одинаковое распределение вероятностей элементов, то

имеют одинаковое распределение вероятностей элементов, то  .

.

Эффективность

Алфавит может иметь вероятностное распределение далекое от равномерного. Если исходный алфавит содержит  символов, тогда его можно сравнить с «оптимизированным алфавитом», вероятностное распределение которого равномерное. Соотношение энтропии исходного и оптимизированного алфавита — это эффективность исходного алфавита, которая может быть выражена в процентах. Эффективность исходного алфавита с

символов, тогда его можно сравнить с «оптимизированным алфавитом», вероятностное распределение которого равномерное. Соотношение энтропии исходного и оптимизированного алфавита — это эффективность исходного алфавита, которая может быть выражена в процентах. Эффективность исходного алфавита с  символами может быть также определена как его

символами может быть также определена как его  -арная энтропия.

-арная энтропия.

Энтропия ограничивает максимально возможное сжатие без потерь (или почти без потерь), которое может быть реализовано при использовании теоретически — типичного набора или, на практике, — кодирования Хаффмана, кодирования Лемпеля — Зива — Велча или арифметического кодирования.

Вариации и обобщения

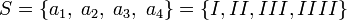

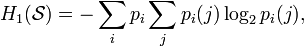

B-арная энтропия

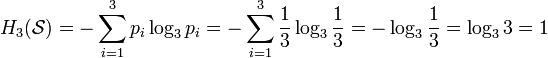

В общем случае b-арная энтропия (где b равно 2, 3, …) источника  с исходным алфавитом

с исходным алфавитом  и дискретным распределением вероятности

и дискретным распределением вероятности  где

где  является вероятностью

является вероятностью  (

(  ), определяется формулой:

), определяется формулой:

Примеры:

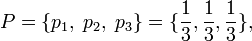

Тринарная энтропия

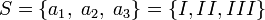

При бросании трёхгранного (b = 3) «чижа», тринарная энтропия источника («чижа»)  с исходным алфавитом (цифры на гранях трёхгранного «чижа»)

с исходным алфавитом (цифры на гранях трёхгранного «чижа»)  и дискретным равномерным распределением вероятности (сечение «чижа» — равносторонний треугольник, плотность материала «чижа» однородна по всему объёму «чижа»)

и дискретным равномерным распределением вероятности (сечение «чижа» — равносторонний треугольник, плотность материала «чижа» однородна по всему объёму «чижа»)  где

где  является вероятностью

является вероятностью  (

(  ) равна:

) равна:

трит.

трит.

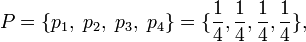

Тетрарная энтропия

При бросании четырёхгранного (b = 4) «чижа», тетрарная энтропия источника («чижа»)  с исходным алфавитом (цифры на гранях четырёхгранного «чижа»)

с исходным алфавитом (цифры на гранях четырёхгранного «чижа»)  и дискретным равномерным распределением вероятности (поперечное сечение «чижа» — квадрат, плотность материала «чижа» однородна по всему объёму «чижа»)

и дискретным равномерным распределением вероятности (поперечное сечение «чижа» — квадрат, плотность материала «чижа» однородна по всему объёму «чижа»)  где

где  является вероятностью

является вероятностью  (

(  ), равна:

), равна:

тетрит.

тетрит.

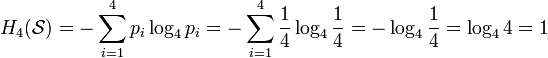

Условная энтропия

Если следование символов алфавита не независимо (например, во французском языке после буквы «q» почти всегда следует «u», а после слова «передовик» в советских газетах обычно следовало слово «производства» или «труда»), количество информации, которую несёт последовательность таких символов (а, следовательно, и энтропия), очевидно, меньше. Для учёта таких фактов используется условная энтропия.

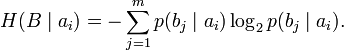

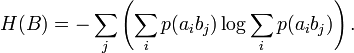

Условной энтропией первого порядка (аналогично для Марковской модели первого порядка) называется энтропия для алфавита, где известны вероятности появления одной буквы после другой (то есть, вероятности двухбуквенных сочетаний):

где  — это состояние, зависящее от предшествующего символа, и

— это состояние, зависящее от предшествующего символа, и  — это вероятность

— это вероятность  при условии, что

при условии, что  был предыдущим символом.

был предыдущим символом.

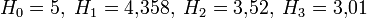

Например, для русского языка без буквы «ё»  [3].

[3].

Через частную и общую условные энтропии полностью описываются информационные потери при передаче данных в канале с помехами. Для этого применяются так называемыеканальные матрицы. Для описания потерь со стороны источника (то есть известен посланный сигнал) рассматривают условную вероятность  получения приёмником символа

получения приёмником символа  при условии, что был отправлен символ

при условии, что был отправлен символ  . При этом канальная матрица имеет следующий вид:

. При этом канальная матрица имеет следующий вид:

|  | … |  | … |  | |

|  |  | … |  | … |  |

|  |  | … |  | … |  |

| … | … | … | … | … | … | … |

|  |  | … |  | … |  |

| … | … | … | … | … | … | … |

|  |  | … |  | … |  |

Очевидно, вероятности, расположенные по диагонали, описывают вероятность правильного приёма, а сумма всех элементов столбца даёт вероятность появления соответствующего символа на стороне приёмника —  . Потери, приходящиеся на передаваемый сигнал

. Потери, приходящиеся на передаваемый сигнал  , описываются через частную условную энтропию:

, описываются через частную условную энтропию:

Для вычисления потерь при передаче всех сигналов используется общая условная энтропия:

означает энтропию со стороны источника, аналогично рассматривается

означает энтропию со стороны источника, аналогично рассматривается  — энтропия со стороны приёмника: вместо

— энтропия со стороны приёмника: вместо  всюду указывается

всюду указывается  (суммируя элементы строки можно получить

(суммируя элементы строки можно получить  , а элементы диагонали означают вероятность того, что был отправлен именно тот символ, который получен, то есть вероятность правильной передачи).

, а элементы диагонали означают вероятность того, что был отправлен именно тот символ, который получен, то есть вероятность правильной передачи).

Взаимная энтропия

Взаимная энтропия или энтропия объединения предназначена для расчёта энтропии взаимосвязанных систем (энтропии совместного появления статистически зависимых сообщений) и обозначается  , где

, где  характеризует передатчик, а

характеризует передатчик, а  — приёмник.

— приёмник.

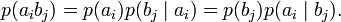

Взаимосвязь переданных и полученных сигналов описывается вероятностями совместных событий  , и для полного описания характеристик канала требуется только одна матрица:

, и для полного описания характеристик канала требуется только одна матрица:

|  | … |  | … |  |

|  | … |  | … |  |

| … | … | … | … | … | … |

|  | … |  | … |  |

| … | … | … | … | … | … |

|  | … |  | … |  |

Для более общего случая, когда описывается не канал, а в целом взаимодействующие системы, матрица необязательно должна быть квадратной. Очевидно, сумма всех элементов столбца с номером  даёт

даёт  , сумма строки с номером

, сумма строки с номером  есть

есть  , а сумма всех элементов матрицы равна 1. Совместная вероятность

, а сумма всех элементов матрицы равна 1. Совместная вероятность  событий

событий  и

и  вычисляется как произведение исходной и условной вероятности:

вычисляется как произведение исходной и условной вероятности:

Условные вероятности производятся по формуле Байеса. Таким образом, имеются все данные для вычисления энтропий источника и приёмника:

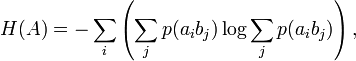

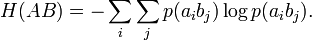

Взаимная энтропия вычисляется последовательным суммированием по строкам (или по столбцам) всех вероятностей матрицы, умноженных на их логарифм:

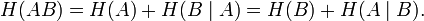

Единица измерения — бит/два символа, это объясняется тем, что взаимная энтропия описывает неопределённость на пару символов: отправленного и полученного. Путём несложных преобразований также получаем

Взаимная энтропия обладает свойством информационной полноты — из неё можно получить все рассматриваемые величины.

История

В 1948 году, исследуя проблему рациональной передачи информации через зашумлённый коммуникационный канал, Клод Шеннон предложил революционный вероятностный подход к пониманию коммуникаций и создал первую, истинно математическую, теорию энтропии. Его сенсационные идеи быстро послужили основой разработки двух основных направлений:теории информации, которая использует понятие вероятности и эргодическую теорию для изучения статистических характеристик данных и коммуникационных систем, и теории кодирования, в которой используются главным образом алгебраические и геометрические инструменты для разработки эффективных кодов.

Понятие энтропии, как меры случайности, введено Шенноном в его статье «A Mathematical Theory of Communication», опубликованной в двух частях в Bell System Technical Journal в 1948 году.

Контрольные вопросы:

- Что такое информационная энтропия?

- Какие виды энтропии известный на сегодняшний день?

- Определение по Шеннону.

- Определение с помощью собственной информации

- Математические свойства

- Эффективность энтропии

Тема 3. Количество информации и избыточность.

Цель лекции: Изучить понятие избыточности

Вопросы:

1. Как связаны между собой понятия количества информации и энтропия?

2. Определите понятие избыточности.

3. Определите количество информации в сообщении, составленном из к неравновероятных символов.

4. Дайте определение дифференциальной энтропии и сформулируйте её основные свойства.

Количество информации есть уменьшение энтропии вследствие опыта.

Если неопределенность снимается полностью, то информация равна энтропии:

І = Н ,

В противном случае – разнице между начальной и конечной энтропии :

I=H1-H2 (3.1)

Наибольшее количество информации получается, когда полностью снимается максимальная неопределенность – когда вероятности всех событий были одинаковы

=Нмакс

=Нмакс

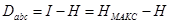

р – вероятность реализации в условиях равной вероятности всех событий. Избыточность информации есть разность между максимально возможным колличеством информации и энтропией:

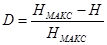

(3.2)

(3.2)

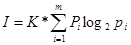

Количество информации может быть представленно как произведение общего числа сообщений К на среднюю энтропию:

Для случая равновероятных и взаимонезависимых символов первичного алфавита количество информации в К сообщениях алфавита m равно:

(бит).

(бит).

Для неравновероятных алфавитов энтропия на символ алфавита :

(бит/символ),

(бит/символ),

А количество информации (КИ) в сообщении, составленном из к неравновероятных символов

Требования, которым должна удовлетворять количество информации, следующие:

1. Аддитивность. КИ в двух независимых сообщениях должно равняться сумме КИ в каждом из них.

2. Необходимость монотонного возрастания с увеличением возможностей выбора состояния (чем больше число состояний, тем больше неопределенность).

3. КИ, содержащейся в сообщении о достоверном событии, и неопределенность должны равняться нулю.

4. Независимость КИ от качественного содержания сообщения, в частности от степени его важности для получателя, от степени возможных последствий и т. д.