АЛУ и УУ составляют процессор.

Процессор, выполненный в интегральном исполнении в виде одной или нескольких микросхем называют микропроцессором.

АЛУ –это функциональная часть процессора, предназначенная для выполнения арифметических и логических операций над кодами данных и команд.

УУ автоматически управляет вычислительным процессом, посылая всем другим устройствам сигналы, предписывающие им те или иные действия.

ЗУ предназначено для хранения введенной информации, программы вычисления и промежуточных результатов вычисления.

Информация, содержащаяся в памяти ЗУ и необходимая для решения задачи, по мере необходимости выводится из него и передается в процессор. После необходимых преобразований она вновь заносится в память.

Увв и Увыв обеспечивают ЭВМ связь с внешним миром.

Увв осуществляет считывание информации (программ и данных) с определенных носителей и представляет считанную информацию в форме электрических сигналов, воспринимаемых памятью.

Увыв предназначено для автоматического приема результатов вычислений, хранения и выдачи этих данных в виде, удобном для дальнейшего использования.

8Математическая теория информации не охватывает всего богатства содержания понятия «информация», поскольку отвлекается от содержательной (смысловой) стороны сообщения

2) Понятие «информации»

Слово «информация» происходит от латинского и означает сведение, разъяснение, ознакомление.

Понятие информации является базовым, т. е. должно быть пояснено на примерах или выявлено путем их сопоставления с содержанием других понятий.

Понятие «информация»является общенаучным, так как используется в различных науках и при этом в каждой науке это понятие связано с различными системами понятий.

1. Философское понятие информации: «информация есть отражение реального мира». Человек получает информацию с помощью органов чувств: 80-90% с помощью зрения, 10-15% с помощью слуха, 1-2% с помощью других органов чувств (обоняние, осязание и вкус).

Информация– это сведения, изменяющие наши знания об окружающем мире и понимание его.

2.Информация в физике.В физике мерой беспорядка, хаоса для термодинамической системы является энтропия системы, тогда как информация (анти энтропия)является мерой упорядоченности и сложности системы. По мере увеличения сложности системы величина энтропии уменьшается, а величина информации увеличивается. Таким образом, в физике информация рассматривается как анти энтропия или энтропия с обратным знаком.

3. Математическая теория информации (американский ученый Клод Шеннон): информативность сообщения характеризуется содержащейся в нем полезной информацией – той частью сообщения, которая снимает полностью или уменьшает неопределенность какой-либо ситуации, т. е. информация – это уменьшение неопределенности наших знаний. Такой подход к информации позволяет ее количественно измерять.

Количественная оценка информации

Количество информации

Существует формула, которая связывает между собой количество возможных информационных сообщений и количество информации, которое несет полученное сообщение:

| N=2H |

Где: N-количество возможных информационных сообщений;

H-количество информации, которое несет полученное сообщение;

Отсюда следует формула Хартли (для равновероятностных сообщений), которая позволяет определить количество информации.

| H=log2N |

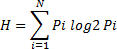

В случае, когда вероятность событий неодинакова, для определения количества информации достаточно для выявления сообщения использовать формулу Шеннона:

Где:  -вероятность того, что система находится в состоянии i ;

-вероятность того, что система находится в состоянии i ;

N-количество возможных состояний;

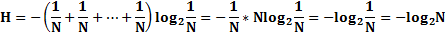

В случае равновероятностных сообщений  =1/N, тогда формула Шеннона переходит в формулу Хартли.

=1/N, тогда формула Шеннона переходит в формулу Хартли.

В случае равновероятностных сообщений Pi = 1/N, тогда формула Шеннона переходит в формулу Хартли:

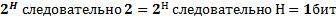

(22.09.2015) Для количественного выражения любой величины необходимо определить единицу измерения. За единицу измерения количества информации принимается такое количество информации, которое содержится в сообщении, уменьшающем неопределенность знания в два раза. Такая единица называется битом. В примере с монетой сообщение несет 1 бит информации (N=  )

)