Элементы информационной теории измерений

В основе информационной теории измерений [16, 35] лежит понятие об энтропии случайной величины как меры ее неопределенности (множественной совокупности ее возможных значений). Чем больше число значений может принимать дискретная случайная величина или чем больше диапазон непрерывной случайной величины, тем больше их энтропия.

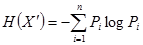

Согласно К. Шеннону, энтропия Н дискретной случайной величины X' , которая может принимать n значения (i = 1, 2, ..., п)ссоответствующими вероятностями Рi выражается как

(9.1)

(9.1)

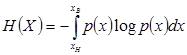

Энтропия непрерывной случайной величины X, имеющей плотность p(x) , распределения определяется соотношением

(9.2)

(9.2)

где хН , хВ - нижняя и верхняя границы диапазона значений величины X.

В зависимости от выбора основания логарифма в формулах (9.1) и (9.2) энтропия может выражаться в следующих единицах: дит при использовании десятичных логарифмов; бит для двоичных логарифмов и нит для натуральных логарифмов.

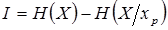

В соответствии с общими положениями теории информации, предложенными и обоснованными К. Шенноном, количество информации I ,получаемое при измерении X (или X'), равно разности априорной (до измерений) Н(X) и апостериорной (после получения результата измерений - хp)- Н(Х/хр) энтропии этой (измеряемой) величины, т.е.

(9.3)

(9.3)

Следовательно, количество информации, получаемой при измерении, соответствует уменьшению энтропии от значения Н(Х), которое характеризует неопределенность измеряемой величины перед измерением, до значения Н(Х/хр) , т. е. оно характеризует остающуюся после получения результата хр , неопределенность.

Таким образом. в данном случае (с общих позиций теории информации) измерение может трактоваться как „сокращение области неопределенности измеряемой величины".

Величину Н(Х/хр) называют условной энтропией (при условии, что получено хр).

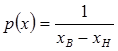

Пусть до проведения измерений было известно, что измеряемая величина X может принимать значения в диапазоне от хн до xв (например, рабочий диапазон показаний измерительного прибора) и вероятность значений X в этом диапазоне одинакова, т.е

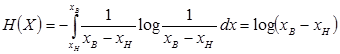

Тогда в соответствии с формулой (9.2) исходная (априорная) энтропия будет

(9.4)

(9.4)

После проведения измерения и получения результата хр мы можем утверждать, что измеряемая величина (ее действительное значение) лежит в пределах от хр — Dн до хр + Dв, где Dн , Dв - нижняя и верхняя границы погрешности измерения D . Примем (для наглядности выводов) , что погрешность лежит в границах ± D и плотность распределения ее значений –

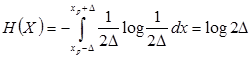

Тогда условная энтропия, оставшаяся после получения результата хр , будет равна

(9.5)

(9.5)

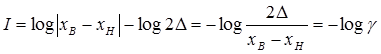

Следовательно, полученное при измерении количество информации на основании формулы (9.3) составит

(9.6)

(9.6)

Другими словами, количество информации, полученное при измерении, равно логарифму приведенной погрешности результата.

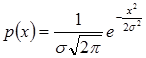

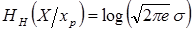

Нетрудно показать, что условная энтропия величины, подчиняющейся нормальному распределению с плотностью  , равна

, равна

. (9.7)

. (9.7)

Сравнивая формулы (9.5) и (9.7) , можно заключить, что с информационной точки зрения результат, имеющий нормальное распределение погрешности, дает такое же количество информации, как и результат с равномерным распределением погрешности, если только  .

.

Вводится понятие о некой обобщенной характеристике точности измерений (и средств измерений) - энтропийной погрешности. При этом энтропийной погрешностью считается погрешность с равномерным распределением, которая вносит такое же дезинформационное действие, что и погрешность с данным законом распределения.

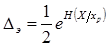

Математически энтропийное значение погрешности, определяемое как половина интервала неопределенности, выражается следующим образом:

(9.8)

(9.8)

Зависимость между энтропийным и средним квадратическим значениями погрешности может быть представлена как

,

,

где коэффициент  называется энтропийным коэффициентом закона распределения.

называется энтропийным коэффициентом закона распределения.

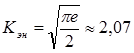

Наибольшей энтропией (неопределенностью) при заданном значении σ обладает нормальное распределение. Поэтому оно имеет наибольший, предельно возможный энтропийный коэффициент, равный на основании соотношений (9.7) и (9.8)  (для натуральных логарифмов) .

(для натуральных логарифмов) .

Именно поэтому в неопределенной ситуации в качестве модели распределения погрешности при заданной дисперсии принимается нормальное распределение.

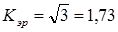

Для равномерного распределения  и

и  .

.

Аналогичным образом могут быть вычислены значения Кэ для любых других законов распределения.

На основе информационной теории доказывается существование предела точности измерений, т. е. принципиальной невозможности его дальнейшего уточнения. Этот предел определенности в микромире известен как „правило неопределенности Гейзенберга".

Кроме того, также делается вывод, что передача информации от одного объекта к другому может происходить только путем их энергетического взаимодействия. При отсутствии обмена энергией между объектом и средством измерения передача информации (измерение) невозможны.

Таковы основные положения информационной теории измерений.

Вопросы к разделу

1. Что такое неопределенность?

2. Что такое энтропия?

3. Что такое дит, бит, нит?

4. Что подразумевается под количеством информации?

5. Что такое энтропийный коэффициент закона распределения?

6. В чем состоит правило неопределенности Гейзенберга?

7. Как происходит передача информации от одного объекта другому?

8. Возможна ли передача информации между объектом и средством измерения ?

10. СИГНАЛЫ ИЗМЕРИТЕЛЬНОЙ ИНФОРМАЦИИ

10.1. Общие сведения.

В современных средствах измерений измеряемая величина поступает во вход первичного преобразователя как сигнал измерительной информации. Сигнал как материальный носитель информации (сигналоноситель) представляет собой некоторый физический процесс, один из параметров которого содержит количественную информацию об измеряемой физической величине и называется информативным параметром. Остальные параметры сигнала называют неинформативными. При дальнейшем прохождении сигналов в средствах измерений они могут преобразовываться из одного вида в другой, более удобный для последующей передачи, хранения, обработки или восприятия оператором, - т.е. сигнал нормируется и представляется стандартным сигналом, имеющим определенный диапазон значений.

Природа физических процессов, несущих измерительную информацию может быть самая разнообразная. Самым распространенным носителем является электромагнитное поле, которое используется в измерительных приборах и преобразователях

У электрических сигналов информативными параметрами могут быть мгновенные значения постоянных токов и напряжений, амплитудные, средневыпрямленные или действующие значения синусоидальных токов и напряжений, а также их частота или фаза и др.

Так, например, при измерении действующего напряжения силовой сети переменного тока входным сигналом является синусоидальное напряжение, а измеряемой величиной — действующее значение этого напряжения, являющееся в данном случае его информативным параметром.

Форма сигналов весьма разнообразная, одним из самых распространенных является импульс. Импульс – динамическая величина произвольной формы, мгновенное значение которой отлично от нуля в течение ограниченного интервала времени. Используются следующие формы импульсов: прямоугольная, трапецеидальная, треугольная, пилообразная, дельта-импульс (функция Дирака), колоколообразная. Различают также однополярные и двуполярные импульсы.

Существует множество различных видов сигналов. По характеру изменения измерительные сигналы делятся на аналоговые, дискретные и цифровые. Аналоговые сигналы описываются непрерывной или кусочно-непрерывной функцией  . Дискретные сигналы – это сигналы прерывистые во времени или по уровню. Квантованные сигналы – это дискретные сигналы кратные определенной величине (уровню квантования). Цифровые сигналы — квантованные по уровню и дискретные по времени сигналы.

. Дискретные сигналы – это сигналы прерывистые во времени или по уровню. Квантованные сигналы – это дискретные сигналы кратные определенной величине (уровню квантования). Цифровые сигналы — квантованные по уровню и дискретные по времени сигналы.

По степени наличия априорной информации измерительные сигналы делятся на детерминированные, квазидетерминированные и случайные.

Детерминированный сигнал — это сигнал, закон изменения которого известен, а модель не содержит неизвестных параметров. Мгновенные значения детерминированного сигнала известны в любой момент времени, поэтому эти сигналы используются в различных эталонах.

Квазидетерминированные сигналы — это сигналы с частично известным характером изменения во времени, т.е. с одним или несколькими неизвестными параметрами. Подавляющее большинство измерительных сигналов являются квазидетерминированными.

Случайные сигналы В этом случае сигнал рассматривают как случайный процесс, а изменение сигнала во времени и пространстве характеризуется законом распределения, математическим ожиданием, дисперсией и корреляционной функцией.

В общем случае сигналы представляют в виде комбинации детерминированной и случайной составляющих, т.е. в виде суммы сигнала измерительной информации (квазидетерминированная составляющая) и помехи (случайная составляющая).

Помехой называется сигнал, вызывающий нежелательное искажающее воздействие на измерение, т.е. однородный с измерительным, действующий одновременно с ним и приводящий к появлению погрешности измерения.

По месту возникновения помехи делятся на внешние и внутренние. Причиной возникновения внешних помех являются природные процессы и работа различных технических устройств (индустриальные помехи). Внутренние помехи обусловлены процессами, происходящими при работе самого средства измерений.

Различают следующие виды помех: флуктуационные, сосредоточенные и импульсные.

Флуктуационные помехи (шумы) представляют собой хаотическое, беспорядочное изменение во времени сигнала, однородного с измеряемым, в каком-либо месте средства измерений. Например, внутренние шумы измерительных электронных устройств, которые разделяют на следующие виды: тепловой шум (шум Джонсона), по своим свойствам близкий к белому шуму; дробовый, обусловленный движением электронов — дискретных носителей электрического тока (имеет равномерный спектр, т.е. является белым); фликкер-шум, у которых спектральная мощность на декаду частоты примерно постоянна (розовые шумы).

Способы борьбы с помехами зависят от их спектрального состава, вида измерительного сигнала и помехи. Многие из электрических помех можно устранить путем экранирования, заземления средства измерений, применения специальных фильтров и т.п.

10.2. Математические модели сигналов.

Под математической моделью понимают описание сигнала на формальном языке математики, т. е. с помощью формул, неравенств или логических соотношений. Для описания одних и тех же реальных физических сигналов могут быть использованы различные математические модели. Выбор модели определяется адекватностью модели реальному сигналу, простотой математического описания, назначением модели и др.

Существуют различные подходы к построению математических моделей сигналов. При этом в основном используются элементарные функции.

1. Постоянный сигнал  , где А – параметр.

, где А – параметр.

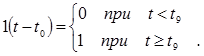

2. Единичная функция 1(t) , или единичный скачок, является единичной ступенчатой функцией Хевисайда (рис. 14,а), служит для представления единичного сигнала, действующего на входе цепи с момента t0 , поэтому

Примечание. Следует обратить внимание на нетрадиционность обозначений: функция обозначается цифрой «единица», а не как обычно латинской или греческой буквой. Хевисайд английский ученый-физик автор знаменитого уравнения теории относительности  .

.

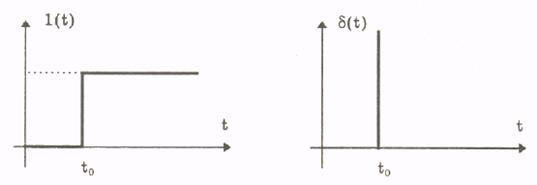

а б

Рис. 14. Графики: а - функции Хевисайда (единичной функции) ;

б - функции Дирака (дельта-функции)

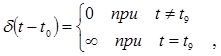

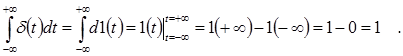

3. Дельта–функция  , или функция Дирака (рис. 14,б), служит для описания внешнего воздействия называемого единичным импульсом

, или функция Дирака (рис. 14,б), служит для описания внешнего воздействия называемого единичным импульсом

которая определяется как производная по времени единичной функции

и представляет собой предельный случай импульса очень большого значения и очень малой продолжительности, когда его длительность стремится к нулю, но площадь сохраняется равной единице

4. Линейная функция  . Вид сигнала повторяет измеряемую величину

. Вид сигнала повторяет измеряемую величину  с точностью до постоянного множителя, равного

с точностью до постоянного множителя, равного  .

.

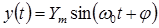

5. Гармоническая функция

В гармонических сигналах информативными параметрами могут служить: амплитуда  , угловая частота w или фаза j .

, угловая частота w или фаза j .

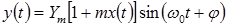

Изменение информативного параметра гармонического сигнала в соответствии с изменением измеряемой величины х называют модуляцией этого сигнала. Если с изменением х в гармоническом сигнале меняется один из параметров  или

или  , то говорят, что осуществляется соответственно амплитудная — АМ, частотная — ЧМ или фазовая—ФМ модуляция. Например уравнение амплитудно-модулированного гармонического сигнала имеет вид

, то говорят, что осуществляется соответственно амплитудная — АМ, частотная — ЧМ или фазовая—ФМ модуляция. Например уравнение амплитудно-модулированного гармонического сигнала имеет вид

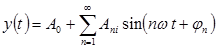

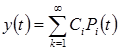

6. Спектральное представление основывается на преобразовании Фурье сигналов  . Применяя разложение в ряд Фурье, периодический сигнал

. Применяя разложение в ряд Фурье, периодический сигнал  может быть представлен суммой гармонических составляющих:

может быть представлен суммой гармонических составляющих:

,

,

где  —постоянная составляющая;

—постоянная составляющая;  и

и  — амплитуда и фаза n –ой гармонической составляющей сигнала; n — номер гармоники. Множество значений

— амплитуда и фаза n –ой гармонической составляющей сигнала; n — номер гармоники. Множество значений  и

и  образуют соответственно амплитудный и фазовый спектры сигнала. Наличие высших гармоник в спектре периодического сигнала количественно описывается коэффициентом гармоник. Он равен отношению среднеквадратического значения сигнала суммы всех его гармоник, кроме первой, к среднеквадратическому значению первой гармоники.

образуют соответственно амплитудный и фазовый спектры сигнала. Наличие высших гармоник в спектре периодического сигнала количественно описывается коэффициентом гармоник. Он равен отношению среднеквадратического значения сигнала суммы всех его гармоник, кроме первой, к среднеквадратическому значению первой гармоники.

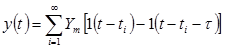

7. Периодическая последовательность прямоугольных импульсов выражается формулой

где  — амплитуда импульса; t — длительность импульса;

— амплитуда импульса; t — длительность импульса;  - период следования импульса.

- период следования импульса.

Частота f - количество колебаний периодически изменяющейся величины в единицу времени. Она равна величине, обратной периоду  . Отношение периода к длительности прямоугольного импульса

. Отношение периода к длительности прямоугольного импульса  называется скважностью, а обратная величина

называется скважностью, а обратная величина  — коэффициентом заполнения. При скважности, равной двум, последовательность импульсов называют меандром.

— коэффициентом заполнения. При скважности, равной двум, последовательность импульсов называют меандром.

Периодическая последовательность импульсов может быть модулирована. Модуляция — это воздействие измерительного сигнала на какой-либо параметр стационарного сигналоносителя. При этом в зависимости от того, какой из параметров функционально связан с х , имеет место соответственно амплитудно-импульсная (АИМ) , частотно-импульсная (ЧИМ) или широтно-импульсная (ШИМ) модуляция сигнала.

8. Для точного описания сигналов сложной структуры приходится применять сложные математические выражения, например, использовать бесконечные и конечные ряды

где  — некоторые выбранные для аппроксимации базисные функции (полиномы);

— некоторые выбранные для аппроксимации базисные функции (полиномы);  — весовые коэффициенты.

— весовые коэффициенты.

В качестве базисных функций  применяют полиномы Лагранжа, Лежандра, Чебышева, ортогональные полиномы и др.

применяют полиномы Лагранжа, Лежандра, Чебышева, ортогональные полиномы и др.

9. При описании электрических сигналов широко используются функции комплексного переменного, которые очень удобны при описании электромагнитных полей.

Термины и определения основных понятий в области измерительных радиотехнических сигналов и вид их характеристик устанавливает ГОСТ 16465-70 "Сигналы радиотехнические. Термины и определения".

10.3. Преобразование непрерывных измерительных сигналов: дискретизация и квантование

Развитие измерительной техники потребовало преобразования непрерывной информации в цифровую. Для этого используются дискретизация и квантование измерительных (аналоговых) сигналов.

Примечание. Дискретный – от лат. discretus - прерывистый, дробный, состоящий из отдельных частей. Квант - от лат. quantum – сколько , quantitas – количество.

Дискретизация представление непрерывного сигнала  совокупностью дискретных значений

совокупностью дискретных значений  . Наиболее часто применяют равномерную дискретизацию сигналов, при которой интервал времени между двумя соседними отсчетами — шаг дискретизации

. Наиболее часто применяют равномерную дискретизацию сигналов, при которой интервал времени между двумя соседними отсчетами — шаг дискретизации  остается постоянным.

остается постоянным.

Квантование — разделение непрерывно изменяющейся измерительной информации на некоторое количество одинаковых по значению ступеней (квантов). В процессе квантования каждому значению из некоторого бесконечного множества значений аналоговой величины ставится в соответствие одно дискретное значение из конечного множества значений. При этом возникает погрешность квантования. Эта погрешность не превосходит ступени квантования и будет тем меньше, чем больше число ступеней используется при квантовании.

Примечание. В природе квантование физических величин весьма распространено, причем казалось бы в самых неожиданных случаях, например : измерение величины - квантом служит мера (цена деления линейки, единица измерения гири); масса вещества – квантом служит молекула; электрический заряд - квантом служит заряд электрона, свет - квантом служит фотон, и т.д.

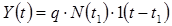

Процесс квантования описывается уравнением

,

,

где  — квантованный сигнал; q – постоянная величина;

— квантованный сигнал; q – постоянная величина;  — число квантов;

— число квантов;  — единичная функция.

— единичная функция.

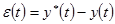

Обратной задачей дискретизации и квантованияявляется восстановление непрерывного сигнала  по его дискретным значениям

по его дискретным значениям  .

.

Восстановление исходного сигнала по совокупности дискретных отсчетов осуществляется формированием обобщенной зависимости (многочлена) различными ортогональными или ортонормированными базисными функциями, например применяют различные полиномы (см. выше п. 8). Качество приближения  и

и  определяется погрешностью

определяется погрешностью

.

.

Коэффициенты ряда и базисные функции могут выбираться на основе различных критериев, например, совпадения значений восстанавливаемого непрерывного сигнала с мгновенными значениями дискретизированного сигнала. Такой метод удобен для аналитического восстановления при автоматической обработке результатов измерения мгновенных значений дискретизированного сигнала. Восстановление периодических сигналов регламентируется теоремой Котельникова.

Если функция  удовлетворяет условиям Дирихле — ограничена, кусочно-непрерывна, имеет конечное число экстремумов — и обладает спектром с максимальной граничной частотой fс , дискретизирована циклически с периодом

удовлетворяет условиям Дирихле — ограничена, кусочно-непрерывна, имеет конечное число экстремумов — и обладает спектром с максимальной граничной частотой fс , дискретизирована циклически с периодом  , меньшим или равным

, меньшим или равным  , т.е. частота дискредитации

, т.е. частота дискредитации  , то она может быть восстановлена по всей этой совокупности ее мгновенных значений без погрешности.

, то она может быть восстановлена по всей этой совокупности ее мгновенных значений без погрешности.

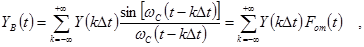

Если теорема Котельникова выполняется, то непрерывный сигнал  может быть восстановлен как сумма базисных функций, называемых рядом Котельникова:

может быть восстановлен как сумма базисных функций, называемых рядом Котельникова:

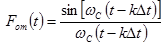

где  — круговая граничная частота спектра непрерывного сигнала

— круговая граничная частота спектра непрерывного сигнала  ;

;  — период дискретизации;

— период дискретизации;  — функция отсчетов.

— функция отсчетов.

Ряд Котельникова замечателен тем, что его коэффициенты равны мгновенным дискретизированным значениям сигнала  . Он является одним из примеров обобщенного ряда Фурье.

. Он является одним из примеров обобщенного ряда Фурье.

При использовании ряда Котельникова частота дискретизации рассчитывается по формуле  , где

, где  — коэффициент запаса, выбираемый из диапазона (1,5; 6) и учитывающий неограниченность спектра реальных сигналов;

— коэффициент запаса, выбираемый из диапазона (1,5; 6) и учитывающий неограниченность спектра реальных сигналов;  — максимальная частота в спектре сигнала.

— максимальная частота в спектре сигнала.

При восстановлении сигнала в реальных условиях погрешности естественно возникают и вызваны следующими причинами:

1) реальные сигналы имеют бесконечный спектр частот, а не ограниченный по условию теоремы;

2) мы вынуждены ограничивать число членов ряда Котельникова;

3) дискретизированные значения сигнала не являются мгновенными и т.д.

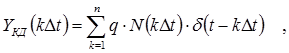

Сигналы, дискретизированные по времени и квантованные по размеру описываются математическим выражением:

где  - цифровой код (число квантов), соответствующий моменту

- цифровой код (число квантов), соответствующий моменту  ;

;  - дельта-функция (функция Дирака); q – постоянная величина.

- дельта-функция (функция Дирака); q – постоянная величина.

Вопросы к разделу

1. Чем измерительный сигнал отличается от сигнала?

2. Чем аналоговый, дискретный и цифровой сигналы отличаются друг от друга?

3. Что такое помехи, как они классифицируются?

4. Какие типы математических моделей измерительных сигналов используются в метрологии?

5. Что такое модуляции?

6. Что такое амплитудная, частотная и фазовая модуляции?

7. Что такое амплитудно-импульсная, частотно-импульсная и широтно-импульсная модуляции?

8. Что такое квантование?

9. Что такое погрешность квантования?

10. Что такое дискретизация?

11. Что утверждает теорема Котельникова?