Модели архитектур распределенной памяти:

В системе с распределенной памятью каждый процессор обладает собственной памятью и способен адресоваться только к ней. Такие системы называют мультикомпьютерами. Модели архитектур с распределенной памятью принято обозначать как архитектуры без прямого доступа к удаленной памяти (NORMA, No Remote Memory Access). Каждый процессор имеет доступ только к своей локальной памяти. Доступ к удаленной памяти возможен только путем обмена сообщениями с процессором, которому принадлежит адресуемая память. Достоинства: 1) при доступе к данным не возникает конкуренции за шину или коммутаторы. 2) отсутствие общей шины означает, что нет и связанных с этим ограничений на число процессоров: размер системы ограничивает только сеть, объединяющая процессоры. 3) снимается проблема когерентности кэш-памяти.Недостаток: сложность обмена информацией между процессорами.

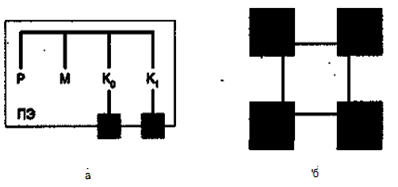

Рис 2.Вычислительная система с распределенной памятью: а - процессорный элемент; б - объединение процессорных элементов

Структура системы с распределенной памятью приведена на рисунке ниже. (а) показан один процессорный элемент (ПЭ). Он включает в себя собственно процессор (Р), локальную память (М) и два контроллера ввода/вывода (Ко и K i),

Структура системы с распределенной памятью приведена на рисунке ниже. (а) показан один процессорный элемент (ПЭ). Он включает в себя собственно процессор (Р), локальную память (М) и два контроллера ввода/вывода (Ко и K i),

(б) 4-х процессорная система, иллюстрирующая, каким образом сообщения пересылаются от одного процессора к другому. Для посылки сообщения в другой ПЭ процессор формирует блок данных в своей памяти и извещает свой локальный контроллер о необходимости передачи информации на внешнее устройство. По сети межсоединений это сообщение пересылается на приемный контроллер ввода/вывода принимающего ПЭ. Последний находит место для сообщения в собственной локальной памяти и уведомляет процессор-источник о получении сообщения.

Модель распределенной совместно используемой памяти (DSM, Distribute Shared Memory). ВС, физически будучи системой с распределенной памятью, благодаря операционной системе представляется пользователю как система с общей памятью.

Параллельные вычисления

Под параллельными вычислениями понимаются процессы обработки данных, в которых одновременно могут выполняться несколько операций компьютерной системы. Достижение параллелизма возможно только при выполнимости следующих требований к архитектурным принципам построения вычислительной среды:

- независимость функционирования отдельных устройств ЭВМ – это требование относится ко всем основным компонентам вычислительной системы – к устройствам ввода-вывода, к обрабатывающим процессорам и к устройствам памяти;

- избыточность элементов вычислительной системы – организация избыточности может осуществляться в следующих основных формах:

- использование специализированных устройств, таких, как отдельные процессоры для целочисленной и вещественной арифметики, устройства многоуровневой памяти (регистры, кэш);

- дублирование устройств ЭВМ путем использования нескольких однотипных обрабатывающих процессоров или нескольких устройств оперативной памяти.

- распределенные вычисления. Этот термин обычно используют для указания параллельной обработки данных, при которой используется несколько обрабатывающих устройств, достаточно удаленных друг от друга, и в которых передача данных по линиям связи приводит к существенным временным задержкам и как результат, эффективная обработка данных при данном способе организации вычислений возможна только для параллельных алгоритмов с низкой интенсивностью потоков межпроцессорных передач данных.

Дополнительной формой обеспечения параллелизма может служить конвейерная реализация обрабатывающих устройств, при которой выполнение операций в устройствах представляется в виде исполнения последовательности составляющих операцию подкоманд. Как результат, при вычислениях на таких устройствах на разных стадиях обработки могут находиться одновременно несколько различных элементов данных. Примером параллельных вычислительных систем могут служить кластеры. Кластер (от англ. Cluster- скопление) – это группа компьютеров, объединенных в локальную вычислительную сеть (ЛВС) и способных работать в качестве единого вычислительного ресурса.