Измерение и представление информации

Любая классификация всегда относительна. Один и тот же объект может быть классифицирован по разным признакам или критериям. Часто в зависимости от условий внешней среды объект может быть отнесен к разным классификационным группировкам. В основу классификации информации, циркулирующей между объектами, положены пять наиболее общих признаков:

q место возникновения информации;

q стадия ее обработки;

q способ отображения информации;

q стабильность информации;

q функция управления информациией.

По первому признаку информацию можно разделить на входную, выходную, внутреннюю и внешнюю. Входная информация – — это информация, поступающая на вход какого-нибудь устройства или объекта. Выходная информация – — это информация на выходе объекта, предназначенная для передачи другому объекту. Одна и та же информация может быть входной для одного объекта и выходной для другого. Внутренняя информация возникает внутри объекта, внешняя за его пределами.

По второму признаку информация разделяется на первичную, вторичную, промежуточную и результатную. Первичная информация возникает непосредственно в процессе деятельности объекта и регистрируется на начальной стадии. Вторичная получается в результате обработки первичной информации, промежуточная используется в качестве исходных данных для последующих расчетов, результатная применяется для выработки управленческих решений.

По способу отображения информация подразделяется на текстовую и графическую. Текстовая информация – — это совокупность алфавитных, цифровых и специальных символов, графическая – — это различного рода графики, диаграммы, схемы, рисунки.

По стабильности информация может быть переменной (текущей) и постоянной. Постоянная информация подразделяется на справочную, нормативную и плановую.

Наконец, по функциям управления обычно классифицируют информацию экономического типа. При этом информация подразделяется на плановую, нормативно-справочную и оперативную (текущую). Плановая информация – — это информация о параметрах объекта на будущий период, нормативно-справочная содержит различные нормативные и справочные данные, оперативная характеризует текущий момент.

Определить понятие “"количество информации”" довольно сложно. При анализе информации социального плана на первое место выходят такие ее свойства, как истинность, своевременность, ценность, полнота и т. п. Обращение к качественной стороне информации породило синтаксический, семантический и прагматический подход к ее оценке.

При синтаксическом подходе учитывают формально-структурные характеристики информации без рассмотрения ее смыслового содержания. Это тип носителя, способ представления информации, скорость передачи и обработки, размеры кодов и т. п. Все это – — внешняя сторона структурных характеристик информации.

Семантический (смысловой) подход определяет степень соответствия образа объекта и самого объекта. Эта сторона учитывает смысловые связи, содержание информации, служит для формирования понятий и их обобщения.

Прагматический подход отражает отношение информации и еёе потребителя, соответствие информации целям управления. Этот подход связан с ценностью и полезностью использования информации для принятия решений.

Все эти соображения, тем не менее, не противоречат важному результату теории информации о том, что в определенных, весьма широких условиях, можно, пренебрегая качественными особенностями информации, выразить еёе количество числом, а следовательно, сравнивать количество информации, содержащейся в различных группах данных. Количеством информации называют числовую характеристику информации, отражающую ту степень неопределенности, которая исчезает после получения информации.

Исторически возникли два подхода к определению количества информации в синтаксическом смысле: вероятностный и “"объемный”". Вероятностный подход развил в конце 1940 гг. американский математик Шеннон[1]*, а “"объемный”" возник с изобретением ЭВМ. Понятия “"информация”", “"неопределенность”", “"возможность выбора”" тесно связаны. Получаемая информация уменьшает число возможных вариантов выбора (т. е. неопределенность), а полная информация не оставляет вариантов вообще. “"Объемный”" подход самый простой. За единицу информации здесь принимается один бит. При этом невозможно нецелое число битов. Это количество информации, при котором неопределенность уменьшается вдвое, т. е. это ответ на вопрос, требующий односложного разрешения – — да или нет. Однако бит слишком мелкая единица измерения информации. На практике чаще применяются более крупные единицы, например, байт и производные от него:

q 1 Килобайт (Кбайт) = 1024 байт =  байт;

байт;

q 1 Мегабайт (Мбайт) = 1024 Кбайт =  байт;

байт;

q 1 Гигабайт (Гбайт) = 1024 Мбайт =  байт;

байт;

q 1 Терабайт (Тбайт) = 1024 Гбайт =  байт.

байт.

За единицу информации можно было бы выбрать количество информации, необходимое для различения, например, десяти равновероятных сообщений. Это будет не двоичная (бит), а десятичная (дит) единица информации. Такая единица существует, но используется в компьютерной технике редко, что связано с аппаратными возможностями компьютеров.

При вероятностном подходе необходимо определить величину, измеряющую неопределенность – — энтропию, которая обычно обозначается буквой  H. За количество информации, которое получено в ходе осуществления опыта принимается разность неопределенностей “"до”" и “"после”" опыта:

H. За количество информации, которое получено в ходе осуществления опыта принимается разность неопределенностей “"до”" и “"после”" опыта:  . Очевидно, что в случае, когда получен конкретный результат, имевшаяся неопределенность снята

. Очевидно, что в случае, когда получен конкретный результат, имевшаяся неопределенность снята  , и, таким образом, количество полученной информации совпадает с первоначальной энтропией, т. е. неопределенность, заключенная в опыте, совпадает с информацией об исходе этого опыта. Таким образом, количество информации об объекте обратно пропорционально энтропии объекта, а сама энтропия является мерой недостающей информации.

, и, таким образом, количество полученной информации совпадает с первоначальной энтропией, т. е. неопределенность, заключенная в опыте, совпадает с информацией об исходе этого опыта. Таким образом, количество информации об объекте обратно пропорционально энтропии объекта, а сама энтропия является мерой недостающей информации.

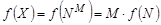

Рассмотрим в качестве примера опыт, связанный с бросанием правильной игральной кости, имеющей  граней. Величина

граней. Величина  и энтропия данного опыта

и энтропия данного опыта  связаны между собой некоторой функциональной зависимостью

связаны между собой некоторой функциональной зависимостью  . Определим вид этой функции. Если варьировать число граней

. Определим вид этой функции. Если варьировать число граней  и число бросаний кости

и число бросаний кости  , то общее число исходов опыта будет равно

, то общее число исходов опыта будет равно  . Ситуацию с бросанием кости

. Ситуацию с бросанием кости  раз можно рассматривать как некую сложную систему, состоящую из независимых друг от друга подсистем – — “"однократных бросаний кости”". Энтропия такой системы в

раз можно рассматривать как некую сложную систему, состоящую из независимых друг от друга подсистем – — “"однократных бросаний кости”". Энтропия такой системы в  раз больше, чем энтропия одной системы, т. е.

раз больше, чем энтропия одной системы, т. е.  . Но

. Но  , отсюда

, отсюда  . Подставим полученное значение

. Подставим полученное значение  в формулу для

в формулу для  , тогда

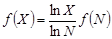

, тогда  . Обозначая через

. Обозначая через  положительную константу

положительную константу  , т. к.

, т. к.  , получим

, получим  . Обычно принимают

. Обычно принимают  , таким образом получаем формулу Хартли[2]*

, таким образом получаем формулу Хартли[2]*

(1.11.1)

(1.11.1)

Очевидно, что  будет равно единице, если

будет равно единице, если  , т. е. в качестве единицы информации принимается еёе количество, связанное с проведением опыта, состоящего в получении одного из двух равновероятных исходов. Если рассматривать

, т. е. в качестве единицы информации принимается еёе количество, связанное с проведением опыта, состоящего в получении одного из двух равновероятных исходов. Если рассматривать  равновероятных исходов, то можно считать, что на долю каждого исхода приходиться одна

равновероятных исходов, то можно считать, что на долю каждого исхода приходиться одна  -я часть общей неопределенности опыта

-я часть общей неопределенности опыта  , а вероятность

, а вероятность  -го исхода

-го исхода  равна

равна  . Тогда

. Тогда

. (1.11.2)

. (1.11.2)

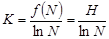

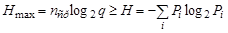

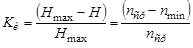

Формула (1.11.2) называется формулой Шеннона.

Пример 1. Определим количество информации, связанное с появлением каждой буквы в сообщении: “"Жил-был у бабушки серенький козлик”".

В этом сообщении 34 знака. Частоты и вероятности появлений букв в сообщении приведены в табл. 1.11.

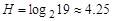

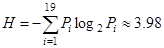

По формуле Хартли имеем  бит, аналогично по формуле Шеннона

бит, аналогично по формуле Шеннона  бит. Это значение меньше предыдущего. Величина

бит. Это значение меньше предыдущего. Величина  , вычисленная по формуле (1.10.1), является максимальным количеством информации, приходящейся на один знак в сообщении.

, вычисленная по формуле (1.10.1), является максимальным количеством информации, приходящейся на один знак в сообщении.

Таблица 1.11. Частоты и вероятности букв в сообщении

| Номер | Буква | Частота |  | Номер | Буква | Частота |  |

| ж | 0.0294 | к | 0.1176 | ||||

| и | 0.1176 | с | 0.0294 | ||||

| л | 0.0883 | е | 0.0589 | ||||

| - | 0.0294 | р | 0.0294 | ||||

| б | 0.0883 | н | 0.0294 | ||||

| ы | 0.0294 | ь | 0.0294 | ||||

| пробел | 0.1176 | й | 0.0294 | ||||

| а | 0.0294 | о | 0.0294 | ||||

| у | 0.0589 | з | 0.0294 | ||||

| ш | 0.0294 |

бит. Это значение меньше предыдущего. Величина

бит. Это значение меньше предыдущего. Величина  , вычисленная по формуле (1.10.1), является максимальным количеством информации, приходящейся на один знак в сообщении.

, вычисленная по формуле (1.10.1), является максимальным количеством информации, приходящейся на один знак в сообщении.

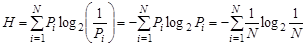

Изложенный подход хорошо применим при анализе технической информации. В информации социального плана на первый план выступают такие ее свойства, как истинность, своевременность, ценность, полнота и т. п. Обращение к качественной стороне информации породило иные подходы к ее оценке. При семантическом подходе информация рассматривается с точки зрения как формы, так и содержания. Для измерения смыслового содержания информации, т. е. ее количества на семантическом уровне наибольшее признание получила тезаурусная мера. Эта мера связывает семантические свойства информации со способностью пользователя принимать поступившие сообщения.

|

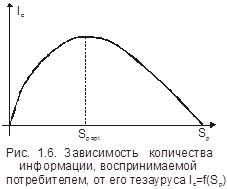

Рис. 1.6. Зависимость количества информации, воспринимаемой потребителем, от его тезауруса

Тезаурусом называется словарь или свод данных, полностью охватывающий термины и понятия какой-нибудь специальной сферы, т. е. это совокупность сведений, которыми располагает объект. В зависимости от соотношений между смысловым содержанием информации  и тезаурусом пользователя

и тезаурусом пользователя  изменяется количество семантической информации

изменяется количество семантической информации  , воспринимаемой пользователем. При

, воспринимаемой пользователем. При  пользователь не воспринимает, т. е. не понимает поступающую информацию; при

пользователь не воспринимает, т. е. не понимает поступающую информацию; при  пользователь все знает, и поступающая информация ему не нужна (см. рис. 1.6). Максимальное количество семантической информации

пользователь все знает, и поступающая информация ему не нужна (см. рис. 1.6). Максимальное количество семантической информации  пользователь приобретает при согласовании еёе смыслового содержания

пользователь приобретает при согласовании еёе смыслового содержания  со своим тезаурусом

со своим тезаурусом  . В этом случае информация понятна пользователю и несет ему ранее не известные сведения (они отсутствуют в его тезаурусе).

. В этом случае информация понятна пользователю и несет ему ранее не известные сведения (они отсутствуют в его тезаурусе).

Теоремы Шеннона

При передаче сообщений по каналам связи всегда возникают помехи, приводящие к искажению принимаемых сигналов. Исключение помех при передаче сообщений является очень серьезной теоретической и практической задачей. Еёе значимость только возрастает в связи с повсеместным внедрением компьютерных телекоммуникаций. Все естественные человеческие языки обладают большой избыточностью, что позволяет сообщениям, составленным из знаков таких языков, иметь заметную помехоустойчивость.

Избыточность могла бы быть использована и при передаче кодированных сообщений в технических системах. Самый простой способ повышение избыточности – — передача текста сообщения несколько раз в одном сеансе связи. Однако большая избыточность приводит к большим временным затратам при передаче информации и требует большого объема памяти. К настоящему времени вопрос об эффективности кодирования изучен достаточно полно.

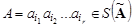

Пусть задан алфавит  , состоящий из конечного числа букв, конечная последовательность символов

, состоящий из конечного числа букв, конечная последовательность символов  из

из  называется словом, а множество всех непустых слов в алфавите

называется словом, а множество всех непустых слов в алфавите  обозначим через

обозначим через  . Аналогично для алфавита

. Аналогично для алфавита  слово обозначим

слово обозначим  , а множество всех непустых слов

, а множество всех непустых слов  .

.

Рассмотрим соответствие между буквами алфавита  и словами алфавита

и словами алфавита  :

:  . Это соответствие называется схемой алфавитного кодирования и обозначается

. Это соответствие называется схемой алфавитного кодирования и обозначается  . Алфавитное кодирование определяется следующим образом: каждому слову

. Алфавитное кодирование определяется следующим образом: каждому слову  ставится в соответствие слово

ставится в соответствие слово  , называемое кодом слова

, называемое кодом слова  . Слова

. Слова  называются элементарными кодами. Ограничением задачи передачи кодов является отсутствие помех. Требуется оценить минимальную среднюю длину кодовой комбинации.

называются элементарными кодами. Ограничением задачи передачи кодов является отсутствие помех. Требуется оценить минимальную среднюю длину кодовой комбинации.

При разработке различных систем кодирования данных получены теоретические результаты, позволяющие получить сообщение с минимальной длиной кодов. Два положения из теории эффективности кодирования известны как теоремы Шеннона.

Первая теоремаговорит о существовании системы эффективного кодирования дискретных сообщений, у которой среднее число двоичных символов (букв алфавита  ) на единицу сообщения (букву алфавита

) на единицу сообщения (букву алфавита  ) асимптотически стремитьсястремится к энтропии источника сообщения, т. е. кодирование в пределе не имеет избыточности.

) асимптотически стремитьсястремится к энтропии источника сообщения, т. е. кодирование в пределе не имеет избыточности.

Рассмотрим вновь пример 1 из раздела 1.11, закодировав рассмотренное анализированное сообщение по алгоритму Фано[3]*. В таблице . 1.12 приведены коды букв в сообщении (слова  ), длина кода

), длина кода  , вероятности букв сообщения

, вероятности букв сообщения  , величины

, величины  и

и  .

.

Таблица 1.12

| Но- мер | Бук- ва | Код |  |  |  |  |

| ж | 0.0294 | 0.1470 | –-0.1496 | |||

| и | 0.1176 | 0.3528 | –-0.3632 | |||

| л | 0.0883 | 0.3532 | –-0.3092 | |||

| - | 0.0294 | 0.1470 | –-0.1496 | |||

| б | 0.0883 | 0.3532 | –-0.3092 | |||

| ы | 0.0294 | 0.1470 | –-0.1496 | |||

| пробел | 0.1176 | 0.3528 | –-0.3632 | |||

| а | 0.0294 | 0.1470 | –-0.1496 | |||

| у | 0.0589 | 0.2356 | –-0.2406 | |||

| ш | 0.0294 | 0.1470 | –-0.1496 | |||

| к | 0.1176 | 0.3528 | –-0.3632 | |||

| с | 0.0294 | 0.1470 | –-0.1496 | |||

| е | 0.0589 | 0.2356 | –-0.2406 | |||

| р | 0.0294 | 0.1470 | –-0.1496 | |||

| н | 0.0294 | 0.1470 | –-0.1496 |

Продолжение таблицы 1.12

| Но- мер | Бук- ва | Код |  |  |  |  |

| ь | 0.0294 | 0.1470 | -–0.1496 | |||

| й | 0.0294 | 0.1470 | –-0.1496 | |||

| о | 0.0294 | 0.1470 | –-0.1496 | |||

| з | 0.0294 | 0.1470 | –-0.1496 | |||

|  |  |

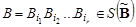

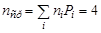

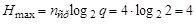

Математическое ожидание количества символов из алфавита  при кодировании равно

при кодировании равно  . Этому среднему числу символов соответствует максимальная энтропия

. Этому среднему числу символов соответствует максимальная энтропия  . Для обеспечения передачи информации, содержащейся в сообщении, должно выполняться условие

. Для обеспечения передачи информации, содержащейся в сообщении, должно выполняться условие  . В этом случае закодированное сообщение имеет избыточность. Коэффициент избыточности определяется следующим образом:

. В этом случае закодированное сообщение имеет избыточность. Коэффициент избыточности определяется следующим образом:

, (1.12.1)

, (1.12.1)

. В нашем случае

. В нашем случае  , т. е. код практически не имеет избыточности. Видно, что среднее число двоичных символов стремится к энтропии сообщения.

, т. е. код практически не имеет избыточности. Видно, что среднее число двоичных символов стремится к энтропии сообщения.

Вторая теорема Шеннона устанавливает принципы помехоустойчивого кодирования. Оказывается, что даже при наличии помех в канале связи всегда можно найти такую систему кодирования, при которой сообщение будет передано с заданной достоверностью. Основная идея всех таких кодов таковазаключается в следующем: для исправления возможных ошибок вместе с основным сообщением нужно передавать какую-то дополнительную информацию. Для реализации контроля возможных ошибок используются так называемые самокорректирующие коды, а по каналу связи вместе с  символами основного сообщения передаются ещёещёе

символами основного сообщения передаются ещёещёе  дополнительных символов, обеспечивающих избыточность кодирования и позволяющих противодействовать помехам.

дополнительных символов, обеспечивающих избыточность кодирования и позволяющих противодействовать помехам.