Архитектуры с разделяемой общей памятью

ГЛАВА 9

АРХИТЕКТУРЫ ПАРАЛЛЕЛЬНЫХ ВЫЧИСЛИТЕЛЬНЫХ СИСТЕМ

Параллельные компьютеры интересны тем, что предлагают концентрацию вычислительных ресурсов, ресурсов памяти, высокоскоростных каналов ввода/вывода для решения важных вычислительных проблем с использованием принципов параллельной обработки информации.

Именно такое неформальное определение понятия параллельного компьютера, как «совокупность процессорных элементов, которые взаимодействуют и кооперируются для быстрого решения серьезных задач», включает в себя и суперкомпьютеры с сотнями и тысячами процессоров, и рабочие станции, объединенные в сеть, и многопроцессорные рабочие станции, и встроенные системы.

Детальный анализ современных тенденции в развитии вычислительной техники в области использования вычислительных систем, развития технологической базы, компьютерных архитектур, суперкомпьютеров показывают естественный переход от однопроцессорных систем к многопроцессорным.

Целью данной главы является определение структур вычислительных систем для изучения всего многообразия параллельных компьютерных архитектур и понимания взаимосвязи и взаимного влияния между ними. Одновременно будет кратко изложен обзор эволюции параллельных машин.

По существу, параллельные компьютеры расширяли обычные концепции компьютерных архитектур за счет добавления коммуникационной среды. Коммуникационная архитектура, как и компьютерная, имеет две важные грани. Они определяются базовыми операциями взаимодействия и синхронизации, а также организационной структурой, которая реализует данные операции.

Высшим уровнем коммуникационной архитектуры является программная модель, которая реализована в параллельной системе и используется программистом в соответствии с областью применения. Модель параллельного программирования специфицирует образ частей программы, выполняемых параллельно и обменивающихся между собой информацией, и операции синхронизации, доступные для координации взаимодействия параллельных частей программы.

Ниже рассмотрены основные классические архитектуры параллельных систем, реализованные в серийных образцах.

АРХИТЕКТУРЫ С РАЗДЕЛЯЕМОЙ ОБЩЕЙ ПАМЯТЬЮ

Один из наиболее важных классов параллельных машин — многопроцессорные системы с разделяемой общей областью памяти. Ключевой характеристикой данных систем является то, что взаимодействие процессоров осуществляется как обычное выполнение инструкций доступа к памяти. Данный класс систем имеет большую историю развития, начало которой датируется 1960 г. (система ВINAC).

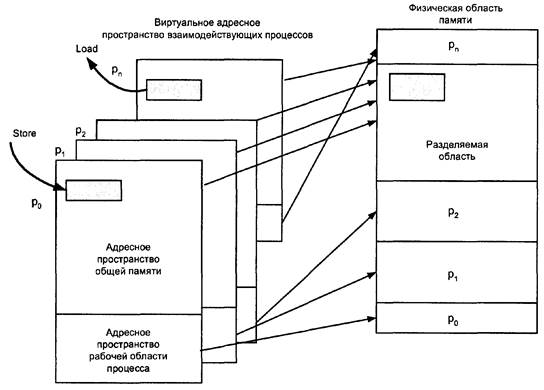

Основа программной модели для таких архитектур, по существу, есть разделение времени доступа к общей области памяти. В процессах часть их адресного пространства является разделяемой с другими процессами. Каждый процесс имеет виртуальную область памяти, состоящую из адресного пространства разделяемой памяти и собственного адресного пространства. На рис.9.1 представлена типовая модель взаимодействия процессоров через механизм разделяемой общей памяти. На рисунке показана связь виртуального адресного пространства процессов (p0 —pn) состоящего из разделяемой и собственной областей, с физической областью памяти.

Рис. 9.1. Взаимодействие процессов в модели разделяемой общей памяти

Операции записи и чтения в разделяемую область памяти требуют дополнительного контроля, т. е. операционная среда выполняет специальные функции синхронизации процессов (операций записи и чтения в разделяемую область памяти). Например, должна быть блокирована операция чтения данных одного процесса до тех пор, пока в данную ячейку не будет записан результат процесса-предшественника.

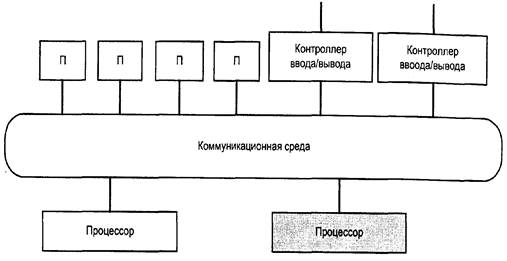

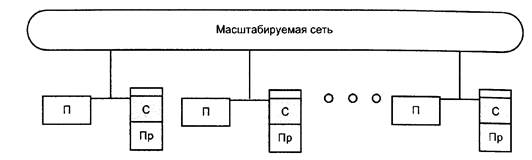

Коммуникационное оборудование систем с общей памятью позволяет расширять системную память естественным образом. По существу, большинство компьютерных систем позволяют процессору и ряду контроллеров ввода/вывода обеспечивать доступ к набору модулей памяти через некоторую коммуникационную среду, как показано на рис. 9.2.

Большинство вычислительных систем содержат один или более модулей памяти (П), доступной процессору, и контроллеры ввода/вывода через аппаратную коммуникационную среду.

Наращивание мощности системы достигается простым добавлением процессоров, модулей памяти и числа контроллеров ввода/вывода (которые также являются разделяемыми) в зависимости от требований к системе. На рис. 9.2. дополнительный процессор выделен тонировкой. При этом реальный рост производительности всей системы существенно зависит от специфики системной организации конкретного компьютера, так как рост числа процессоров и процессов приводит постепенно к несбалансированности между частотой обращений к разделяемой памяти и выполнением собственно программ. Это определяется тем, что на практике не удается реализовать идеальную — Раrаllеl Random Access Machine (РRАМ), когда любой процессор может осуществить доступ к любой ячейке памяти в любой момент времени. Для реализации данного принципа обычно используют иерархическую организацию разделяемой памяти, т. е. уменьшают количество обращений за счет, например, использования кэш-памяти (С).

Рис. 9.2. Расширение системы с общей памятью

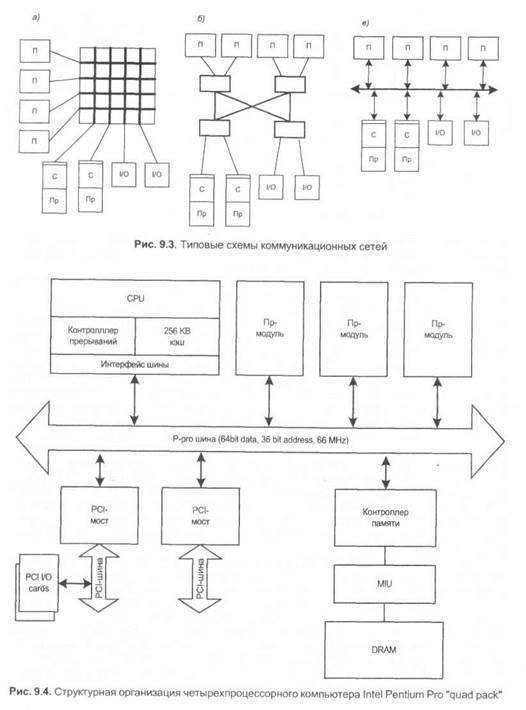

Можно выделить несколько основных типов коммуникационных сетей, используемых в архитектурах разделяемой общей памяти.

Для удовлетворения требований по загрузке системы она может иметь несколько каналов ввода/вывода, которые обеспечивают прямой доступ к каждому модулю памяти. Такого типа системы имеют организацию перекрестного соединения процессоров (Пр), нескольких каналов ввода/вывода (I/O) и нескольких модулей памяти (П) показанной на рис.9.3, а. Размерность рассматриваемой структуры определяется числом входов/выходов аппаратного коммутатора. В ранних системах размер и стоимость рассматриваемой коммуникационной среды ограничивались малым числом процессоров. В дальнейшем рост числа процессорных элементов определялся ростом удельного веса аппаратной части с одновременным снижением ее стоимости. Цена размеров перекрестного соединения становится лимитирующим фактором, и в большинстве случаев это приводит к появлению многоуровневой иерархической структуры коммуникационной среды, показанной на рис. 9.3, б. В этом случае цена растет медленнее, чем число портов. Понятно, что экономия приводит к увеличению времени ожидания соединения (latency) и уменьшению полосы пропускания на порт. Способность доступа ко всей памяти прямо из каждого процессора имеет несколько преимуществ: любой процессор может запустить любые процессы или обратиться к любому событию ввода/вывода, а структуры данных могут быть разделены внутри операционной системы.

Широкое применение систем с разделяемой общей памятью связано с появлением 32-битных микропроцессоров в середине 1980 г., кэш-память, плавающая запятая, и управление блоком памяти было реализовано на одной-двух платах (Bell, 1985). Большинство машин среднего уровня, включающих миникомпьютеры, серверы, рабочие станции и персональные компьютеры, имеют шинную организацию, и эта шина может быть адаптирована для поддержки многопроцессорных систем. Стандартный механизм доступа к шине позволяет любому процессору достичь любого физического адреса в системе. Как и в случае перекрестного соединения, вся память равноудалена от процессоров, поэтому все процессоры имеют одинаковое время доступа к памяти.

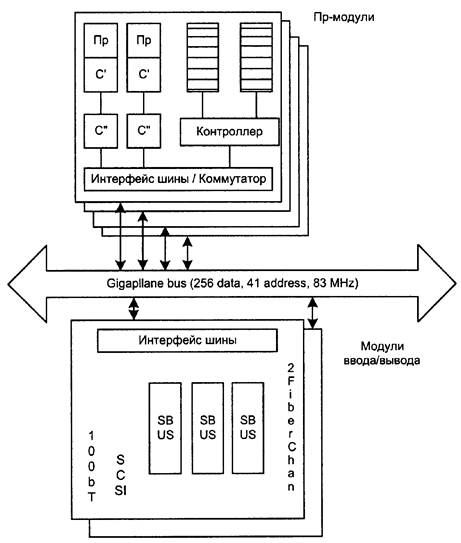

Такая конфигурация обычно называется symmetric multiprocessor (SMP). SMP идеально подходит как для параллельных программ, так и для мультипрограммирования. Типичным примером организации многопроцессорной системы с симметричным доступом к памяти основанной на шинной архитектуре, является компьютер Intel Pentium Pro four-processor "quad pack", иллюстрирующий первый SMP для широкого рынка (рис. 9.4).

Материнская плата Intel quad-processor Pentium Pro использовалась во многих многопроцессорных серверах, таких как НР NetServer Lx series, являясь главным элементом дизайна для систем с малым числом процессоров. На ней можно было объединить до четырех процессорных модулей (Пр-модуль) содержащих Pentium Pro (166 MHz) процессор (CPU), кэш-память, контроллер прерываний, интерфейс шины. Такой модуль был реализован на одном кристалле, имеющем разъемы для прямого включения в 64-битную шину памяти. 66 MHz-шина имела пиковую пропускную способность 528 Мб/с. Двухкристальный контроллер памяти и четырехкристальный контроллер мультиплексного канала обеспечивает взаимодействие шины с модулями памяти (DRAM). Шина памяти через PCI-мосты сопрягалась с двумя независимыми шинами стандарта PCI, которые обеспечивали связь с монитором, сетью и устройствами ввода/вывода (I/О). Структура Pentium Pro"quad pack" была похожа на большинство ранних машин класса SMP, но ее реализация отличалась наибольшей степенью интеграции.

На рис. 9.5 показана структура сервера Sun Enterprise Server, который также поддерживает симметричный доступ к памяти (SMP), несмотря на то, что она физически распределена между процессорными платами.

В отличие от Pentium Pro"quad pack", многопроцессорный сервер Sun UltraSparcbased Enterprise является представителем систем большей размерности по числу процессоров. Широкая (256 бит), высоко поплайнизированная шина памяти имеет пропускную способность 2,5 Гб/с. Сервер имеет иерархическую структуру, где каждая плата реализует структурную единицу системы, либо вычислительный модуль (Пр-модуль) из двух процессоров и памяти, либо модуль ввода/вывода. Наличие двух типов модулей является обязательным условием работоспособности системы. Вы- числительный модуль содержит два процессора UltraSparc каждый их которых имеет двухуровневую кэш-память [первый уровень (С’) — 16 Кб, второй уровень (С”) —512 Кб], плюс два 512-bit-wide банка памяти и внутренний коммутатор. Модуль ввода/вывода поддерживает три SBUS слота для расширения функции ввода/вывода, SCSI разъем, 100bT Ethernet-порт и два конектора для подключения оптических каналов. Стандартная конфигурация сервера включает в себя 24 процессорных и 6 модулей ввода/вывода. Хотя банки памяти являются физически разнесенными попарно между процессорными модулями, вся память равноудалена от процессоров и доступна им через общую шину, что соответствует требованиям SMP. Данные могут быть размещены в любом месте без влияния на производительность системы.

Факторы, ограничивающие число процессоров в системе, различны для рассмотренного случая и для архитектуры с сетью из коммутаторов (см. рис.9.3, а, б). Дополнение процессоров в коммутатор дорого, однако общая производительность системы возрастает с числом портов. Цена добавления процессоров к шине — мала, но производительность всей системы остается фиксированной. В последнем случае ограничителем является пропускная способность шины. Если цена доступа к памяти станет слишком большой, процессоры будут тратить большую часть времени на режим ожидания и преимущество большого числа процессоров будет снивелировано.

Один из естественных подходов построения масштабируемых машин с разделяемой общей памятью, поддерживающих симметричный доступ к памяти, показан на рис. 9.2. Он обеспечивает масштабируемость коммуникационной среды между процессорами и модулями памяти. Основной недостаток заключается в том, что при каждом обращении к памяти затрачивается много времени на ожидание кругового путешествия по сети, по этому каждый процессор должен обеспечить высокую пропускную способность.

Рис. 9.5. Структура Sun Enterprise Server

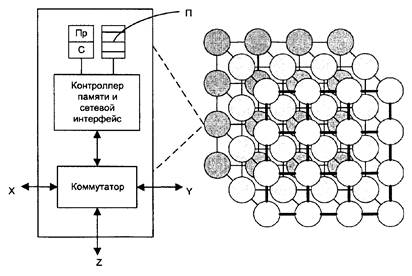

Альтернативный подход создания масштабируемой среды взаимодействия процессоров показан на рис. 9.6.

Процессор и модули памяти интегрированы между собой таким образом, что доступ к локальной памяти осуществляется существенно быстрее, чем к удаленной. Такая организация взаимодействия процессоров носит название несимметричного доступа к памяти(NUMA), при котором контроллер локальной памяти определяет, выполнять ли доступ к локальной памяти или осуществлять транзакцию сообщения к удаленной памяти (при этом системы ввода/вывода могут быть либо частью каждого модуля, либо консолидироваться в специальный модуль I/O). В таком случае доступ к собственным данным процессора часто может быть выполнен локально, как и доступ к разделяемым данным, если они сохранены в локальном модуле. Доступ к локальной памяти быстрый и не возрастает во времени по сравнению с удаленным доступом. Среднее время доступа существенно уменьшается, если большую часть занимают обращения к локальной памяти. Требования к пропускной способности сети тоже уменьшаются.

Рис. 9.6. Многопроцессорная система с несимметричным доступом к разделяемой памяти

Несмотря на некую привлекательность концептуальной простоты SMP-архитектуры, подход NUMA стал куда более приемлемым для больших многопроцессорных систем благодаря его неотъемлемым преимуществам, приводящим к росту производительности таких систем.

Примером такого стиля проектирования является CRAY T3E, показанный на рис. 9.7. CRAY T3E может содержать до тысяч процессоров, работающих с глобальным общим адресным пространством. Каждый модуль (node) содержит DEC Alpha-процессор (Пр), локальную память (П), интегрированный с контроллером памяти сетевой интерфейс и сетевой коммутатор. Компьютер организован как трехмерный куб, в котором каждый модуль соединяется с его соседями через 650 Мб/с линки. Любой процессор может иметь доступ к любой памяти, однако идеология NUMA реализована в коммуникационной архитектуре как наилучшая для характеристик производительности системы. Контроллер памяти модуля захватывает доступ к удаленной памяти и руководит транзакцией сообщения в контроллере памяти удаленного модуля от имени локального процессора. Транзакция сообщения автоматически маршрутизируется через промежуточные модули (вершины) до места назначения, с малыми задержками на каждом переходе.

Рис. 9.7. Структура суперкомпьютера СRAY ТЗЕ

Данные удаленной памяти не кэшируются, поскольку нет аппаратного механизма их сохранения. Система ввода/вывода CRAY T3E распределена между совокупностями вершин, располагающихся на поверхности куба, которые соединяются с внешним миром через дополнительную сеть.

В этой машине реализована структура, при которой, хотя вся память и доступна любому процессору, распределение данных между процессорами отдано программисту. Кэш память (С) используется только для хранения данных (инструкций) из локальной памяти. Таким образом, задача программиста — избежать частых обращений к удаленной памяти.

В заключение надо отметить, что операции взаимодействия и синхронизации в моделях программирования с разделяемой общей адресной областью, специфицируются операциями READS и WRITES разделяемых переменных. Эти операции прямо отображаются в коммуникационные абстракции, содержащие LOAD и STORE (инструкции доступа к глобальной разделяемой общей памяти), которые прямо поддержаны аппаратно через доступ к разделяемым зонам физической памяти. Программная модель и коммуникационные абстракции имеют прямую аппаратную реализацию. Для каждого процесса обращение к памяти есть адрес в его виртуальном адресном пространстве. Адрес транслируется в процесс идентификации физической области, которая может быть локальной или удаленной по отношению к процессору и которая может быть доступна другим процессорам. Трансляция адреса реализуется защищенно, в пределах разделяемого адресного пространства, как это делается в однопроцессорных системах.

Эффективность систем с разделяемой общей памятью зависит от времени ожидания доступа к памяти, связанного с пропускной способностью среды передачи данных. Для того чтобы достичь масштабируемости таких систем, все решения, включая все механизмы связи, используемые для доступа к разделяемой памяти, должны быть правильно сбалансированы.