Визуальное интерактивное дешифрирование 2 страница

Чтобы более точно выполнить классификацию с обучением в двухэтапной схеме классификации, можно воспользоваться еще одним инструментом ERDAS Imagine - «тематическим» признаковым пространством.

- необходимо создать проективные плоскости признакового пространства для того подмножества каналов, на котором проводили неконтролируемую классификацию.

-Все ПП-проекции теперь не обязательно открывать в вьюерах. Если в изображении-подмножестве каналам 1,2,3 соответствуют каналы 2,3,4 исходного изображения, открыть только ПП-проекцию для каналов 2,3 трехканального изображения (красный и ближний ИК), как наиболее информативную.

-вызвать из блока Classifierфункцию Feature Space Thematic.В окне этой функции задать:

1) имя растрового результата тематической классификации (Thematic Input File);

2) в окне Feature Space File- имя используемой ПП-проекции (в рассматриваемом случае каналы 2,3 изображения-подмножества);

3) в окне Output Root Nameпервые 2-3 буквы, которые будут идентифицировать результат тематической классификации.

-Последовательно задать остальные ПП-проекции в окне FeatureSpace File

-получить тематические ПП-файлы по всем парам каналов.

-Все формируемые файлы после ввода данных будут показаны в нижней таблице окна.

-Открыть созданную тематическую ПП-проекцию для наиболее информативной пары каналов в новом вьюере.

-Открыть в том же вьюере исходный ПП-файл, который задавали в окне 2 функции Feature Space

-Активным слоем считается верхний слой. Поэтому для получения статистик по AOI-объектам ПП-вьюеров необходимо, чтобы тематическое ПП-изображение находилось под основным.

-Открыть в редакторе сигнатур файл сигнатур, полученный в результате неконтролируемой классификации.

-Выполнить соединение ПП – вьюеров

-переключая слои можно увидеть не только положение точки в ГТГТ, но и ее относительное положение в соответствующем классе.

-Чтобы увидеть положение центров кластеров, выделить все сигнатуры и присвоить им черный цвет.

-фу-я Feature >Objects. В окне функции установите номер ПП-вьюера, отключить пока Plot Ellipse и отметьте галочкой Plot Means

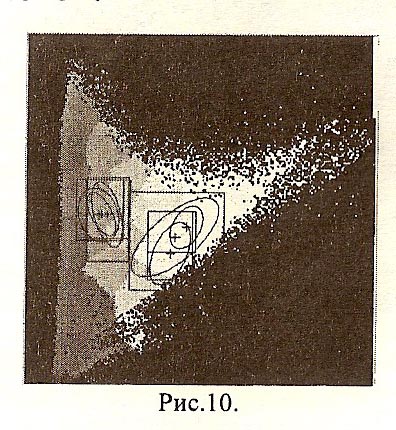

-Центры кластеров будут показаны в ПП-вьюере черными крестиками (рис.9). Опции Plot Ellipse и Plot Rectangle покажут эллипсоиды рассеяния точек в кластерах и границы значений сигнатур кластеров по каналам.

Выводы:

-Положение центра показывает, в какой части кластера сосредоточено максимальное количество точек=>поможет определить, какие объекты на изображении являются типичными представителями классов, выделенных в результате неконтролируемой классификации.

-Для этих объектов подавляющая часть точек должна также быть сосредоточена вблизицентра кластера. Если такие объекты есть, можете смело формировать по ним обучающие выборки (сигнатуры). Это будут надежно выделяющиеся по спектральным признакам классы.

Если объекты одного типа включают в себя несколько классов, но ср знаяения приходятся на оин и тот же кластер:

-можно оставить сигнатуру центрального класса в качестве типичной. Возможно, что при повторной классификации другим методом с помощью этой сигнатуры результат окажется более точным.

Важные плюсы: во многих случаях сигнатуры кластеров оказываются более однородными, чем сигнатуры любых тестовых участков, выбранных непосредственно на изображении. Это, собственно, и является основным доводом в пользу двухэтапной схемы классификации. Большой разброс точек в сигнатурах, полученных в результате обучения по изображению, приводит к увеличению ошибок классификации.

10. Классификация с обучением, обоснование ее применения. Принципы выбора обучающих данных с учетом изменчивости яр костных признаков классов на изображении. Методы получения обучающих выборок (сигнатур классов) в пакете ERDAS Imagine.

Задача классификации заключается в разбиении признакового пространства на области, соответствующие различным тематическим категориям (классам) объектов земной поверхности.

Распознавание с обучением (контролируемая классификация) применяется в тех случаях, когдаинформации слишком много для того, чтобы точно определить, сколько всего классов можно выделить на анализируемом объеме данных. Поэтому мы выбираем только те классы, которые представляют интерес для решения задачи, и определяем их типичные характеристики с помощью процедур обучения.

Выбирать обучающие данные можно двумя способами. Можно выделять интересующие нас объекты или их участки (участок воды, леса, застройки и пр.) непосредственно на изображении или в пространстве признаков. Перед тем, как это делать, нужно связать изображение с пространством признаков в Эрдасе.

При выборе на изображении, откройте в окне изображения инструментарий для рисования областей интереса AOI > Tools. С помощью инструмента & оконтурите небольшой объект на изображении. Добавьте в редактор сигнатур сигнатуру выбранного объекта с помощью кнопки +и . Присвойте сигнатуре какой-либо яркий цвет, например, белый. Выберите в редакторе сигнатур функцию Feature > Masking > Image to Feature Space. В окне этой функции установите номер ПП-вьюера, в котором Вы хотите отобразить сигнатуру, и нажмите Apply. Значения пикселей выбранного объекта отобразятся в ПП-вьюере цветом, присвоенным Вами его сигнатуре. В результате может получиться так, что выделится не какая-то единая область, а очень много разрозненных участочков. Т.е.сигнатуры объектов, которые визуально кажутся однородными, могут иметь значительный разброс по яркости. Этот факт - одна из причин ошибок, возникающих при классификации с обучением по тестовым участкам.

Создание сигнатур классов в ПП. По-настоящему однородные по яркости сигнатуры можно получить, выбирая области непосредственно в признаковом пространстве. Для этой цели выберите одно из наиболее информативных сочетаний каналов, например, 3 и 4, и откройте в соответствующем ПП-вьюере AOI-инструментарий командой меню AOI > Tools. Определите, перемещая перекрестье на изображении, примерное положение нескольких тематических классов в выбранных ПП-вьюерах и нарисуйте с помощью инструментов AOI соответствующие им многоугольники или эллипсы. Особенно рекомендуется обратить внимание на яркие пятна, соответствующие классам воды. Более точно выделить эти классы, обучаясь непосредственно по изображению, едва ли удастся каким-либо другим способом. Не выбирайте слишком маленькие участки в сине-фиолетовой зоне, и слишком большие - в красно-оранжевой.

Выделите нужную область в ПП-вьюере и добавьте ее сигнатуру в редактор сигнатур. После этого выберите в редакторе функцию меню Feature > Statisticsдля подсчета статистических характеристик сигнатуры.

Чтобы посмотреть, куда попадает сформированная сигнатура на изображении, установите для нее яркий цвет и выберите в меню редактора сигнатур функцию Feature > Masking > Feature Space to Image. Нажмите Apply.Пиксели, которые попадают по всем значениям внутрь выбранной Вами области в ПП-вьюере, будут подсвечены на изображении ее цветом.

Сигнатуры можно строить в любом из присоединенных к изображению ПП-вьюеров, выбирая тот, в котором Вашему классу соответствует более компактная, отличная от других область(в котором более широкая диаграмма рассеяния).

Чтоб посмотреть, какие пиксели попадают в диапазон значений данной сигнатуры по каналам (гиперпараллелепипед), выберите в меню редактора сигнатур функцию View > Image Alarm.В открывшемся окошке нажмите ОК. Пиксели, которые попадают в пределы разброса значений Вашей сигнатуры по каналам, будут подсвечены на изображении ее цветом.

Точки, находящиеся внутри заданного эллипсоида рассеяния, можно получить, нажав в окне Image Alarmкнопку Edit Parallelepiped Limits.В этом окне нажмите Set,укажите в еще одном открывшемся окне радиокнопку Std. deviationи установите нужное значение ст.

11. Методы оценки качества эталонных сигнатур классов в пакете ERDAS Imagine. Средства отображения сигнатур классов в пространстве признаков.

В редакторе сигнатур можно выполнить предварительную оценку качества контролируемой классификации по сформированным сигнатурам классов. Для таких целей используются функциональные характеристики взаимного положения классов, связанные с ожидаемой ошибкой классификации. Чем больше значение используемого критерия разделимости, тем меньше должны быть ошибки при разделении оцениваемых классов, В пакете ERDAS Imagine предлагается четыре вида оценок: евклидово расстояние, дивергенция (прямая и трансформированная) и расстояние Джеффриса-Матуситы.

Евклидово расстояние между средними значениями по классам удобно использовать в тех случаях, когда классы достаточно однородны по яркости, то есть образуют небольшие компактные области в пространстве признаков. Чем больше расстояние между средними по классам, тем меньше вероятность ошибки. Такая оценка, как и метод классификации по минимуму расстояния, в этом случае оказывается эффективной.

В таких мерах разделимости, как дивергенция и расстояние Джсффриса-Матуситы, учитываются отношения между вероятностями появления признака в каждом из классов, поэтому их обыкновенно используют при классификации статистическими методами (по расстоянию Махаланобиса или максимуму правдоподобия). Чем выше значения этих величин, тем меньше будет ожидаемая величина ошибки. Дивергенцию (трансформированную дивергенцию) удобнее использовать в тех случаях, когда сигнатуры классов распределены в признаковом пространстве более или менее равномерно, расстояние Джеффриса-Матуситы пригодно практически для любых ситуаций, однако оценивает соотношения между вероятностями по классам более грубо.

Данные оценки особенно полезны в тех случаях, когда обучение выполняется по выделенным на изображении тестовым участкам. Именно потому, что такие сигнатуры часто имеют большую диаграмму рассеяния и могут сильно перекрываться в пространстве признаков,

Чтобы выполнить оценку разделимости для Ваших сигнатур, выделите оцениваемую группу классов и выберите в редакторе сигнатур функцию Evaluate > Separability. Установите радиокнопку на выбранный Вами критерий оценки. Вы получите протокол, в котором будут указаны средние и минимальные значения по группе и отдельно по парам классов. Для выбранного критерия выполняется как усредненная оценка разделимости, так и минимальная (наихудшая).

Для оценки ошибок первого и второго рода по тестовым участкам изображения при использовании конкретного классификатора (решающего правила) используется фунция Evaluate > Contingency. На выходе выдается протокол, в котором показывается сколько точек из класса К[ попало в класс к2 для всей совокупности классов.

На основании этих оценок Вы можете как оценить качество обучающих данных, так и подобрать наиболее подходящий метод классификации.

12. Параметрические и непараметрические методы классификации с обучением в ERDAS Imagine. Метод гиперпараллелепипедов и классификация по сигнатурам, выбранным в пространстве признаков. Классификация по минимуму расстояния. Способы классификации точек, попавших за границы класса или в область перекрытия нескольких классов.

Задача классификации заключается в разбиении признакового пространства на области, соответствующие различным тематическим категориям (классам) объектов земной поверхности.

Распознавание с обучением (контролируемая классификация) применяется в тех случаях, когдаинформации слишком много для того, чтобы точно определить, сколько всего классов можно выделить на анализируемом объеме данных. Поэтому мы выбираем только те классы, которые представляют интерес для решения задачи, и определяем их типичные характеристики с помощью процедур обучения.

Откройте функцию Supervised Classificationблока Classifier. В нижней части окна устанавливается метод классификации - непараметрическое правило (Non-parametric Rule)и параметрическое правило (Parametric Rule).При классификации по непараметрическому правилу к одному классу будут относиться все точки, попавшие либо внутрь гиперпараллелепипеда (режим Parallelepiped в Non-parametric Rule),либо в область, выделенную в ПП-вьюере (режим Feature Spaceв Non-parametric Rule).

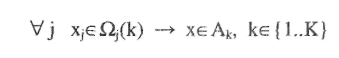

Метод гиперпараллелепипеда Значения признаков для образов различных классов могут совпадать или перекрываться по одним координатам и различаться по другим. Если выбрать такой набор признаков, чтобы образы разных классов различались хотя бы по одной координате, мы можем задать простое правило классификации:

(5.1)

(5.1)

где Ω j (к) - интервал значений признака xj, для класса Ак. Геометрическая интерпретация этого случая при п=2, К=3 показана на рис. 5.1.

На рис. 5.1 Ω1(l)=Ω1(2)+Ω1(3), но класс A1 разделяется попарно с классами А2 и А3 по признаку х2. В то же время Ω2(2)=Ω2(3), но эти классы разделяются по признаку х1

Рис.5 Л. Простой случай разделения классов (гиперпараллелепипеды).

Классификация по сигнатурам выбранным в ПП – см. вопр.10. Если коротко – строим ПП для наиболее информативной пары каналов, связываем это ПП с изображением. Перемещая перекрестье приблизительно находим какая область в ПП каким объектам соответств. И после этого вручную отрисовываем области в ПП, т. е. сами создаем сигнатуры классов.

В классификации по минимуму расстояния {режим Minimum Distance в Parametric Rule) в качестве критерия классификации используется евклидово расстояние классифицируемой точки в ПП до центров кластеров. Это простейшее из параметрических правил. В этом случае граница между парой классов - это серединный перпендикуляр к прямой, соединяющей их центры.

Два другие режима используют и среднее, и матрицу ковариаций. В обоих случаях предполагается, что значения признаков по классам распределены по нормальному (Гауссову) закону. Плотность многомерного нормального распределения имеет вид

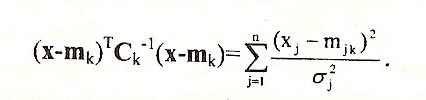

В случае, когда все ПП статистически независимы, матрица Ск диагональна и расстояние Махаланобиса приобретает достаточно простой вид:

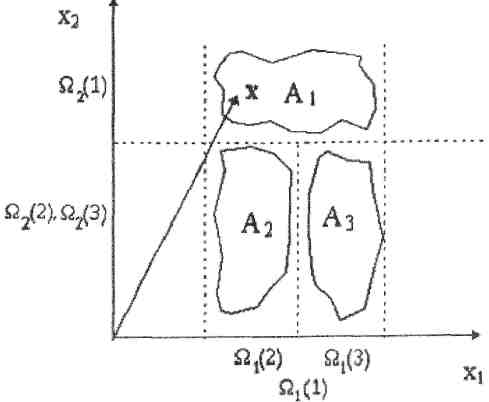

В этом случае оси гиперэллипсоида будут параллельны осям координат признакового пространства. Статистическая независимость признаков, то есть координат многомерного вектора, для всей совокупности выделяемых классов далеко не всегда имеет место. Это хорошо видно на рис.10, где вообще нет ни одного эллипса, оси которого расположены горизонтально и вертикально. В такой ситуации как раз и удобно использовать расстояние Махаланобиса. Точка будет относиться к тому классу, для которого она, грубо говоря, окажется внутри гиперэллипсоида рассеяния меньшего размера.Классификация по расстоянию Махаланобиса более эффективна в случае различной корреляции признаков внутри классов. Если внутригрупповая корреляция приблизительно одинакова для всех выделяемых классов (эллипсоиды вытянуты в одном направлении), можно пользоваться классификацией по евклидову расстоянию. Эта ситуация встречается на изображениях, где представлены преимущественно объекты одной категории, например растительность или почвы.

Классификация по максимуму правдоподобия (режим Maksimum Likelihood в Parametric Rule) иначе называют байесовским решающим правилом. В этом подходе используется вероятность появления каждого класса Ωkдля точки с заданным набором значений признака xi, которая определяется по формуле:

p(Ωk/ xi)=(P(Ωk) p(xi /Ωk))/ (∑P(Ωj) p(xi /Ωj))

Выбирается тот класс, для которого эта вероятность максимальна. Кроме того здесь используется вероятность появления такого класса на данной территории р(Пк) - априорная вероятность класса.Она определенным образом масштабирует вероятность появления точки в классе относительно таких же вероятностей для других классов, что приводит к смещению разделяющих границ. Однако на практике этим пользуются редко. Чаще априорные вероятности считают одинаковыми (так называемая нуль-единичная байесовская стратегия).

При использовании гипотезы о нормальном распределении значений признаков метод максимума правдоподобия отличается от классификации по расстоянию Махаланобиса только наличием априорных вероятностей появления классов в соответствии с формулой Байеса.

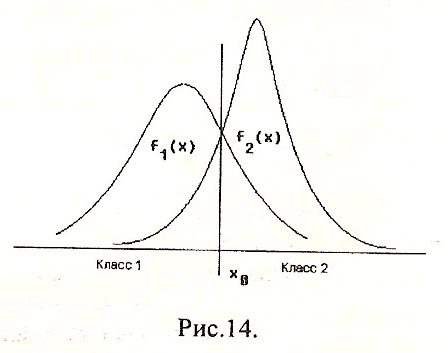

В случае, если признак х распределен в классе 1 и в классе 2 по нормальному закону, области решения в пользу каждого из классов определены разделяющей точкой х0. Слева от х0 решение принимается в пользу класса 1, справа - в пользу класса 2.

При использовании метода гиперпараллелепипеда нужно решить, куда и как относить те точки, которые не попадают ни в какой гиперпараллелепипед.

В окне функции Supervised Classification для этого случая нужно задать режим Unclassified Rule. Как Вы уже, вероятно, поняли, важное различие между непараметрическими и параметрическими правилами состоит в том, что если в первом случае область принятия решения в пользу каждого класса строго ограничена, то во втором она ограничена только разделяющими функциями dki(x) для каждой пары классов Ак и Аi То есть все точки будут, так или иначе, расклассифицированы, независимо от того, попадают они или нет в гиперпараллелепипед или эллипсоид рассеяния какого-то класса.

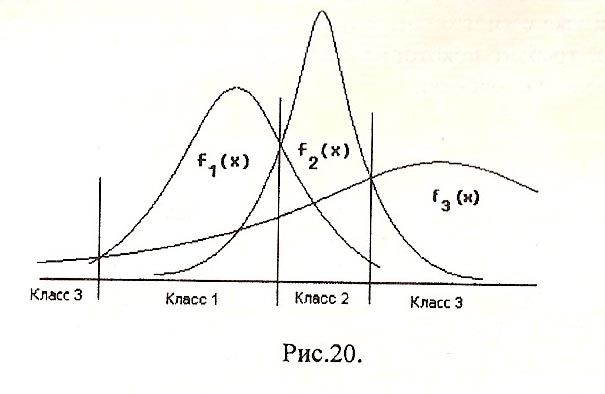

При использовании метода максимума правдоподобия существует опасность, что все точки, находящиеся на краях диаграммы рассеяния в пространстве признаков, попадут в класс с наибольшей дисперсией, хотя могут не иметь к нему никакого отношения, Такая ситуация для одномерного случая показана на рис. 20. Вряд ли ТОЧКИ В левом полуинтервале будут на самом деле относиться к классу 3, если и качестве признаков используются спектральные отражательные свойства объектов земной поверхности. На практике ЭТО иногда приводит к результатам, на первый взгляд, парадоксальным: очень сухие ПОЧВЫ и яркие искусственные объекты смешиваются с мутной водой. По если вспомнить, где расположены эти классы в пространстве спектральных признаков, ЭТОТ эффект объясняется довольно просто.

13.

На случай, если гиперпараллелепипеды классов все-таки где-то перекрываются, необходимо задать правило принятия решения при перекрытии (Overlap Rule). Для этого случая расстояние Махаланобиса, как и максимум правдоподобия, практически всегда оказываются эффективными. Для максимума правдоподобия можно также задать априорные вероятности (поле Ргоь. в редакторе сигнатур), чтобы нужным образом сдвинуть границы между классами. При классификации в этом случае нужно указать режим Use Probabilities.

В качестве правила классификации при перекрытии можно также задать свои собственные приоритеты классов (поле Order в редакторе сигнатур). В этом случае при перекрытии гиперпараллелепипедов (или, соответственно, областей в признаковом пространстве для непараметрического правила Feature Space) пиксель будет относится к тому классу, приоритет которого выше. Например, при перекрытии классов 2 и 5 точка будет отнесена к классу 2.

13. Статистическая классификация. Обоснование метода на примере двух классов и одного признака. Ошибки первого и второго рода. Определение границ классов через минимум среднего байесовского риска.

Часто встречаются ситуации, когда один и тот же образ может принадлежать сразу нескольким классам, но частота появления образа с конкретным значением для различных классов не одинакова и определить оптимальную границу между классами можно только с учетом этого факта. При обработке изображений относительную частоту появления образа в классе можно оценить, построив гистограмму по объектам, принадлежащим заданному классу. При большом количестве образов в k-м классе эта частота стремится к вероятности Pk(x) появления образа х в данном классе, и гистограмму можно рассматривать как дискретную аппроксимацию функции плотности распределения fk(x).

Принцип максимума правдоподобия. Эти алгоритмы основаны на статистическом подходе к задаче распознавания и представляют собой классификаторы с обучением. То есть предполагается, что

1) заданы определенные классы и по ним имеются данные предварительных исследований (тестовые участки при обработке данных ДЗ);

2) эти данные позволяют получить представительные выборки образов по всем классам и оценить вероятность появления образа в каждом классе для всего множества X.

Рассмотрим правила принятия решений в задаче статистической классификации на примере двух классов и одного признака, заданного действительным значением измерения X. Задача заключается в определении на шкале X интервалов Ω1 и Ω2, на которых будут приниматься решения в пользу первого и второго класса соответственно. Для простоты в дальнейшем классы и соответствующие им области принятия решения будем обозначать одним и тем же символом Ω.

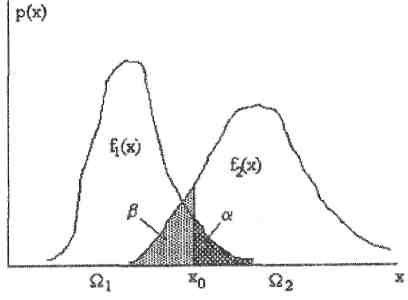

Предположим, что получена вся необходимая статистическая информация о классах: функции плотности статистического распределения f1(x) и f2(x) (рис.8.1), а так же априорные вероятности P(Ω1) и Р(Ω2) появления данных классов. Для задачи обработки данных ДЗ априорные вероятности - это ожидаемые доли площади под каждым классом, которые могут быть получены, например, из фондовых материалов.

Пусть мы выбрали некоторую точку х0, разделяющую всю шкалу значений признака х на два интервала: (-∞,х0] соответствует области решений в пользу класса Ω1, (хо,∞) - области решений в пользу класса Ω2. В теории статистических решений непротиворечивое множество предположений о свойствах случайной величины ξ, называется статистической гипотезой. В данном случае мы рассматриваем две статистические гипотезы: ξ, принимающая значения х, имеет распределение с плотностью f1(x), то есть принадлежит классу Ω1 - это гипотеза H1 против альтернативы Н2: ξ имеет распределение с плотностью f2(x), то есть принадлежит классу Ωг.

Рис.8.1. Статистическая гипотеза для случая двух классов.

Вероятность появления любого значения х отлична от нуля и для первого, и для второго класса на всем множестве X, поэтому при принятии решения относительно принадлежности некоторого значения х к одному из классов могут возникнуть 4 ситуации.

1. Принимаем гипотезу Н1 и она верна.

2. Принимаем Н2, но верна H1 .

3. Принимаем Н2, и она верна.

4. Принимаем Н1 но верна Н2.

Вероятность возникновения ситуации 1 соответствует площади под f1(x) на полуинтервале (-∞,х0], ситуации 2 - площади под f1(x) на интервале (хо,∞), ситуации 3 - площади под f2(x) на (хо,∞), ситуации 4 - площади под f2(x) на (-∞,Хо]- Суммарная площадь под f1(x) и f2(x) для ситуаций 2 и 4- это полная вероятность ошибокв нашей схеме принятия решений. В случае двух альтернативных гипотез ошибку, соответствующую ситуации 2, обычно называют ошибкой первого рода(а), ошибку, соответствующую ситуации 4, - ошибкой второго рода(|3). Вообще говоря, понятие ошибок первого и второго рода симметрично и зависит от того, какая гипотеза является основной, а какая - альтернативной. Если бы H2 была основной гипотезой, ошибка первого рода соответствовала бы ситуации 4.

При классификации пикселов многозональных аэрокосмических изображений ошибка первого рода проявляется в появлении на объектах класса Ω1 точек посторонних классов. В свою очередь, ошибки второго рода проявляются в появлении точек этого класса на других объектах. Когда количество классов невелико, обычно преобладают ошибки второго рода. Это связано с тем, что аналитик не учитывает все присутствующие на изображении типы объектов, в том числе и с характеристиками, близкими к выделяемым классам. Это одна из причин, по которой полезно выполнение предварительной неконтролируемой классификации, причем на значительно большее, чем требуется, количество классов. Неконтролируемая классификация позволяет предварительно оценить величину ошибок второго рода, более точно определить границы искомых классов и, при необходимости, разумно задать класс отказов от распознавания.

Про Баеса см. зел. методичку стр.52 Там матрица и интегралы.

14. Статистическая классификация в случае произвольного числа классов. Формула Байеса, функция правдоподобия и апостериорная вероятность. Принцип максимума правдоподобия, его реализация в пакете ERDAS Imagine. Матрица ошибок.

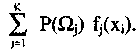

Пусть теперь задано К классов Ω1...,ΩK с функциями плотности распределения признака х f1(x),...,fK(x) и априорными вероятностями P(Ω1),...,P(Ωk). К примеру, мы хотим разбить на К классов точки серого полутонового изображения по значениям яркости х. Гистограмма такого изображения, нормированная к общему количеству точек S0, представляет собой дискретную аппроксимацию плотности р(х) совместного распределения точек К классов. Рассмотрим, что представляет из себя значение р(х) в отдельно взятой точке X;.

Как мы уже отметили при записи среднего байесовского риска, вероятность появления точки со значением Xj в k-м классе есть произведение вероятностей P(Ωk) fk(Ωj), или, иначе, Р(Ωк)р(хΩк). Плотность совместного распределения в точке хi - полная вероятность появления значения xi - есть

Общую долю k-го класса в этой сумме, то есть вероятность

Общую долю k-го класса в этой сумме, то есть вероятность

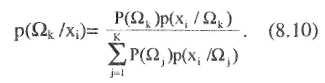

того, что точка со значением Xi принадлежит именно k-му классу, тогда можно записать так

В теории вероятностей формулу (8.10) называют формулой Байеса для полной системы несовместных событий. В нашем случае такую систему образуют решения об отнесении точки со значением хi к одному из К классов.

В отличие от априорной вероятности Р(Ωк), которая характеризует ожидаемую частоту появления k-го класса по множеству образов в целом, p(Ωk/Xi) - это вероятность появления k-ro класса при конкретном значении признака х. Эту вероятность называют апостериорной вероятностью.

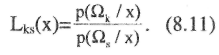

Поскольку P(Ωk)p(x/Qk)=P(Ωk)fk(x) (величину P(Ωk)p(x/Ωk) часто называют функцией правдоподобия), а знаменатели в выражении (8.10) одинаковы для всех К классов, мы можем для любой пары классов к и s записать отношение правдоподобия (8.6) через апостериорные вероятности

В соответствии с байесовской стратегией, решение принимается в пользу того класса, для которого Lks(x)>λ (Lks(х)>1 при C12==c21=l; в принципе, мы всегда можем выполнить соответствующую нормировку, чтобы это условие выполнялось. Следовательно, образ с конкретным значением признака х мы должны отнести к тому из К классов, для которого p(Ωk /x)> p(Ωs /x) или, что эквивалентно, Р(Ωк)р(х/Ωk)>Р(Ωs)р(х/Ωs)) по всем парам k,s. Отсюда и название данного подхода - принцип максимума правдоподобия.

Часто при классификации по максимуму правдоподобия априорные вероятности появления всех классов считаются одинаковыми, а платежные коэффициенты принимаются равными 0 и 1, как мы это делали ранее. Классификацию при таких условиях называют нуль-единичной байесовской стратегией. Вэтом случае мы сокращаем ошибку первого рода для маловероятных классов, что позволяет выделять их более надежно.»