Свойства функции энтропии источника дискретных сообщений

Свойства функции энтропии можно наглядно продемонстрировать на примере источника дискретных сообщений A=(a1, a2) с объемом алфавита m равного 2, т.е. m=2. В этом случае справедливо  , и выражение (1.8) может быть записано в виде:

, и выражение (1.8) может быть записано в виде:

(бит/символ).

(бит/символ).

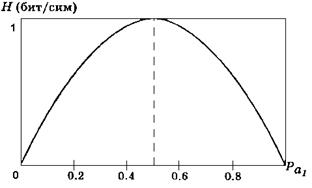

График этой функции имеет вид, представленный на рис. 1.1.

Рис.1.1. График функции энтропии.

Из графика видно, что обращение вероятности появления одного из возможных символов в 0 или 1 вносит полную определенность, энтропия обращается в 0 и сообщение о приёме такого символа не содержит в себе никакой информации.

При  получение конкретного символа наиболее неопределено и количество информации, содержащееся в поступившем символе, максимально.

получение конкретного символа наиболее неопределено и количество информации, содержащееся в поступившем символе, максимально.

Анализ формулы (1.8) и графика (Рис. 1.1) позволяет сформулировать основные свойства функции энтропии.

1 Энтропия источника дискретных сообщений есть величина вещественная, ограниченная и положительная.

2 Энтропия равна 0, если с вероятностью, равной единице, всегда выбирается один и тот же символ.

3 Энтропия максимальна, если все символы источника сообщений появляются независимо и равновероятно.

Интересно отметить, что сравнение выражений (1.5), (1.7) и (1.10) показывает, что формула Хартли является частным случаем формулы Шеннона при условии независимости и равновероятности появления символов в сообщении, а формула Шеннона, в свою очередь, является частным случаем условной энтропии при условии, что символы сообщения независимы. Действительно, из (1.10) следует, что количество информации  ,содержащееся в сообщении, состоящем из n неравновероятныхи взаимно зависимых символов определяется выражением:

,содержащееся в сообщении, состоящем из n неравновероятныхи взаимно зависимых символов определяется выражением:

.

.

Если символы сообщения взаимно независимы, то

и

и  , следовательно, это выражение преобразуется к виду:

, следовательно, это выражение преобразуется к виду:

=

=

Последнее выражение соответствует формуле Шеннона.

В случае равновероятного появления символов сообщения

, при j= 1, 2,…, m. (m – объём алфавита) и выше приведённое выражение для формулы Шеннона после соответствующего преобразования примет вид:

, при j= 1, 2,…, m. (m – объём алфавита) и выше приведённое выражение для формулы Шеннона после соответствующего преобразования примет вид:

,

,

который соответствует формуле Хартли.

Таким образом, количество информации, определяемое по Хартли, т.е. при допущении полной независимости и равной вероятности появления отдельных символов сообщения, определяет максимально возможное количество информации в сообщении заданной длины (n).

При неравной вероятности появления символов (формула Шеннона) количество информации, содержащееся в сообщении заданной длины (n), снижается. Другим фактором, снижающим энтропию, а, следовательно, и количество информации в сообщении заданной длины (n), является наличие статистической зависимости между символами – корреляции.

Из-за корреляционных связей между символами и неравновероятного их появления количество информации в реальных сообщениях падает. Количественно эти потери информации характеризуются коэффициентом избыточности (R)

(1.11)

(1.11)

где  — максимальное количество информации, которое может содержать один символ сообщения, определяемое по формуле (1.6);

— максимальное количество информации, которое может содержать один символ сообщения, определяемое по формуле (1.6);

Н — среднее количество информации, которое переносит один символ в реальных сообщениях;

m — число символов в алфавите источника сообщений (объём алфавита).

Избыточность  говорит о том, что число символов в сообщении больше, чем это требовалось бы при полном ихиспользовании, т.е. при условии, что символы появляются равновероятно и взаимно независимо.

говорит о том, что число символов в сообщении больше, чем это требовалось бы при полном ихиспользовании, т.е. при условии, что символы появляются равновероятно и взаимно независимо.

Интересно отметить, что, для европейских языков избыточность составляет не менее 0.5.