Совместное использование данных

При реализации транзакций возникает проблема: потеря обновлений (в БД фиксируется только изменения одного userа, остальные теряются). И 2 проблема – чтение незафиксированных данных. Для решения - спец механизмы обработки транзакций. Принципы: 1. транзакция не имеет доступа к незафиксированным данным. 2. результат совместного выполнения транзакций эквивалентен их последнему выполнению. Реализуется этот механизм через систему блокировок: СУБД блокирует часть БД, к которой обращается транзакция до момента её фиксации, т.е. 2-ю транзакцию надо поставить в очередь ожидания. Чем больше блокируемый элемент, тем медленнее обрабатывается транзакция. В системах OLTP обычно блокируется строка, при этом транзакции могут попадать в ситуацию взаимной блокировки. Для предотвращения СУБД периодически опрашивает блокировки и если такое есть, одна из транзакций прерывается. Для более удобной работы допускаются блокировки совместного использования данных: параллельно работающим userам запрещается изменять данные, но разрешается выборка их. Этот подход не единственный, можно, например использовать тиражирование данных в системах с распред доступом. Эта технология предполагает отказ от распределенности данных, и в каждом узле – своя копия БД. Средства, обеспечивающие это должны поддерживать согласованное состояние БД копированием изменений. Процесс переноса изменений исходной БД в БД отдельных узлов называется тиражированием данных. Эти функции выполняет определенный модуль (сервер тираж-я/ репликатор). Схема его работы – полное обновление содержимого БД на удаленных серверах (схема с полн обновлением) или обновление только изменяющихся данных (схема с быстрым обновлением) Если нет необходимости постоянно обновлять данные, то репликатор накапливает изменения и копир-т их в нужный момент.

OLTP - системы оперативной обработки транзакций, характеризуются большим количеством изменений, одновременным обращением множества пользователей к одним и тем же данным для выполнения разнообразных операций - чтения, записи, удаления или модификации данных. Для нормальной работы множества пользователей применяются блокировки и транзакции. Эффективная обработка транзакций и поддержка блокировок входят в число важнейших требований к системам оперативной обработки транзакций.

Современные технологии БД предъявляют определенные требования в области архитектуры. До недавнего времени выделялось три класса задач:

· задачи оперативной обработки транзакций;

· задачи пакетной обработки;

· задачи принятия решений.

OLTP-системы - системы оперативной обработки транзакций. Основная функция подобных систем заключается в одновременном выполнении большого количества коротких транзакций от большого числа пользователей. Сами транзакции выглядят относительно просто, например, "снять сумму денег со счета А, добавить эту сумму на счет В". Исторически такие системы возникли в первую очередь, поскольку реализовывали потребности в учете, скорости обслуживания, сборе данных и пр.

Системы OLTP характеризуются:

· поддержкой большого числа users;

· малым временем отклика на запрос;

· относительно короткими запросами;

· короткими транзакциями;

· участие в запросах небольшого числа таблиц.

Практически все запросы к базе данных в OLTP-системах состоят из команд вставки, обновления, удаления. Запросы на выборку в основном предназначены для предоставления пользователям возможности выбора из различных справочников. Большая часть запросов, таким образом, известна заранее еще на этапе проектирования системы. Таким образом, критическим для OLTP-приложений является скорость и надежность выполнения коротких операций обновления данных.

Сервер оперативной обработки транзакций строится в предположении:

· OLTP- операции поддерживают большое число user;

· наиболее часто используются короткие простые транзакции;

· обычно транзакции не использую одинаковые данные;

· операторы обычно затрагивают небольшое число строк;

· время отклика - доли секунды;

· только несколько таблиц имеют большие размеры или могут быть изменены.

Реализация такого сервера опирается на:

· физические методики сокращений операций с дисками;

· обработку небольших объемов данных в памяти;

· примитивный оптимизатор запросов;

требование к приложениям - исключить конкуренцию запросов в использовании ресурсов и данных.

11. Хранилища данных и Data Mining

Data Mining переводится как "добыча" или "раскопка данных". Нередко рядом с Data Mining встречаются слова "обнаружение знаний в базах данных" (knowledge discovery in databases) и "интеллектуальный анализ данных". Их можно считать синонимами Data Mining. Возникновение всех указанных терминов связано с новым витком в развитии средств и методов обработки данных.

До начала 90-х годов, казалось, не было особой нужды переосмысливать ситуацию в этой области. Все шло своим чередом в рамках направления, называемого прикладной статистикой (см. например, [1]). Теоретики проводили конференции и семинары, писали внушительные статьи и монографии, изобиловавшие аналитическими выкладками.

Вместе с тем, практики всегда знали, что попытки применить теоретические экзерсисы для решения реальных задач в большинстве случаев оказываются бесплодными. Но на озабоченность практиков до поры до времени можно было не обращать особого внимания — они решали главным образом свои частные проблемы обработки небольших локальных баз данных.

И вот прозвенел звонок. В связи с совершенствованием технологий записи и хранения данных на людей обрушились колоссальные потоки информационной руды в самых различных областях. Деятельность любого предприятия (коммерческого, производственного, медицинского, научного и т.д.) теперь сопровождается регистрацией и записью всех подробностей его деятельности. Что делать с этой информацией? Стало ясно, что без продуктивной переработки потоки сырых данных образуют никому не нужную свалку.

Специфика современных требований к такой переработке следующие:

· Данные имеют неограниченный объем

· Данные являются разнородными (количественными, качественными, текстовыми)

· Результаты должны быть конкретны и понятны

· Инструменты для обработки сырых данных должны быть просты в использовании

Традиционная математическая статистика, долгое время претендовавшая на роль основного инструмента анализа данных, откровенно спасовала перед лицом возникших проблем. Главная причина — концепция усреднения по выборке, приводящая к операциям над фиктивными величинами (типа средней температуры пациентов по больнице, средней высоты дома на улице, состоящей из дворцов и лачуг и т.п.). Методы математической статистики оказались полезными главным образом для проверки заранее сформулированных гипотез (verification-driven data mining) и для “грубого” разведочного анализа, составляющего основу оперативной аналитической обработки данных (online analytical processing, OLAP).

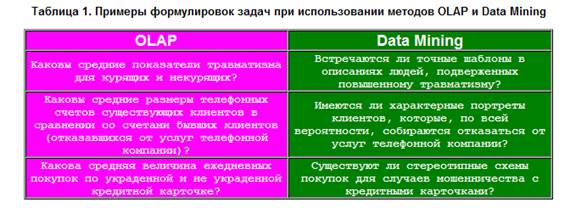

В основу современной технологии Data Mining (discovery-driven data mining) положена концепция шаблонов (паттернов), отражающих фрагменты многоаспектных взаимоотношений в данных. Эти шаблоны представляют собой закономерности, свойственные подвыборкам данных, которые могут быть компактно выражены в понятной человеку форме. Поиск шаблонов производится методами, не ограниченными рамками априорных предположений о структуре выборке и виде распределений значений анализируемых показателей. Примеры заданий на такой поиск при использовании Data Mining приведены в табл. 1.

Важное положение Data Mining — нетривиальность разыскиваемых шаблонов. Это означает, что найденные шаблоны должны отражать неочевидные, неожиданные (unexpected) регулярности в данных, составляющие так называемые скрытые знания (hidden knowledge). К обществу пришло понимание, что сырые данные (raw data) содержат глубинный пласт знаний, при грамотной раскопке которого могут быть обнаружены настоящие самородки (рис.1).

Рисунок 1. Уровни знаний, извлекаемых из данных

В целом технологию Data Mining достаточно точно определяет Григорий Пиатецкий-Шапиро — один из основателей этого направления:

Data Mining — это процесс обнаружения в сырых данных ранее неизвестных, нетривиальных, практически полезных и доступных интерпретации знаний, необходимых для принятия решений в различных сферах человеческой деятельности.

2. Кому это нужно?

Сфера применения Data Mining ничем не ограничена — она везде, где имеются какие-либо данные. Но в первую очередь методы Data Mining сегодня, мягко говоря, заинтриговали коммерческие предприятия, развертывающие проекты на основе информационных хранилищ данных (Data Warehousing). Опыт многих таких предприятий показывает, что отдача от использования Data Mining может достигать 1000%. Например, известны сообщения об экономическом эффекте, в 10–70 раз превысившем первоначальные затраты от 350 до 750 тыс. дол. [3]. Известны сведения о проекте в 20 млн. дол., который окупился всего за 4 месяца. Другой пример — годовая экономия 700 тыс. дол. за счет внедрения Data Mining в сети универсамов в Великобритании.

Data Mining представляют большую ценность для руководителей и аналитиков в их повседневной деятельности. Деловые люди осознали, что с помощью методов Data Mining они могут получить ощутимые преимущества в конкурентной борьбе. Кратко охарактеризуем некоторые возможные бизнес-приложения Data Mining [2].

ИЛИ

Что такое Data Mining

Корпоративная база данных любого современного предприятия обычно содержит набор таблиц, хранящих записи о тех или иных фактах либо объектах (например, о товарах, их продажах, клиентах, счетах). Как правило, каждая запись в подобной таблице описывает какой-то конкретный объект или факт. Например, запись в таблице продаж отражает тот факт, что такой-то товар продан такому-то клиенту тогда-то таким-то менеджером, и по большому счету ничего, кроме этих сведений, не содержит. Однако совокупность большого количества таких записей, накопленных за несколько лет, может стать источником дополнительной, гораздо более ценной информации, которую нельзя получить на основе одной конкретной записи, а именно — сведений о закономерностях, тенденциях или взаимозависимостях между какими-либо данными. Примерами подобной информации являются сведения о том, как зависят продажи определенного товара от дня недели, времени суток или времени года, какие категории покупателей чаще всего приобретают тот или иной товар, какая часть покупателей одного конкретного товара приобретает другой конкретный товар, какая категория клиентов чаще всего вовремя не отдает предоставленный кредит.

Подобного рода информация обычно используется при прогнозировании, стратегическом планировании, анализе рисков, и ценность ее для предприятия очень высока. Видимо, поэтому процесс ее поиска и получил название Data Mining (mining по-английски означает «добыча полезных ископаемых», а поиск закономерностей в огромном наборе фактических данных действительно сродни этому). Термин Data Mining обозначает не столько конкретную технологию, сколько сам процесс поиска корреляций, тенденций, взаимосвязей и закономерностей посредством различных математических и статистических алгоритмов: кластеризации, создания субвыборок, регрессионного и корреляционного анализа. Цель этого поиска — представить данные в виде, четко отражающем бизнес-процессы, а также построить модель, при помощи которой можно прогнозировать процессы, критичные для планирования бизнеса (например, динамику спроса на те или иные товары или услуги либо зависимость их приобретения от каких-то характеристик потребителя).

Отметим, что традиционная математическая статистика, долгое время остававшаяся основным инструментом анализа данных, равно как и средства оперативной аналитической обработки данных (online analytical processing, OLAP), о которых мы уже неоднократно писали (см. материалы на эту тему на нашем компакт-диске), не всегда могут успешно применяться для решения таких задач. Обычно статистические методы и OLAP используются для проверки заранее сформулированных гипотез. Однако нередко именно формулировка гипотезы оказывается самой сложной задачей при реализации бизнес-анализа для последующего принятия решений, поскольку далеко не все закономерности в данных очевидны с первого взгляда.

В основу современной технологии Data Mining положена концепция шаблонов, отражающих закономерности, свойственные подвыборкам данных. Поиск шаблонов производится методами, не использующими никаких априорных предположений об этих подвыборках. Если при статистическом анализе или при применении OLAP обычно формулируются вопросы типа «Каково среднее число неоплаченных счетов заказчиками данной услуги?», то применение Data Mining, как правило, то подразумевает ответы на вопросы типа «Существует ли типичная категория клиентов, не оплачивающих счета?». При этом именно ответ на второй вопрос нередко обеспечивает более нетривиальный подход к маркетинговой политике и к организации работы с клиентами.

Важной особенностью Data Mining является нестандартность и неочевидность разыскиваемых шаблонов. Иными словами, средства Data Mining отличаются от инструментов статистической обработки данных и средств OLAP тем, что вместо проверки заранее предполагаемых пользователями взаимозависимостей они на основании имеющихся данных способны находить такие взаимозависимости самостоятельно и строить гипотезы об их характере.

Следует отметить, что применение средств Data Mining не исключает использования статистических инструментов и OLAP-средств, поскольку результаты обработки данных с помощью последних, как правило, способствуют лучшему пониманию характера закономерностей, которые следует искать.

Исходные данные для Data Mining

Применение Data Mining оправданно при наличии достаточно большого количества данных, в идеале — содержащихся в корректно спроектированном хранилище данных (собственно, сами хранилища данных обычно создаются для решения задач анализа и прогнозирования, связанных с поддержкой принятия решений). О принципах построения хранилищ данных мы также неоднократно писали; соответствующие материалы можно найти на нашем компакт-диске, поэтому на этом вопросе мы останавливаться не будем. Напомним лишь, что данные в хранилище представляют собой пополняемый набор, единый для всего предприятия и позволяющий восстановить картину его деятельности на любой момент времени. Отметим также, что структура данных хранилища проектируется таким образом, чтобы выполнение запросов к нему осуществлялось максимально эффективно. Впрочем, существуют средства Data Mining, способные выполнять поиск закономерностей, корреляций и тенденций не только в хранилищах данных, но и в OLAP-кубах, то есть в наборах предварительно обработанных статистических данных.

Типы закономерностей, выявляемых методами Data Mining

Cогласно В.А.Дюку [1], выделяют пять стандартных типов закономерностей, выявляемых методами Data Mining:

ассоциация — высокая вероятность связи событий друг с другом (например, один товар часто приобретается вместе с другим);

последовательность — высокая вероятность цепочки связанных во времени событий (например, в течение определенного срока после приобретения одного товара будет с высокой степенью вероятности приобретен другой);

классификация — имеются признаки, характеризующие группу, к которой принадлежит то или иное событие или объект (обычно при этом на основании анализа уже классифицированных событий формулируются некие правила);

кластеризация — закономерность, сходная с классификацией и отличающаяся от нее тем, что сами группы при этом не заданы — они выявляются автоматически в процессе обработки данных;

временные закономерности — наличие шаблонов в динамике поведения тех или иных данных (типичный пример — сезонные колебания спроса на те или иные товары либо услуги), используемых для прогнозирования.

Методы исследования данных в Data Mining

Cегодня существует довольно большое количество разнообразных методов исследования данных. Основываясь на вышеуказанной классификации, предложенной В.А.Дюком, среди них можно выделить:

· регрессионный, дисперсионный и корреляционный анализ (реализован в большинстве современных статистических пакетов, в частности в продуктах компаний SAS Institute, StatSoft и др.);

· методы анализа в конкретной предметной области, базирующиеся на эмпирических моделях (часто применяются, например, в недорогих средствах финансового анализа);

· нейросетевые алгоритмы, идея которых основана на аналогии с функционированием нервной ткани и заключается в том, что исходные параметры рассматриваются как сигналы, преобразующиеся в соответствии с имеющимися связями между «нейронами», а в качестве ответа, являющегося результатом анализа, рассматривается отклик всей сети на исходные данные. Связи в этом случае создаются с помощью так называемого обучения сети посредством выборки большого объема, содержащей как исходные данные, так и правильные ответы;

· алгоритмы — выбор близкого аналога исходных данных из уже имеющихся исторических данных. Называются также методом «ближайшего соседа»;

· деревья решений — иерархическая структура, базирующаяся на наборе вопросов, подразумевающих ответ «Да» или «Нет»; несмотря на то, что данный способ обработки данных далеко не всегда идеально находит существующие закономерности, он довольно часто используется в системах прогнозирования в силу наглядности получаемого ответа;

· кластерные модели (иногда также называемые моделями сегментации) применяются для объединения сходных событий в группы на основании сходных значений нескольких полей в наборе данных; также весьма популярны при создании систем прогнозирования;

· алгоритмы ограниченного перебора, вычисляющие частоты комбинаций простых логических событий в подгруппах данных;

· эволюционное программирование — поиск и генерация алгоритма, выражающего взаимозависимость данных, на основании изначально заданного алгоритма, модифицируемого в процессе поиска; иногда поиск взаимозависимостей осуществляется среди каких-либо определенных видов функций (например, полиномов).

Подробнее об этих и других алгоритмах Data Mining, а также о реализующих их средствах можно прочесть в книге «Data Mining: учебный курс» В.А.Дюка и А.П.Самойленко, выпущенной издательством «Питер» в 2001 году [2]. Сегодня это одна из немногих книг на русском языке, посвященная данной проблеме.

Ведущие производители средств Data Mining

Средства Data Mining, как и большинство средств Business Intelligence, традиционно относятся к дорогостоящим программным инструментам — цена некоторых из них доходит до нескольких десятков тысяч долларов. Поэтому до недавнего времени основными потребителями этой технологии были банки, финансовые и страховые компании, крупные торговые предприятия, а основными задачами, требующими применения Data Mining, считались оценка кредитных и страховых рисков и выработка маркетинговой политики, тарифных планов и иных принципов работы с клиентами. В последние годы ситуация претерпела определенные изменения: на рынке программного обеспечения появились относительно недорогие инструменты Data Mining от нескольких производителей, что сделало доступной эту технологию для предприятий малого и среднего бизнеса, ранее о ней и не помышлявших.

К современным средствам Business Intelligence относятся генераторы отчетов, средства аналитической обработки данных, средства разработки BI-решений (BI Platforms) и так называемые Enterprise BI Suites — средства анализа и обработки данных масштаба предприятия, которые позволяют осуществлять комплекс действий, связанных с анализом данных и с созданием отчетов, и нередко включают интегрированный набор BI-инструментов и средства разработки BI-приложений. Последние, как правило, содержат в своем составе и средства построения отчетов, и OLAP-средства, а нередко — и Data Mining-средства.

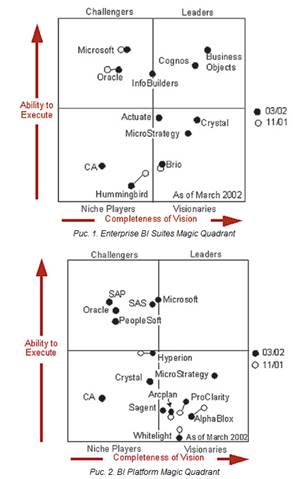

По данным аналитиков Gartner Group, лидерами на рынке средств анализа и обработки данных масштаба предприятия являются компании Business Objects, Cognos, Information Builders, а претендуют на лидерство также Microsoft и Oracle (рис. 1). Что касается средств разработки BI-решений, то основными претендентами на лидерство в этой области являются компании Microsoft и SAS Institute (рис. 2).

Отметим, что средства Business Intelligence компании Microsoft относятся к сравнительно недорогим продуктам, доступным широкому кругу компаний. Именно поэтому мы и собираемся рассмотреть некоторые практические аспекты применения Data Mining на примере продуктов этой компании в последующих частях данной статьи.

12. КИС производственных предприятий. Классификация производственных систем (по подробнее у Белова)

Корпоративная информационная система (КИС)– это программно-аппаратный комплекс, предназначенный для обеспечения основных бизнес-процессов компании (корпорации).

Синонимы– АСУП, ИС, ИУСП и т.п.

Особенности КИС:

a. В состав КИС могут входить программные и аппаратные средства

b. Сбор, хранение, анализ информации о деятельности компании-выработка управляющих воздействий/управленческих решений

c. КИС – автоматизируемые бизнес-процессы

d. Объект автоматизации – предприятие, компания, корпорация, …(Entreprise…)

Производственные системы (также называемые системами производственного управления) включают подклассы средних и крупных интегрированных систем. Они предназначены в первую очередь для управления и планирования производственного процесса. Учетные функции, хотя и глубоко проработаны, играют вспомогательную роль, и порой невозможно выделить модуль бухгалтерского учета, так как информация в бухгалтерию поступает автоматически из других модулей.

Эти системы функционально различны: в одной может быть хорошо развит производственный модуль, в другой - финансовый. Сравнительный анализ систем такого уровня и их применимости к конкретному случаю может вылиться в значительную работу. А для внедрения системы нужна целая команда из финансовых, управленческих и технических экспертов. Производственные системы значительно более сложны в установке (цикл внедрения может занимать от 6 - 9 месяцев до полутора лет и более). Это обусловлено тем, что система покрывает потребности всего предприятия, и это требует значительных совместных усилий сотрудников предприятия и поставщиков программ.

Производственные системы часто ориентированы на одну или несколько отраслей и/или типов производства: серийное сборочное (электроника, машиностроение), мелкосерийное и опытное (авиация, тяжелое машиностроение), дискретное (металлургия, химия, упаковка), непрерывное (нефтедобыча, газодобыча).

Специализация отражается как в наборе функций системы, так и в существовании бизнес - моделей данного типа производства. Наличие встроенных моделей для определенного типа производства отличает производственные системы друг от друга. У каждой из них есть глубоко проработанные направления и функции, разработка которых только начинается или вообще не ведется.

Производственные системы по многим параметрам значительно более жестки, чем финансово-управленческие. Основное внимание уделяется

планированию и оптимальному управлению производством. Эффект от внедрения производственных систем проявляется на верхних эшелонах управления предприятием, когда становится видна вся картина его работы, включая планирование, закупки, производство, сбыт, запасы, финансовые потоки и другие аспекты.

При увеличении сложности и широты охвата функций предприятия системой возрастают требования к технической инфраструктуре и программно-технической платформе. Все производственные системы разработаны с помощью промышленных баз данных. В большинстве случаев используются технология клиент-сервер или Internet-технологии.

Для автоматизации больших предприятий в мировой практике часто используется смешанное решение из классов крупных, средних и малых интегрированных систем. Наличие электронных интерфейсов упрощает взаимодействие между системами и позволяет избежать двойного ввода данных.

13. Системы класса ERP. Функциональность ERP-систем.

(по Белову)

ERP-система (Enterprise Resource Planning) –система планирования ресурсов. Происходит на уровне предприятия в целом или его компанентов. Такие предприятия имеют:

1)территориально распределенную стрктуру(нефтяные, металлургические предприятия)

2)гетерогенность – разноровность предприятий(холдинговые структуры)

3)централизированное управление-управление финансовыми потоками в основном

Функциональность ERP довольно большая. Функции управления ресурсами предприятия-основная.

(из Инета)

Внедрение

Классические ERP-системы, в отличие от так называемого «коробочного» программного обеспечения, относятся к категории «тяжелых» заказных программных продуктов, их выбор, приобретение и внедрение, как правило, требуют тщательного планирования в рамках длительного проекта с участием партнерской компании — поставщика или консультанта. Поскольку КИС строятся по модульному принципу, заказчик часто (по крайней мере, на ранней стадии таких проектов) приобретает не полный спектр модулей, а ограниченный их комплект. В ходе внедрения проектная команда, как правило, в течение нескольких месяцев осуществляет настройку поставляемых модулей.

Достоинства

Использование ERP системы позволяет использовать одну интегрированную программу вместо нескольких разрозненных. Единая система может управлять обработкой, логистикой, дистрибуцией, запасами, доставкой, выставлением счёт-фактур и бухгалтерским учётом.

Единая! система безопасности, включенная в ERP, позволяет противостоять как внешним угрозам (например, промышленный шпионаж), так и внутренним (например, хищения). Совместно в связке с CRM-системой и системой контроля качества, ERP позволяют максимально удовлетворять потребности клиентов.

Недостатки

Множество проблем, связанных с ERP, возникают из-за недостаточного инвестирования в обучение персонала, а также в связи с недоработанностью политики занесения и поддержки актуальности данных в ERP...

Ограничения:

Небольшие компании не могут позволить себе инвестировать достаточно денег в ERP и адекватно обучить всех сотрудников.

Внедрение может оказаться очень дорогим.

Иногда ERP сложно или невозможно адаптировать под документооборот компании и ее специфические бизнес-процессы.

Система может страдать от проблемы "слабого звена" -- эффективность всей системы может быть нарушена одним департаментом или партнером.

Сопротивление департаментов в предоставлении конфиденциальной информации уменьшает эффективность системы.

Проблема совместимости с прежними системами.